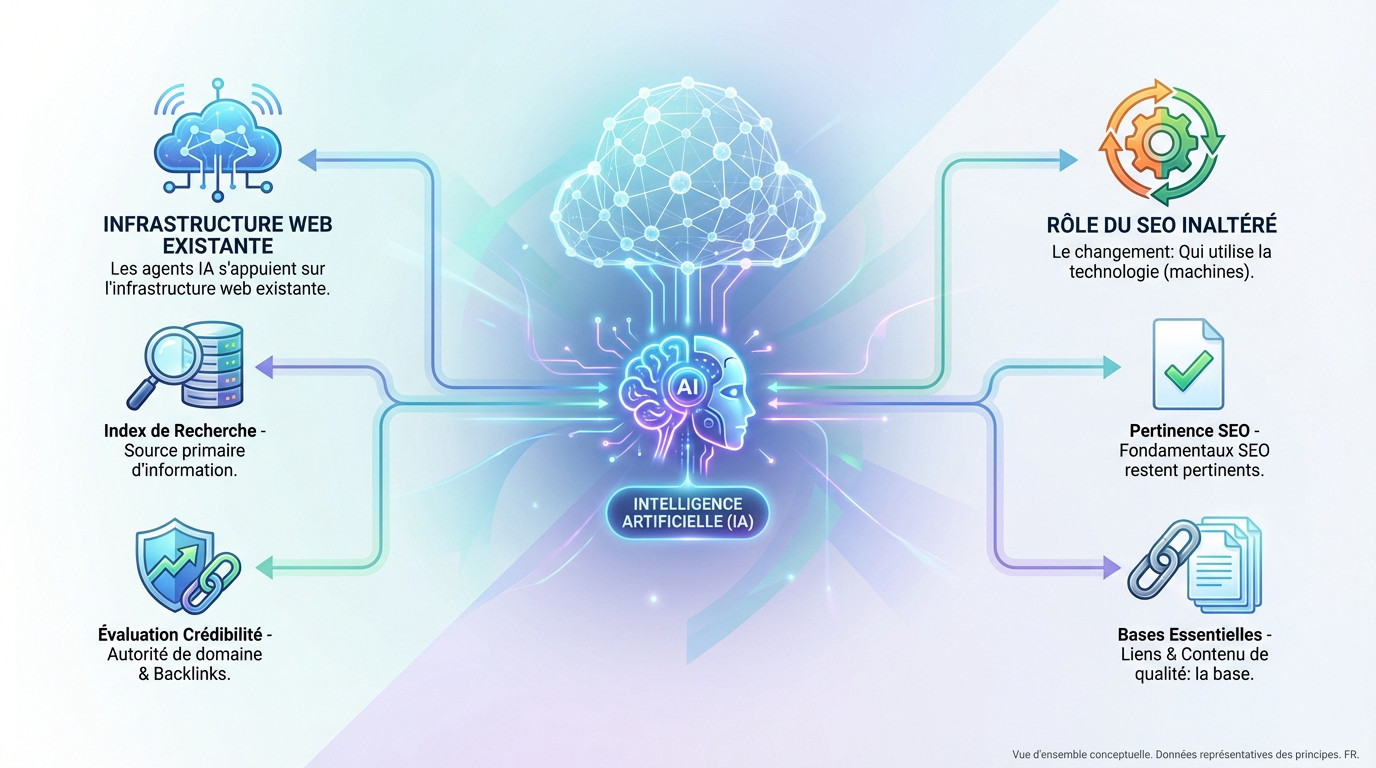

L’essentiel à retenir : les agents IA exploitent l’infrastructure web actuelle, renforçant la nécessité des fondamentaux SEO. La stratégie consiste à structurer le contenu comme un briefing organisé pour les machines, favorisant ainsi le parsing des données. Cette méthode optimise la visibilité sur les requêtes de longue traîne grâce à une densité sémantique accrue. Pour en savoir plus: Contactez- nous!

L’indexation par les seo agents ia remet en question la pertinence technique des stratégies actuelles de référencement naturel. James LePage, expert chez WordPress, démontre pourtant que l’infrastructure web existante constitue toujours la source primaire d’information pour ces systèmes autonomes. Ce dossier détaille les méthodes de structuration de données et de densité sémantique requises pour convertir un contenu en un briefing intelligible pour les machines.

Les agents IA ne réinventent pas la roue : ils utilisent la vôtre

L’infrastructure web existante : le terrain de jeu des IA

James LePage de WordPress confirme une réalité souvent ignorée : le seo agents ia ne fonctionne pas dans le vide. Ils s’appuient concrètement sur l’infrastructure web que nous connaissons déjà.

Sachez que les index de recherche restent leur source première et incontournable pour découvrir des entités.

Ils évaluent la crédibilité avec des signaux éprouvés. Ils utilisent l’autorité de domaine et les liens entrants pour jauger la fiabilité d’une source, exactement comme le font les moteurs de recherche traditionnels.

Le rôle inaltéré des fondamentaux SEO

Le bouleversement n’est pas technologique, mais structurel. La différence majeure réside dans qui l’utilise : ce sont désormais des machines autonomes qui parcourent les données.

Le changement principal réside dans qui effectue la traversée de ces données. Les fondamentaux du SEO restent pertinents car les agents IA utilisent l’infrastructure web existante.

Les liens permettent de naviguer entre les entités, et le contenu explique ce que chaque entité propose. C’est une confirmation que les bases du SEO ne sont pas obsolètes.

Optimiser pour les IA : le grand retour de la longue traîne

Puisque les bases ne changent pas, qu’est-ce qui évolue réellement ? La réponse se trouve dans la précision des requêtes.

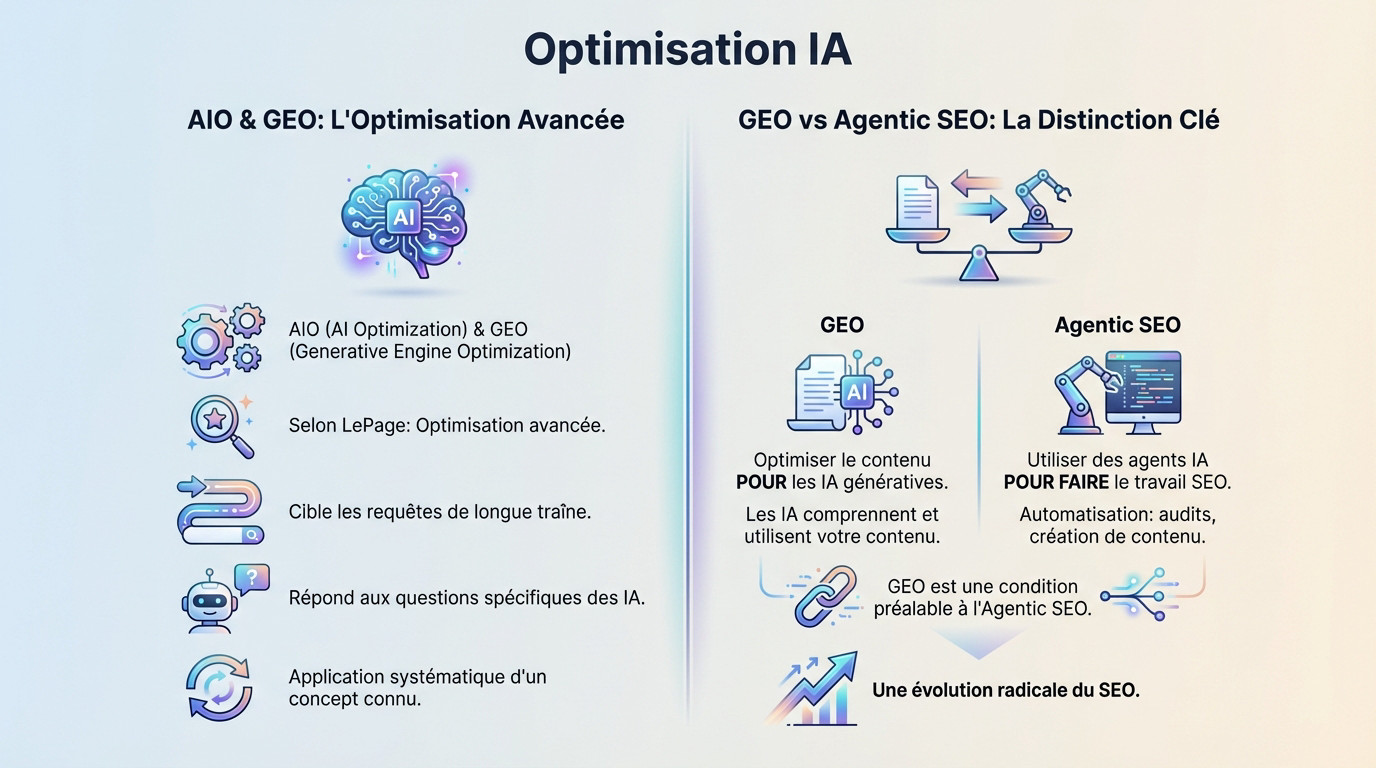

AIO et GEO : des noms pour un concept connu

Les acronymes AIO et GEO saturent les discussions techniques actuelles. Pour James LePage, il ne s’agit pourtant que d’une optimisation avancée des standards existants, sans magie technologique cachée.

Cette stratégie se focalise désormais sur les requêtes de longue traîne. Dans le contexte seo agents ia, les machines traitent des questions contextuelles complexes, ignorant les mots-clés génériques.

Cette approche n’est pas nouvelle, mais son application devient systématique et rigoureuse. L’objectif final est de répondre avec précision à des questions techniques que seule une machine pourrait formuler pour ses utilisateurs.

La distinction nécessaire : GEO vs Agentic SEO

Une confusion fréquente persiste entre deux notions pourtant distinctes. Le GEO et l’Agentic SEO ne renvoient pas aux mêmes mécaniques opérationnelles.

- Le GEO (Generative Engine Optimization) : Vise à structurer le contenu POUR que les IA génératives l’assimilent. C’est le point central soulevé par LePage.

- L’Agentic SEO : Implique l’usage d’agents autonomes POUR FAIRE le travail d’optimisation. Cela concerne l’automatisation des tâches.

Bien que distincts, ces deux concepts demeurent techniquement liés. Pour exécuter un Agentic SEO performant, il faut d’abord comprendre les mécanismes du GEO. C’est une évolution radicale du SEO qui s’impose aux éditeurs de sites.

Structurer son contenu comme un briefing pour une machine

De la « pile de documents » au « briefing organisé »

James LePage utilise une métaphore frappante pour décrire l’analyse par l’IA. Un site mal structuré n’est qu’une pile de documents chaotique pour un algorithme. L’IA peine à y trouver du sens.

Un contenu optimisé pour un agent IA ressemble à un briefing bien organisé, tandis qu’un contenu non optimisé s’apparente à une simple pile de documents.

L’objectif est que la donnée soit organisée de manière intentionnelle. Il faut mâcher le travail de structuration pour le système. L’analyse par la machine devient alors instantanée et sans erreur.

Les piliers d’un contenu lisible par l’IA

L’optimisation repose sur trois fondamentaux techniques indissociables pour garantir la compréhension par les agents.

- Données structurées (Schema.org) : Le balisage définit explicitement les entités, qu’il s’agisse d’un produit ou d’une personne.

- Densité sémantique : Un vocabulaire riche et précis ancre le sujet pour créer un contexte sans ambiguïté.

- Maillage interne solide : Les liens logiques clarifient les relations entre les différents concepts abordés sur le site.

Ce ne sont plus des options pour le seo agents ia, mais des prérequis techniques stricts. Sans cette rigueur, le contenu disparaît des réponses générées. Suivre ces conseils SEO pour 2026 est une nécessité.

La divulgation progressive : penser en résumé d’abord

Le concept de divulgation progressive exige de livrer le résumé avant les détails. L’information prioritaire s’affiche immédiatement. La profondeur technique vient dans un second temps.

Cela impose des introductions synthétiques et un balisage sémantique strict. Les titres et le gras permettent de hiérarchiser l’information efficacement. L’agent comprend ainsi la structure logique du document.

L’avenir à court terme : le contenu statique reste roi

Malgré ces évolutions technologiques, il ne faut pas céder aux spéculations futuristes. La stratégie à adopter aujourd’hui reste pragmatique.

Pas de communication directe entre agents… pour l’instant

James LePage envisage une vision à long terme où les agents communiquent via des API. Ce scénario ne remplace pas l’existant immédiatement. Les visites de sites web traditionnels ne vont pas disparaître demain.

Le contenu statique demeure la ressource pivot sur l’infrastructure actuelle. Les éditeurs doivent optimiser cette base technique. Elle constitue l’unique point d’accès fiable pour les assistants IA qui seront la norme en 2026. Une stratégie seo agents ia efficace commence ici.

WordPress et les agents IA : un écosystème en préparation

La prise de parole du co-responsable de l’équipe IA de WordPress est un signal fort. Elle indique une direction claire pour le CMS le plus utilisé. L’écosystème s’aligne sur cette réalité technique.

La priorité consiste à rendre les contenus parfaitement « parsables » par les systèmes IA. La clarté, la structure et la richesse sémantique deviennent les maîtres-mots. L’information doit être organisée comme un briefing précis.

Des solutions d’orchestration avancées apparaissent déjà en open-source. Le projet `wshobson/agents` disponible sur GitHub en témoigne. Cette architecture à trois niveaux traite des tâches spécifiques, incluant le référencement.

L’optimisation pour les agents IA ne remplace pas le SEO traditionnel, elle l’intensifie. L’infrastructure web demeure le socle technique indispensable pour ces nouveaux systèmes. Les éditeurs doivent désormais structurer rigoureusement les données et densifier la sémantique. Transformer le contenu en un briefing clair pour les LLMs garantit la visibilité dans cet écosystème émergent.

FAQ

Comment les agents IA accèdent-ils aux informations sur le web ?

Les agents d’intelligence artificielle ne créent pas une nouvelle infrastructure de navigation. Ils exploitent le web existant, en s’appuyant principalement sur les index de recherche classiques pour découvrir des contenus.

Pour évaluer la pertinence d’une information, ces systèmes analysent l’autorité de domaine et les liens entrants (backlinks). Le fonctionnement technique reste donc très proche de celui des moteurs de recherche traditionnels.

Quelle est la différence entre le GEO et l’Agentic SEO ?

Le GEO (Generative Engine Optimization) désigne l’optimisation des contenus pour qu’ils soient compris et restitués par les IA génératives. L’objectif est d’apparaître dans les réponses synthétisées par les modèles de langage.

L’Agentic SEO, quant à lui, réfère à l’utilisation d’agents IA pour automatiser les tâches de référencement. Il s’agit d’une méthode d’exécution du travail SEO (audits, rédaction) et non d’une technique d’optimisation de page.

Pourquoi les requêtes de longue traîne sont-elles cruciales pour l’IA ?

Les agents IA formulent des requêtes complexes et précises, contrairement aux recherches humaines par mots-clés courts. La longue traîne permet de répondre exactement à cette granularité et à l’intention de recherche spécifique.

Une stratégie axée sur ces requêtes détaillées s’aligne avec le mode de fonctionnement conversationnel des LLM. Cela garantit une meilleure pertinence sémantique pour les réponses générées par la machine.

Comment structurer son contenu pour qu’il soit lisible par une IA ?

Le contenu doit être organisé comme un briefing structuré plutôt que comme une simple accumulation de textes. L’utilisation de données structurées (Schema.org) est indispensable pour définir explicitement les entités.

Il est également nécessaire d’assurer une forte densité sémantique et un maillage interne logique. Une hiérarchisation claire, avec l’essentiel en début de section, facilite l’analyse et l’extraction par les algorithmes.

Les agents IA rendent-ils les sites web traditionnels obsolètes ?

Non, les sites web restent indispensables car les agents IA ne communiquent pas encore directement entre eux via des API. Le contenu statique demeure la source principale d’information pour alimenter ces systèmes.

L’infrastructure web actuelle sert de base de connaissances pour les assistants intelligents. L’optimisation des pages web est donc la condition sine qua non pour exister dans les réponses des futures interfaces.