L’essentiel à retenir : Google pénalise désormais massivement les « listicles » auto-promotionnels classant l’éditeur en première position. Cette pratique, couplée à des mises à jour de titres artificielles, a provoqué des chutes de trafic de 30 % à 50 % chez les acteurs SaaS début 2026. L’authenticité technique devient indispensable pour maintenir sa visibilité.

La chute de visibilité observée chez les marques SaaS indique que les « listicles » auto-promotionnels constituent désormais un signal négatif majeur pour les algorithmes. Cette analyse technique détaille comment l’absence de tests indépendants dans les classements « best of » provoque ces déclassements massifs depuis le début de l’année 2026. L’identification précise des critères de confiance manquants offre ici une méthode concrète pour rétablir la légitimité des pages comparatives aux yeux du moteur de recherche.

Impact des « listicles » auto-promotionnels sur la visibilité en 2026

Chute de trafic organique pour les marques SaaS

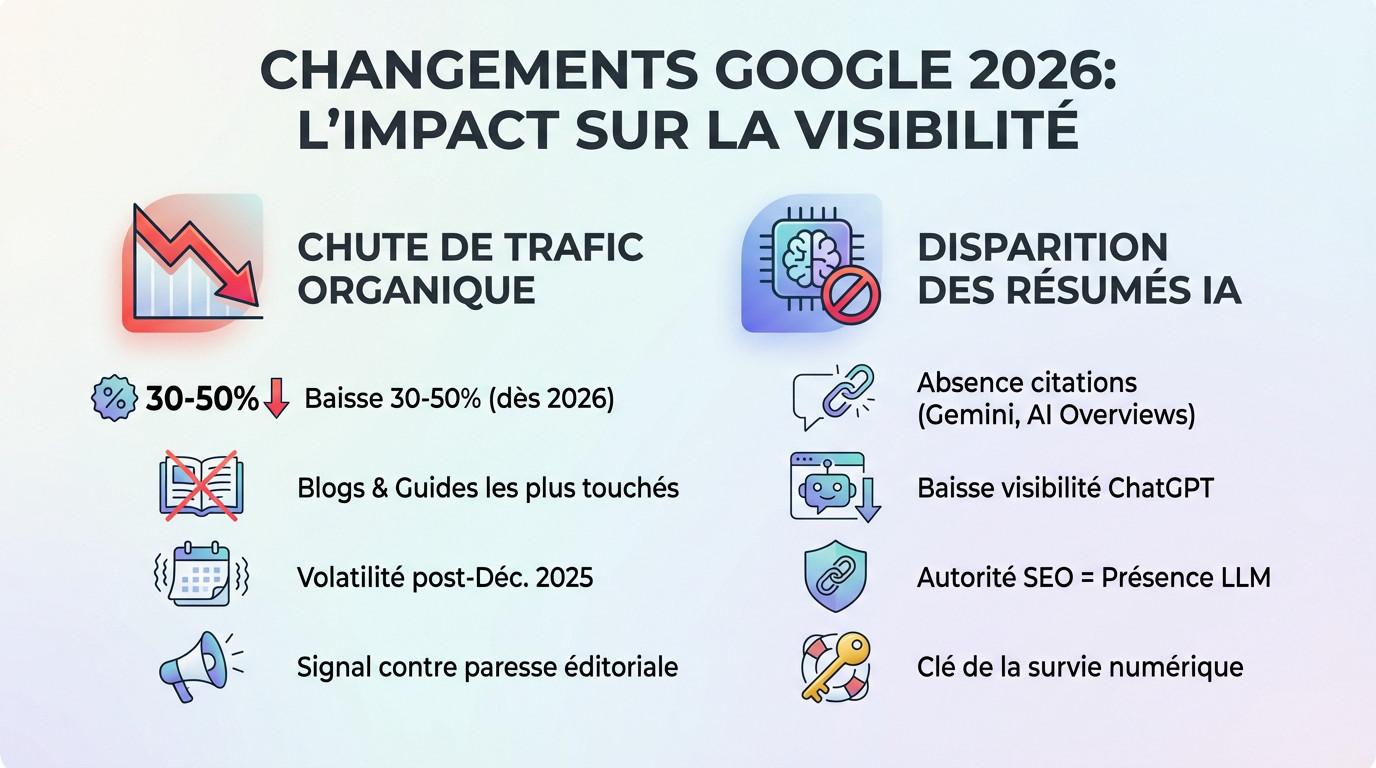

Les données rapportées par Lily Ray révèlent une correction sévère pour le secteur. Dès le début de l’année 2026, de nombreuses marques ont subi des baisses de visibilité massives, atteignant 30 % à 50 %. Ce recul brutal sanctionne les pratiques antérieures.

Les algorithmes ciblent spécifiquement les sous-dossiers hébergeant blogs et guides comparatifs. Ces zones, autrefois piliers du trafic entrant, sont aujourd’hui lourdement pénalisées en raison de leur manque de neutralité. Google nettoie activement ces segments de contenu.

Cette instabilité prolonge la forte volatilité observée suite à la mise à jour majeure de décembre 2025. Le classement fluctue violemment.

La chute n’est pas un accident de parcours, c’est un signal clair envoyé par Google contre la paresse éditoriale.

Répercussions sur les réponses générées par l’IA

L’absence de citations dans Gemini et les AI Overviews découle directement de cette perte de positions. Lorsqu’une page disparaît des premiers résultats de recherche, elle est mécaniquement exclue des résumés générés par l’IA. L’invisibilité devient systémique.

Cette baisse de visibilité touche également les réponses fournies par ChatGPT. Les modèles de langage s’appuient sur l’autorité organique détectée par les moteurs pour sourcer et valider leurs informations. Sans classement, la source s’éteint.

Il est utile de comprendre Pourquoi Google Search reste dominant face aux recherches par IA dans ce contexte précis. Cela explique la mécanique de citation.

L’autorité SEO classique détermine désormais la présence au sein des LLM. C’est une question de survie numérique pour les marques qui dépendent de la recommandation. La sanction algorithmique isole totalement le contenu.

Analyse des tactiques d’auto-classement sanctionnées

Le problème du classement numéro 1 systématique

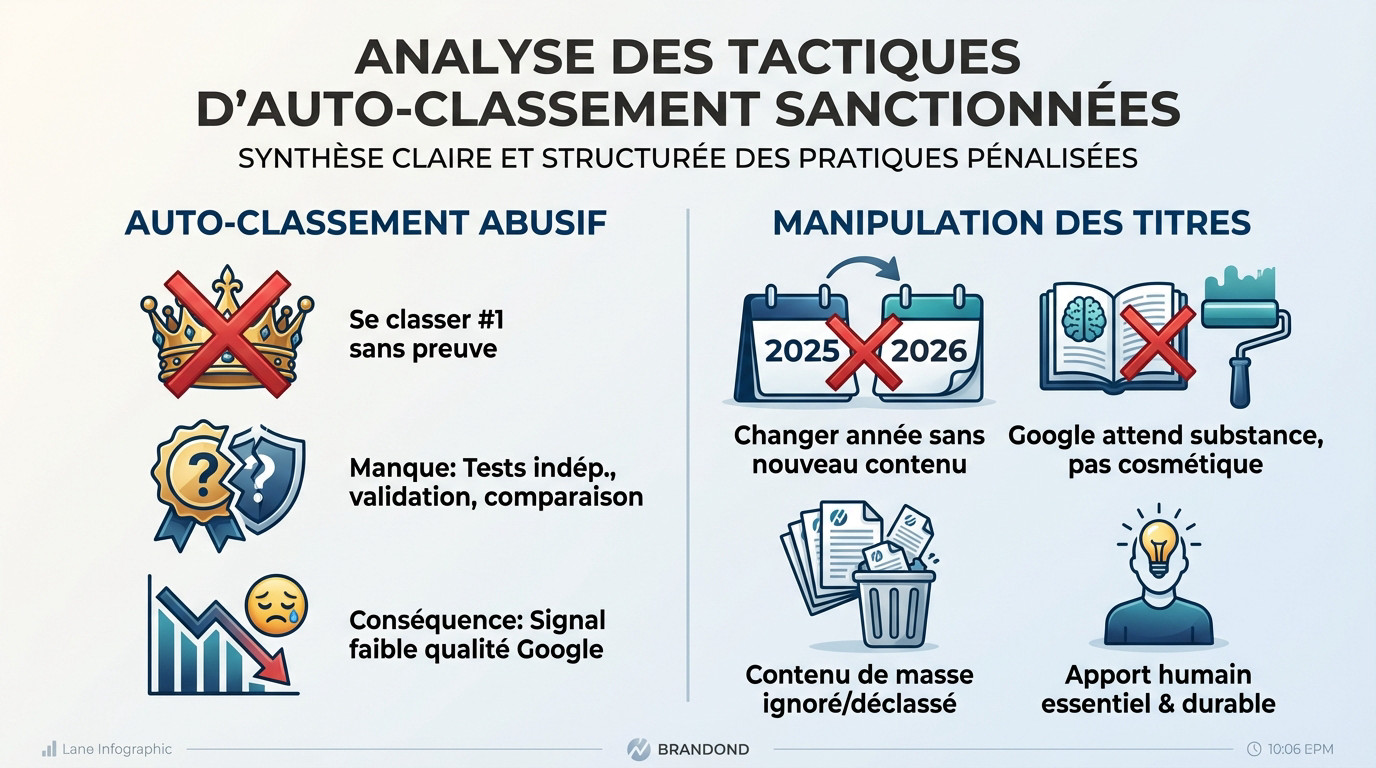

Les éditeurs de logiciels placent systématiquement leur propre solution en tête des classements « meilleurs outils ». Cette pratique, surnommée le syndrome du « meilleur outil », s’opère souvent sans aucune gêne ni justification objective.

Cette méthode soulève plusieurs problèmes majeurs :

- Absence totale de tests indépendants.

- Manque flagrant de validation externe par des tiers de confiance.

- Biais promotionnels évidents faussant la neutralité du comparatif.

- Inexistence de comparaisons techniques avec des concurrents réels.

Face à ces abus, Google durcit ses règles contre les contenus trompeurs pour assainir les résultats de recherche.

Le manque de transparence éditoriale constitue désormais un signal négatif majeur. Google identifie ces biais comme des indicateurs de faible qualité pour l’expérience utilisateur.

Manipulation des signaux de fraîcheur par les titres

Modifier simplement « 2025 » par « 2026 » dans le titre est une technique obsolète. Cette tactique de rafraîchissement superficiel, sans modification du fond, est désormais détectée et sanctionnée par les algorithmes.

Il faut distinguer la mise à jour cosmétique de la véritable valeur éditoriale. Le moteur de recherche exige de la substance et des informations actualisées, pas un simple coup de peinture.

La production de contenu à l’échelle industrielle présente des risques élevés. Ces articles générés en masse finissent souvent par être ignorés ou sévèrement déclassés.

L’apport humain reste indispensable pour garantir la crédibilité. L’expertise réelle prime sur les astuces techniques, car la triche ne paie plus sur le long terme face aux systèmes d’IA.

Enjeux stratégiques et critères de confiance E-E-A-T

Preuves d’expérience directe et évaluation objective

Google ne croit plus personne sur parole aujourd’hui. Il exige des captures d’écran originales prouvant votre utilisation réelle de l’outil testé. Les images génériques ne suffisent plus pour convaincre l’algorithme actuel.

Cette exigence transforme radicalement le secteur du référencement.

L’E-E-A-T n’est plus un concept abstrait, c’est une barrière technique qui sépare les experts des simples agrégateurs de contenu.

Les simples rédacteurs sont désormais hors-jeu.

Les opinions subjectives ne pèsent plus rien face aux données brutes. Vous devez fournir des mesures réelles issues de vos propres expérimentations techniques. L’algorithme favorise désormais les analyses basées sur des résultats concrets. La méthodologie employée doit rester totalement transparente.

L’expertise humaine reste irremplaçable pour Google. Elle seule distingue votre travail des flux automatisés.

Transparence éditoriale et gestion des conflits d’intérêts

La confiance repose sur une honnêteté totale concernant vos revenus générés. Vous devez divulguer clairement vos liens d’affiliation et partenariats commerciaux. Cacher ces informations détruit votre crédibilité instantanément.

Pour équilibrer votre propos, intégrez des avis extérieurs variés.

- Avis d’utilisateurs tiers

- Témoignages clients vérifiés

- Contre-arguments sur le produit

- Limites identifiées

Cela prouve votre objectivité éditoriale indiscutable.

Consultez notre ressource pour approfondir ce sujet technique complexe. Lisez le Contenu original expertise Google – Guide complet 2025.

La structuration technique valide votre contenu aux yeux des robots. L’intégration des schémas Review et Product clarifie la nature exacte de votre page. Ces balises confirment que votre avis est structuré et légitime.

Recommandations pour des comparatifs authentiques

Méthodologie de test et structuration des données

Pour éviter les pénalités liées aux « listicles » auto-promotionnels, proposez des matrices de décision. Au lieu de lister 50 outils, concentrez-vous sur 3 solutions avec une analyse ultra-précise.

Expliquez l’intérêt des journaux de modifications (changelogs) pour valider votre fraîcheur. Montrer l’évolution de votre avis au fil des mois prouve que votre contenu vit vraiment. Une simple date changée ne suffit plus.

Définissez des critères d’évaluation reproductibles pour chaque test. Utilisez une méthodologie stricte pour insister sur la rigueur de la méthode employée pour chaque logiciel testé.

La clarté gagne toujours. Un lecteur qui comprend votre logique est un lecteur qui revient.

Maillage interne et signaux d’engagement utilisateur

Vous devez développer des hubs de contenu cohérents. Le maillage interne doit renforcer votre autorité sur une thématique précise plutôt que de s’éparpiller sur tout le site.

Sachez analyser l’impact du temps de lecture réel. Si les gens restent, Google comprend que la page apporte une réelle réponse à leur question. C’est un signal de qualité indéniable.

Ajoutez toujours une biographie d’expert vérifiable. L’auteur doit être identifiable et avoir une légitimité réelle dans le domaine traité.

Pour conclure sur l’aspect humain et technique, l’expertise externe reste souvent décisive. Pour en discuter directement: Contactez- nous! afin d’affiner votre stratégie SEO et votre autorité en ligne dès aujourd’hui.

La répression de l’autopromotion dans les « listicles » par Google impose un retour immédiat à l’authenticité et aux tests techniques prouvés. Les marques doivent désormais privilégier l’expertise E-E-A-T pour reconquérir leurs positions. Cette rigueur éditoriale garantit une autorité durable face aux exigences accrues des algorithmes et des modèles d’intelligence artificielle.