L’essentiel à retenir : le lien externe évolue d’un levier de classement direct vers un signal de confiance et de contexte sémantique. Le contenu prédomine pour satisfaire les moteurs et l’IA générative. Cette transition valorise la pertinence thématique, une étude Ahrefs de 2025 confirmant que les mentions de marque sur YouTube surpassent l’impact des backlinks techniques traditionnels pour la visibilité.

Face à l’evolution liens seo, pourquoi l’accumulation massive de backlinks ne suffit-elle plus à positionner un site durablement dans les résultats de recherche ? Cet article examine le basculement technique des hyperliens, passés de leviers de classement directs à de simples validateurs de confiance et de contexte sémantique pour les moteurs. L’étude détaille le fonctionnement du « Reduced Link Graph » et expose les méthodes concrètes pour aligner l’autorité d’un domaine avec les nouveaux standards de l’intelligence artificielle générative.

Du PageRank à la pertinence : la fin d’une époque pour les liens

L’âge d’or du lien quantitatif

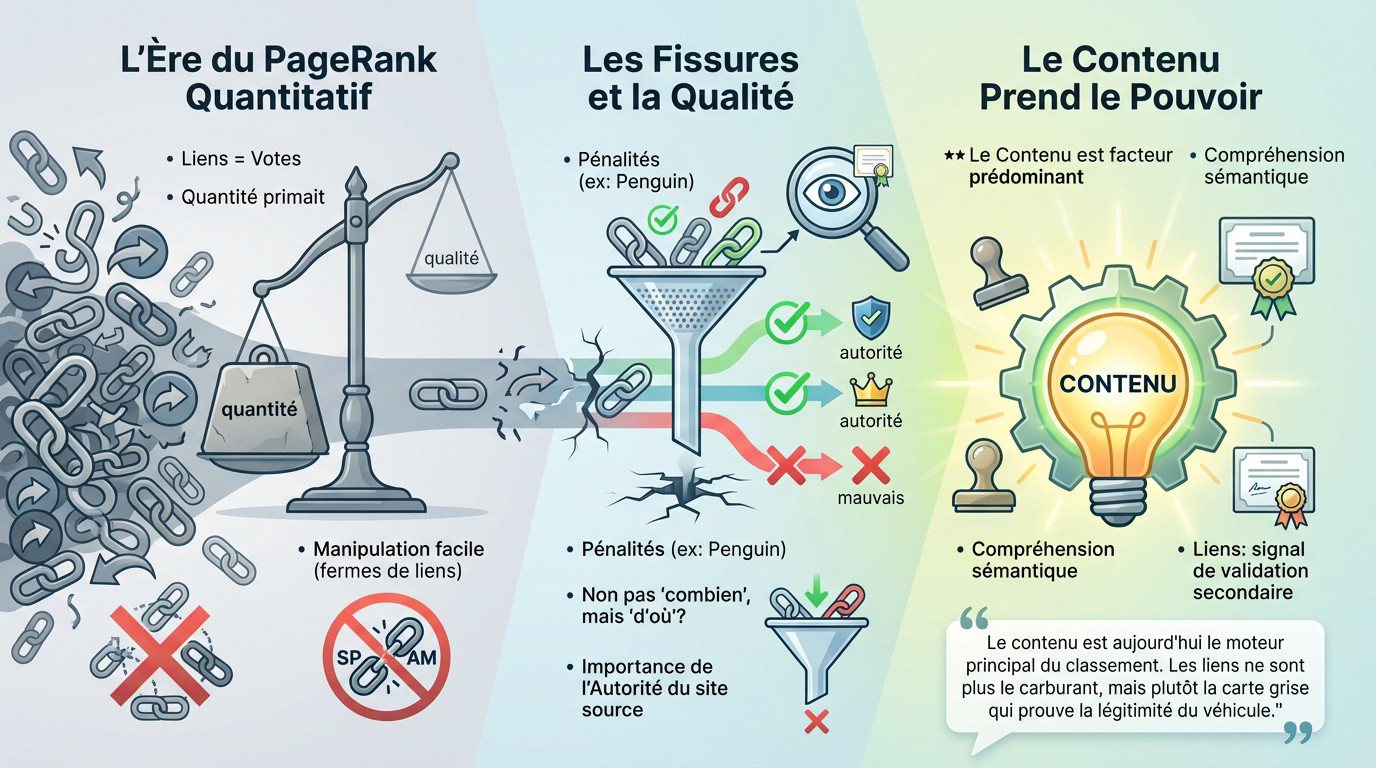

Le PageRank historique dominait le classement. Chaque lien hypertexte fonctionnait comme un vote de confiance binaire. L’algorithme valorisait mécaniquement la quantité de liens entrants, propulsant les sites les plus cités en tête des résultats.

Les fermes de liens ont rapidement exploité cette logique mathématique. Le bourrage de mots-clés accompagnait ces stratégies pour manipuler les scores.

Ce modèle simpliste s’est révélé trop vulnérable aux abus. Les moteurs de recherche ont dû complexifier leurs calculs pour protéger la pertinence. L’objectif a changé : combattre le spam massif. La qualité authentique devait remplacer le volume brut.

Les premières fissures dans le modèle

L’algorithme Google Penguin a sanctionné les pratiques abusives. Cette mise à jour a pénalisé les profils de liens artificiels. Cette evolution liens seo a marqué le début d’une exigence accrue envers la naturalité.

La provenance du lien est devenue le critère déterminant. Le volume ne suffisait plus pour garantir une position. L’autorité du site source déterminait désormais la valeur réelle du vote transmis.

Le système restait toutefois basé sur un transfert de puissance. La notion de contexte sémantique manquait encore de précision. La thématique n’était pas encore le filtre absolu.

Le contenu prend le pouvoir

Le contenu est le facteur de classement prédominant dans l’écosystème actuel. Une page excellente peut aujourd’hui se positionner sans aide extérieure massive. La qualité de l’information et l’expertise priment sur la popularité brute. L’IA analyse la profondeur du texte.

Les moteurs comprennent désormais le sens réel des pages. Ils n’ont plus besoin de signaux externes pour saisir le sujet traité. La sémantique suffit à établir la pertinence.

Le rôle du netlinking a donc muté. Il ne propulse plus, il valide la crédibilité d’un site.

Le contenu est aujourd’hui le moteur principal du classement. Les liens ne sont plus le carburant, mais plutôt la carte grise qui prouve la légitimité du véhicule.

Le lien comme signal de confiance et de contexte

Maintenant que le contenu est roi, à quoi servent encore les liens ? Ils ont endossé un nouveau rôle, plus subtil mais tout aussi déterminant.

La validation thématique avant tout

L’evolution liens seo confirme que l’objectif principal d’un lien est de prouver la fiabilité et la thématique d’un site. Il agit comme un signal de pertinence pour les moteurs, validant l’expertise d’une page.

Une correspondance précise entre la page source et la page de destination est impérative. Un lien provenant d’un site hors-sujet n’a que peu de valeur technique car les algorithmes filtrent ces connexions incohérentes.

La « distance sémantique » devient centrale. Plus les sujets sont proches, plus le signal du lien est fort. C’est le nouveau paradigme de la confiance en référencement.

Le danger des mauvais voisins : liens sortants et réputation

Pointer vers des sites de mauvaise qualité ou du spam peut nuire à la réputation d’un site. Les liens sortants engagent la responsabilité éditoriale de l’émetteur et Google sanctionne ces mauvaises associations.

Un site peut être « empoisonné » par ces mauvaises associations. Il devient alors incapable de transmettre de la valeur ou d’être perçu comme fiable par le moteur.

Les moteurs n’analysent pas seulement qui vous recommande, mais aussi qui vous recommandez. Ils évaluent ainsi votre place dans l’écosystème du web.

Le « Reduced Link Graph » : le club vIP de Google

Le « Reduced Link Graph » permet à Google de filtrer le bruit et le spam. Il ne conserve qu’un réseau central de sites légitimes et fiables, épuré des manipulations artificielles.

L’inclusion dans ce graphe est un prérequis pour la visibilité. Être en dehors signifie être invisible dans les résultats de recherche.

L’objectif moderne est d’obtenir un lien d’un site membre de ce graphe de confiance. Seule cette validation par un pair autorisé compte.

L’impact de l’IA et de la recherche générative (GEO)

Cette transition vers la confiance et le contexte est massivement accélérée par la montée en puissance de l’intelligence artificielle dans la recherche.

Quand l’IA devient le premier lecteur

Les systèmes d’IA, comme ceux alimentant les AI Overviews de Google, s’entraînent directement sur le contenu web existant. Le SEO évolue vers une structuration précise de la connaissance pour les machines.

L’objectif consiste désormais à être cité comme une source fiable dans les réponses générées par l’IA, un principe au cœur du Generative Engine Optimization (GEO).

La fiabilité de la source s’avère donc plus importante que jamais. L’IA doit avoir une confiance totale en votre contenu pour l’utiliser et le citer dans ses synthèses.

Citations et mentions : les nouveaux backlinks ?

Dans cette evolution liens seo, les backlinks traditionnels perdent une partie de leur poids direct. Les mentions de marque […] deviennent des signaux de confiance et de contexte très puissants.

L’étude Ahrefs de 2025 démontre une forte corrélation entre les mentions sur YouTube et la visibilité dans les réponses IA. L’autorité se construit désormais sur une multitude de plateformes.

L’accent porte sur le volume, la fraîcheur et la diversité des sources qui mentionnent une entité, bien plus que sur le nombre brut de liens. C’est l’un des aspects majeurs du SEO avec l’intelligence artificielle.

Le rôle des articles sponsorisés et du « nofollow »

Les articles sponsorisés conservent une utilité stratégique précise. S’ils sont clairement identifiés et utilisent un attribut rel="nofollow", ils ne transmettent pas de PageRank mais construisent efficacement la visibilité.

Pour une IA, une mention dans une publication réputée constitue un signal d’autorité indéniable. L’attribut « nofollow » n’enlève rien à cette reconnaissance de la marque par l’algorithme.

L’objectif ici reste la présence de la marque et l’association contextuelle forte. Cela contribue directement à la crédibilité globale de l’entité dans le graphe de connaissances du moteur.

La nouvelle cartographie du web : graphe de confiance et proximité sémantique

Pour saisir l’evolution liens seo, il faut abandonner les listes de liens. Il faut visualiser une carte de relations thématiques.

Les « seed sets » : les points de référence de la confiance

Les « seed sets » forment un groupe restreint de sites de très haute confiance. Sites gouvernementaux, grandes universités ou médias de référence en sont des exemples.

La confiance se propage depuis ces « graines ». Plus un site est proche d’un « seed set » dans le graphe, plus il est jugé fiable.

C’est une rupture avec le PageRank. La confiance dépend désormais de la proximité à des sources fiables, et non d’un score brut.

Mesurer la distance sémantique, pas l’autorité

La valeur d’un lien se mesure par sa « distance sémantique ». Il s’agit de la proximité thématique entre la page source et la page cible.

Un lien d’un site à forte autorité mais hors sujet vaut moins qu’un lien d’un petit blog spécialisé. La pertinence thématique prime.

L’achat de liens génériques sur des sites « à fort DA » devient obsolète. Le contexte confère au lien sa véritable puissance.

La valeur d’un lien ne dépend plus de son autorité brute, mais de sa proximité sémantique. C’est la fin du netlinking de masse et le début du partenariat éditorial ciblé.

Les quatre nouveaux rôles du lien

Les fonctions modernes du lien dépassent désormais le simple classement dans les moteurs.

- Signal de confiance et de contexte : Il prouve la pertinence du contenu et sa validation par des pairs du domaine.

- Critère d’inclusion : C’est la porte d’entrée pour intégrer le « Reduced Link Graph » et être considéré comme fiable.

- Qualifiant pour le contenu : Il ne classe pas directement, mais permet à l’algorithme de considérer le contenu de qualité.

- Indicateur de risque : Un profil de liens de mauvaise qualité constitue un signal négatif dégradant la crédibilité.

Adapter sa stratégie : qualité, propreté et cohérence

Abandonner les campagnes de masse

Les campagnes d’e-mailing de masse pour l’acquisition de liens sont terminées. Elles génèrent des liens sans contexte, qui sont au mieux ignorés par les algorithmes. Ces méthodes obsolètes gaspillent des ressources.

L’avenir exige une approche sélective et ciblée. Il s’agit de construire de vraies relations avec des sites légitimes de votre secteur. La pertinence thématique remplace désormais le volume brut.

L’objectif est d’obtenir des liens de manière naturelle. Ils doivent provenir de sites qui vous citeraient de toute façon, car votre contenu est excellent. C’est le seul gage de pérennité.

L’hygiène des liens : sortants et internes

Il faut auditer régulièrement ses liens externes pour maintenir un profil sain. Cela permet de s’assurer de ne pas pointer vers des domaines « empoisonnés » ou de faible qualité. Des liens sortants propres protègent la crédibilité du site.

Le maillage interne nécessite une attention tout aussi rigoureuse. La crédibilité externe, acquise via les backlinks, doit être soutenue par une logique interne sans faille. Chaque page doit transmettre son autorité efficacement.

Un maillage interne fort aide les moteurs à cartographier l’expertise de votre site. Une structure de liens internes solide fait partie d’un SEO technique impeccable.

Le contenu comme principal outil de netlinking

La meilleure méthode pour obtenir de bons liens est de créer du contenu qui mérite d’être cité. Cette evolution liens seo confirme une fois de plus que le contenu est roi. La qualité dicte la performance.

Il faut se concentrer sur la création de recherches originales, de données uniques et d’avis d’experts. Ce sont les contenus que les autres sites voudront utiliser comme source. L’unicité attire la citation.

Dans ce nouveau modèle, l’acquisition de liens est un résultat naturel d’une bonne stratégie de contenu. Ce n’est plus une activité mécanique et séparée. Le lien valide l’expertise.

L’ère du netlinking de masse cède la place à une approche qualitative centrée sur la confiance. Le contenu s’impose désormais comme le facteur de classement prédominant, validé par des liens contextuels précis. Dans un écosystème dominé par l’IA et le GEO, la proximité sémantique supplante définitivement l’autorité brute.

FAQ

Quels sont les trois piliers fondamentaux du référencement ?

Le référencement naturel s’articule historiquement autour de la technique, du contenu et de la popularité. Le volet technique assure que le site est correctement exploré et indexé par les moteurs. Le contenu répond aux intentions de recherche des utilisateurs par une pertinence sémantique forte.

Le pilier de la popularité, autrefois centré sur la quantité de liens, évolue vers une logique de qualité. Les liens externes agissent désormais comme des signaux de confiance et de contexte, validant l’autorité du site plutôt que de simplement gonfler son score de classement.

Comment l’intelligence artificielle redéfinit-elle l’avenir du SEO ?

L’avenir du référencement s’inscrit dans le Generative Engine Optimization (GEO). Les moteurs de recherche utilisent l’IA pour synthétiser des réponses directes à partir des contenus existants. Le rôle du SEO consiste à structurer l’information pour qu’elle soit comprise et citée par ces modèles génératifs.

Dans ce contexte, la fiabilité de la source devient le critère déterminant. L’IA privilégie les contenus démontrant une expertise vérifiable et une fraîcheur de données. Les mentions de marque et la cohérence sémantique remplacent progressivement les techniques de netlinking de masse.

Quel quatrième pilier s’impose dans la stratégie SEO moderne ?

L’expérience utilisateur (UX) et la confiance, formalisée par les critères E-E-A-T, constituent le quatrième pilier indispensable. Les algorithmes modernes évaluent la fluidité de la navigation et la clarté de l’information pour juger de la pertinence d’une page.

Ce facteur de confiance sert de filtre pour valider les trois autres piliers. Un contenu excellent ou des liens nombreux ne suffisent plus si le site ne démontre pas une légitimité et une sécurité suffisantes pour l’utilisateur et les systèmes d’IA.