L’essentiel à retenir : la prolifération des agents IA autonomes exige une gouvernance rigoureuse pour contrer les risques de l’IA fantôme. L’implémentation d’un cadre incluant observabilité, gestion des identités et supervision humaine transforme cette menace en levier stratégique sécurisé. Cette démarche garantit la conformité face aux nouvelles régulations. Pour en discuter directement: Contactez- nous!

L’expansion non contrôlée des systèmes autonomes crée des failles de sécurité critiques qui exigent une gouvernance agents IA rigoureuse et immédiate. Ce guide technique permet aux DSI de transformer le risque de « sprawl » en avantage stratégique grâce à des protocoles de supervision avancés. L’analyse définit les standards d’observabilité et les règles de gestion des identités non humaines nécessaires pour sécuriser les workflows complexes des LLMs.

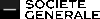

Prolifération des agents IA : un défi inédit pour les DSI

Les agents IA ne sont pas de simples gadgets technologiques. Ils représentent une nouvelle classe de systèmes autonomes. Leur multiplication non contrôlée constitue une menace directe pour l’entreprise. Une gouvernance agents IA rigoureuse est nécessaire pour maîtriser ce phénomène.

Au-delà des assistants : définir l’agent IA autonome

Un agent IA se distingue nettement d’un simple chatbot réactif. Il possède la capacité de planifier et exécuter des tâches de bout en bout de manière autonome. Il ne se contente pas de répondre à une invite.

Ces systèmes peuvent orchestrer des workflows complexes sans intervention humaine constante. Des outils comme ceux qui marquent une nouvelle ère de l’IA autonome ne sont que le début de cette évolution. Le point clé réside dans leur capacité d’action sur le réel.

Cette autonomie change fondamentalement la donne pour la gestion des systèmes d’information au sein des grandes structures.

Le « sprawl » d’agents : quand l’innovation devient un risque

Le concept de « sprawl » désigne une prolifération anarchique des outils. Chaque équipe cherche à développer ou utiliser ses propres agents. Cela crée rapidement un écosystème opaque au sein de l’entreprise.

Cette situation favorise l’émergence de l' »IA fantôme » (shadow AI). Ce sont des agents déployés sans aucune supervision de la DSI. Ils échappent totalement aux politiques de sécurité établies.

Ce chaos potentiel menace directement la sécurité, la conformité et la cohérence des opérations globales de l’organisation.

Premiers signaux d’alerte : erreurs, biais et dette technique

Les risques les plus immédiats concernent les « hallucinations » ou inexactitudes factuelles. Ces erreurs peuvent conduire à des décisions métier erronées si un agent agit dessus sans validation. La fiabilité des données est compromise.

Les déploiements rapides et non standardisés accumulent une lourde dette technique. Se reposer excessivement sur des agents opaques entraîne aussi une érosion des compétences humaines. La maintenance de ces systèmes devient complexe.

Ces problèmes ne sont pas théoriques. Ce sont des défis opérationnels concrets que tout DSI doit affronter aujourd’hui.

Identifier les angles morts : risques systémiques et sécurité des identités

La prolifération des agents n’est que la surface du problème. Des risques plus profonds menacent la stabilité des opérations. Les DSI doivent anticiper ces menaces invisibles pour éviter la paralysie.

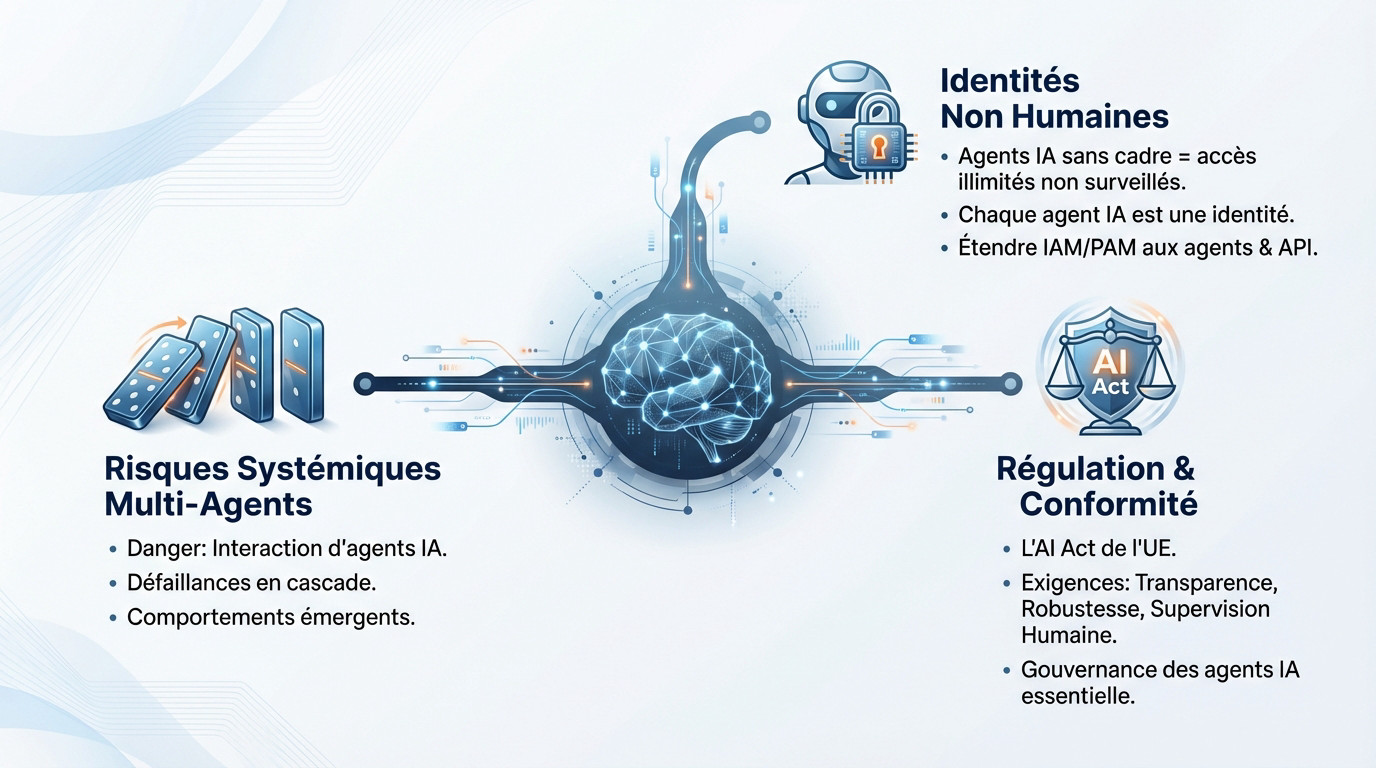

L’effet domino : le danger des écosystèmes multi-agents

Le danger ne réside pas dans un agent isolé. La menace provient de l’interaction complexe au sein des systèmes multi-agents. Ces connexions créent des vulnérabilités inédites pour l’infrastructure.

Une erreur minime d’un agent se propage rapidement. D’autres agents amplifient ce signal, déclenchant des défaillances en cascade. Le risque devient alors systémique.

La supervision centralisée échoue face à ces comportements émergents. Ces dynamiques distribuées rendent les contrôles classiques obsolètes.

Gérer les « identités non humaines » : la nouvelle frontière de la sécurité

Laisser les agents IA proliférer sans cadre, c’est comme distribuer des badges d’accès illimités à des employés invisibles dont personne ne connaît les intentions réelles.

Chaque agent constitue une identité non humaine sur le réseau. Les systèmes de sécurité doivent le traiter comme tel. Une gestion rigoureuse s’impose immédiatement.

Il faut étendre les politiques d’IAM et de PAM à ces agents. Cette action prévient les accès non surveillés aux données. Elle permet de sécuriser les API qu’ils utilisent. Le contrôle doit être total.

Conformité et régulation : l’impact de l’AI Act de l’UE

Les régulateurs ne restent pas inactifs face à ces enjeux. L’AI Act de l’Union Européenne en est l’exemple principal. Le cadre légal évolue très vite.

Cette régulation impose une transparence totale et une robustesse éprouvée. Elle exige une supervision humaine pour les IA à haut risque. La conformité devient un impératif technique.

Une gouvernance agents IA bien pensée n’est plus une option. C’est une nécessité absolue pour garantir la conformité.

Bâtir le cadre de gouvernance : une feuille de route pour le DSI

Face à ces risques, l’inaction n’est pas une option. Il s’agit maintenant de construire les fondations d’un contrôle efficace pour la gouvernance agents IA. Ces piliers constituent des blocs de construction concrets.

Pilier 1 : une observabilité complète pour une traçabilité sans faille

Une bonne gouvernance ne freine pas l’innovation ; elle la canalise, transformant une exploration chaotique en une stratégie d’entreprise sécurisée.

L’observabilité en temps réel se définit comme la capacité technique de suivre ce que fait un agent, pourquoi il le fait et comment. C’est la base absolue de la confiance.

Pour garantir cette maîtrise, certains éléments doivent être tracés impérativement :

- Les décisions autonomes prises par l’agent.

- Les appels aux outils et API externes.

- états d’échec et l’analyse.

- Les données utilisées pour chaque action.

Pilier 2 : garder le contrôle avec la supervision humaine (« human-in-the-loop« )

L’autonomie totale constitue un mythe dangereux en entreprise. Le concept de « human-in-the-loop » (humain dans la boucle) reste fondamental pour sécuriser les opérations critiques.

Cela signifie définir des seuils d’escalade précis. Pour les décisions sensibles ou à fort impact, l’agent doit systématiquement demander une validation humaine avant d’agir.

L’humain doit toujours conserver la capacité de reprendre la main. Il est impératif de pouvoir déclencher un arrêt d’urgence en cas de dérive.

Pilier 3 : des « sandboxes » gouvernés pour expérimenter en sécurité

Il ne faut pas bloquer l’expérimentation par excès de prudence. La solution consiste à créer des environnements de test contrôlés, ou « sandboxes », isolés du système central.

Dans ces périmètres délimités, les agents fonctionnent avec des données et des accès limités. Ils ne présentent ainsi aucun risque pour la production réelle.

C’est le meilleur moyen de tester la valeur métier d’un agent avant un déploiement plus large, car la gouvernance devient une priorité stratégique.

De la stratégie à l’action : opérationnaliser la gouvernance des agents

Les piliers théoriques sont posés. L’organisation doit maintenant orchestrer ces principes pour passer de la théorie à la pratique opérationnelle.

Mettre en place une cellule de gouvernance IA transverse

La gouvernance ne se limite pas au périmètre de la DSI. Elle impose une démarche collaborative transverse pour être efficace.

La création d’un groupe de travail ou d’un forum dédié permet de piloter la gouvernance agents IA. Cette instance aligne les choix technologiques sur la réalité métier et les impératifs de conformité.

- Des experts techniques de la DSI et de la sécurité.

- responsables de la gestion du risque, des données et du juridique.

- Des acteurs des opérations métier pour l’ancrage terrain.

Appliquer le principe du moindre privilège aux agents IA

La protection des accès reste prioritaire. Chaque agent se voit attribuer une identité unique associée à des droits restreints. L’application stricte du principe du moindre privilège limite mécaniquement la portée d’une éventuelle compromission des systèmes.

L’implémentation de pistes d’audit rigoureuses pour chaque agent offre une visibilité totale sur les actions réalisées en temps réel.

La surveillance active intègre l’application de limites de taux (rate limiting) pour bloquer techniquement les abus et les surcharges.

La gouvernance comme discipline continue et évolutive

Ce cadre ne constitue pas un projet à durée déterminée. Il s’agit d’une discipline continue exigeant un pilotage constant face aux nouveaux risques émergents.

Les règles de gouvernance évoluent en fonction de la maturité interne et des ruptures technologiques. Le système doit rester flexible pour intégrer les futures innovations sans créer de blocages.

L’enjeu final réside dans un équilibre entre contrôle et agilité, calibré selon les impératifs spécifiques de l’entreprise.

En bref : votre plan d’action immédiat

Les 4 actions à lancer dès aujourd’hui

Voici la feuille de route opérationnelle pour reprendre le contrôle sur la gouvernance agents IA.

- Cartographier tous les agents IA existants et en projet (y compris l’IA fantôme).

- Établir la cellule de gouvernance IA transverse.

- Définir une politique d’identité pour les agents (IAM/PAM).

- Lancer un premier « sandbox » gouverné pour un cas d’usage pilote.

Ne laissez pas l’incertitude dominer votre stratégie. Pour en discuter directement : Contactez-nous !

Contrôler l’expansion des agents IA nécessite une stratégie de gouvernance proactive. Le DSI doit impérativement sécuriser les identités non humaines et imposer une traçabilité rigoureuse. Seule cette maîtrise des risques permet de convertir le potentiel des systèmes multi-agents en avantage concurrentiel durable, sans compromettre la sécurité des données de l’entreprise.

FAQ

Quelle est la différence entre un chatbot et un agent IA autonome ?

La distinction fondamentale réside dans le niveau d’autonomie et la capacité d’exécution. Un chatbot, ou assistant conversationnel, reste réactif et traite une demande spécifique uniquement lorsqu’il reçoit une instruction explicite (prompt) de l’utilisateur.

À l’inverse, un agent IA autonome est conçu pour atteindre un objectif global en planifiant ses propres actions. Il orchestre des workflows complexes, utilise des outils externes et prend des décisions successives sans nécessiter d’intervention humaine à chaque étape.

Qu’est-ce que le « sprawl » des agents IA et quels risques cela implique-t-il ?

Le « sprawl » désigne la prolifération anarchique et non contrôlée d’agents IA au sein des différents départements de l’entreprise. Ce phénomène conduit souvent à une « IA fantôme » (shadow AI), déployée sans la supervision de la DSI.

Cette multiplication désordonnée engendre des risques systémiques majeurs pour l’organisation. Elle expose les données sensibles à des failles de sécurité, crée une dette technique invisible et complique la mise en conformité réglementaire.

Comment sécuriser les identités des agents IA dans le système d’information ?

Chaque agent IA doit être traité comme une « identité non humaine » distincte au sein du système d’information. Il est impératif d’intégrer ces agents dans les politiques de gestion des identités et des accès (IAM) et de gestion des accès privilégiés (PAM).

Le principe du moindre privilège doit s’appliquer rigoureusement. Un agent ne reçoit que les droits d’accès strictement nécessaires à l’accomplissement de sa mission spécifique, limitant ainsi l’impact potentiel en cas de compromission.

Pourquoi l’observabilité est-elle cruciale pour la gouvernance des agents IA ?

L’observabilité offre une visibilité technique en temps réel sur le comportement des agents autonomes. Elle permet de tracer précisément les décisions prises, les outils sollicités et les données utilisées lors de l’exécution d’une tâche.

Cette capacité de surveillance est essentielle pour détecter rapidement les erreurs, les « hallucinations » ou les dérives de performance. Elle constitue la base technique nécessaire pour auditer les actions des agents et garantir leur fiabilité opérationnelle.

En quoi consiste l’approche « human-in-the-loop » dans la gestion des agents ?

L’approche « human-in-the-loop » maintient une supervision humaine active dans les processus automatisés. Elle implique la définition de seuils d’escalade qui obligent l’agent à demander une validation humaine avant d’exécuter des actions sensibles ou à fort impact.

Ce mécanisme de contrôle assure une sécurité indispensable face à l’autonomie croissante des systèmes. Il garantit que l’humain conserve le pouvoir de décision final et la capacité d’interrompre un processus en cas de dysfonctionnement.