L’essentiel à retenir : Google recommande de privilégier les fondamentaux SEO éprouvés plutôt que l’optimisation spécifique pour l’IA. Cette approche assure la stabilité des classements, car les systèmes de recherche actuels valorisent avant tout la qualité du contenu et l’expérience utilisateur. Avec moins de 0,5 % du trafic mondial généré par les chatbots, la priorité reste la performance sur les moteurs historiques.

L’incertitude règne quant à l’impact réel de l’intelligence artificielle sur les classements des moteurs de recherche. Google préconise pourtant un retour strict aux seo pratiques fondamentales pour assurer la pérennité du trafic organique face à ces évolutions technologiques. Ce dossier examine les recommandations officielles et explique pourquoi l’excellence technique associée à un contenu expert reste la seule stratégie viable.

Le verdict de Google face à l’IA : revenir aux bases

La recommandation officielle : ne changez rien (ou presque)

Danny Sullivan, porte-parole de Google, conseille fermement aux professionnels de se concentrer sur les seo pratiques fondamentales. Il recommande de ne pas céder à la panique face à l’émergence de l’intelligence artificielle.

Les stratégies actuelles, si elles sont solides, conservent toute leur efficacité technique. L’arrivée de ces nouvelles technologies ne rend absolument pas le travail existant obsolète.

Il faut se méfier des approches « fantaisistes » conçues spécifiquement pour l’IA. Ces tactiques souvent éphémères risquent de disparaître lors des prochaines mises à jour des algorithmes de recherche, mettant en péril la visibilité acquise.

Pourquoi les « AI Overviews » ne changent pas les règles du jeu

Un fait technique majeur rassure les éditeurs : les systèmes de classement […] restent fondamentalement les mêmes que ceux de la recherche classique.

La conséquence logique est simple. Un contenu bien positionné dans la recherche traditionnelle a de très fortes chances d’être repris par les systèmes d’IA de Google.

L’effort doit donc se concentrer sur les signaux de qualité et de pertinence qui assurent le succès du référencement naturel depuis des années.

L’AEO, une fausse bonne idée ?

L’AEO tente de séduire spécifiquement les moteurs de réponse IA. Pourtant, la meilleure approche pour l’AEO consiste simplement à appliquer un SEO rigoureux et centré sur l’utilisateur.

Changer radicalement de stratégie pour l’IA complique inutilement les choses et ne garantit aucun succès à long terme, c’est une course perdue d’avance contre les algorithmes.

Courir après des tactiques spécifiques à l’IA place le SEO dans une position réactive. Cette stratégie empêche d’être proactif et maintient le site dans une situation de faiblesse.

La stabilité comme stratégie gagnante

Danny Sullivan incite les agences à rassurer leurs clients sur l’efficacité à long terme des méthodes éprouvées. La stabilité des résultats constitue un argument commercial puissant face aux incertitudes technologiques actuelles et aux doutes ambiants.

Le message est clair : la pérennité des résultats prime sur les gains rapides et souvent incertains.

Une stratégie ancrée sur les fondamentaux résiste bien mieux aux fluctuations des SERP. Elle survit aux mises à jour, qu’elles soient liées à l’IA ou aux algorithmes classiques.

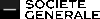

Le mythe de l’AEO et le ROI de la recherche

La part de trafic dérisoire des chatbots

Les données actuelles relativisent fortement l’impact réel des chatbots sur le trafic web global. ChatGPT ne génère à ce jour qu’environ 0,2 % à 0,5 % du volume total de recherche. Cette part reste anecdotique.

La situation s’avère encore plus critique pour les concurrents directs comme Perplexity ou Anthropic Claude. Les statistiques montrent que le trafic issu de Claude est techniquement « proche de zéro ». Ces outils ne drainent pas d’audience significative.

Miser sur ces canaux émergents au détriment de Google ou Bing constitue une erreur de calcul stratégique majeure. Le volume d’utilisateurs n’y est pas.

Un retour sur investissement quasi nul

Cette faiblesse structurelle des flux entrants impacte directement la rentabilité des actions marketing. Le retour sur investissement (ROI) d’une stratégie purement axée sur l’AEO demeure aujourd’hui quasi nul pour les éditeurs.

Allouer des budgets conséquents pour tenter de capter une fraction infime du trafic représente une gestion inefficace des ressources disponibles. Le coût d’opportunité devient rapidement prohibitif pour les équipes techniques. L’effort ne paie pas en visibilité.

L’attention doit logiquement se porter là où les utilisateurs naviguent massivement. Google et Bing concentrent toujours l’essentiel de la valeur transactionnelle.

Le danger des tactiques « spammy »

La volonté de manipuler les réponses des IA conduit souvent à des dérives techniques risquées. Ces tentatives de « hacking » s’apparentent à des tactiques « spammy » qui nuisent à la réputation du domaine sur le long terme.

On observe le retour de méthodes comme les listes auto-référencées ou les ajustements excessifs de mots-clés. Ces techniques étaient déjà considérées comme obsolètes et inefficaces dès les années 2005 par les experts du secteur.

Google sanctionne sévèrement le contenu de faible qualité généré par ces approches artificielles. Il est préférable de consolider les seo pratiques fondamentales évoquées dans le dossier SEO à l’ère de l’IA.

Pilier n°1 : la technique, un socle solide mais simplifié

Puisque la course à l’IA est un leurre, revenons au premier pilier concret et intemporel : la base technique de votre site.

L’apport des CMS modernes selon John Mueller

John Mueller de Google observe une évolution majeure. Les aspects techniques fondamentaux du SEO sont désormais gérés « prêts à l’emploi » par la majorité des CMS modernes. On ne part plus de zéro pour rendre un site visible.

Regardez des plateformes comme WordPress, Wix ou Shopify. Elles intègrent nativement de nombreuses bonnes pratiques techniques, ce qui simplifie considérablement le travail de mise en place. Le code généré est souvent propre et indexable par défaut.

Ce constat change la donne. Il libère du temps et des ressources pour les professionnels du SEO et les éditeurs.

Les fondamentaux techniques toujours d’actualité

Attention, « simplifié » ne veut pas dire « oublié ». Une vérification et une maintenance de base restent nécessaires pour garantir une fondation saine. Négliger ces vérifications expose votre site à des problèmes d’invisibilité évitables.

Voici les seo pratiques fondamentales à surveiller impérativement :

- La sécurité (HTTPS) : un prérequis non négociable pour la confiance et le classement.

- L’indexation Mobile-First : s’assurer que le site est parfaitement utilisable et complet sur mobile.

- La vitesse de chargement (Core Web Vitals) : un facteur direct d’expérience utilisateur et de ranking.

- Une structure de site logique : pour faciliter le crawl des robots et la navigation des utilisateurs.

- La propreté du code et l’absence d’erreurs 404 : des signaux de maintenance et de qualité.

Le nouveau rôle du SEO technique

Le rôle du spécialiste SEO technique évolue. Il passe d’un rôle de « constructeur » à celui de « superviseur » et « d’expert en cas de problème ». Il intervient là où l’automatisation atteint ses limites.

Sa mission est de s’assurer que le CMS est bien configuré. Il doit diagnostiquer les problèmes complexes et gérer des aspects avancés comme le SEO JavaScript pour garantir une indexation optimale.

L’objectif est de garantir que la technique ne soit jamais un frein à la performance du contenu. L’analyse de logs SEO peut aider à identifier ces freins.

Pilier n°2 : le contenu, le véritable champ de bataille

Répondre à l’intention de recherche avant tout

La qualité d’un contenu se mesure d’abord à sa capacité à répondre précisément à l’intention de recherche de l’utilisateur. C’est le contrat de base absolu entre un site et son visiteur. Si cette promesse n’est pas tenue, l’engagement chute immédiatement.

Qu’il s’agisse d’une recherche informationnelle, transactionnelle ou navigationnelle, le contenu doit apporter une réponse claire, directe et complète. L’utilisateur exige une solution immédiate à son problème, sans détours inutiles ni remplissage artificiel.

Les systèmes d’IA, tout comme les algorithmes classiques, sont conçus pour identifier cette adéquation.

Les critères d’un contenu de qualité en 2025

Pour les moteurs de recherche, la notion de qualité repose désormais sur des marqueurs techniques et éditoriaux très précis.

Voici les piliers indispensables pour performer :

- L’originalité : apporter une information nouvelle, un angle unique ou une synthèse à forte valeur ajoutée.

- La profondeur : traiter le sujet de manière exhaustive, sans rester en surface.

- La fiabilité : citer des sources, s’appuyer sur des données et démontrer son expertise.

- La clarté : structurer le texte avec des titres, des paragraphes courts et un langage accessible.

Retrouver le plaisir d’écrire

Google encourage désormais les créateurs à revenir au plaisir d’écrire des blogs. Ce changement de perspective invite à délaisser l’optimisation mécanique pour privilégier la valeur réelle offerte au lecteur.

L’idée est de se libérer de l’inquiétude excessive du SEO pour se concentrer sur la passion du sujet et le partage de connaissances. Un contenu authentique et passionné résonne bien mieux auprès de l’audience qu’un texte purement technique.

Paradoxalement, c’est souvent en pensant moins aux algorithmes qu’on applique le mieux les seo pratiques fondamentales.

L’IA comme assistant, pas comme auteur

L’IA générative doit être positionnée comme un outil de support. Elle peut aider efficacement à la recherche documentaire, à la structuration d’idées ou à la reformulation de passages complexes.

Mais elle ne doit pas remplacer l’auteur. Le contenu généré en masse, sans supervision, sans expertise et sans personnalité est exactement ce que Google cherche à déclasser. C’est du contenu conçu « pour les robots ».

L’humain doit rester le garant de la qualité, de l’originalité et de la véracité de l’information. À ce titre, ces conseils SEO indispensables restent la meilleure feuille de route.

Pilier n°3 : l’autorité et la confiance, des signaux intemporels

Le netlinking de qualité : une recommandation, pas un nombre

Le netlinking constitue toujours un pilier central du référencement naturel. Les liens entrants fonctionnent comme des votes de confiance indispensables pour les algorithmes de recherche. Google utilise ces signaux externes pour valider la crédibilité d’une page.

La valeur intrinsèque d’un lien l’emporte sur le volume total accumulé. Un unique backlink issu d’un site d’autorité dans la même thématique surpasse des dizaines de liens médiocres. L’achat massif sans stratégie s’avère inutile et coûteux. La pertinence contextuelle dicte la performance.

Cette logique de pertinence et d’autorité est parfaitement intégrée par les systèmes d’IA modernes. Ils ignorent les tactiques de manipulation artificielles.

L’E-E-A-T comme boussole

Le concept de l’E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) structure l’évaluation de la qualité par Google. Ce cadre définit les critères de fiabilité pour tout contenu en ligne. Il guide les évaluateurs humains et les systèmes automatisés.

L’E-E-A-T n’agit pas comme un facteur de classement direct au sens technique. Il influence pourtant lourdement les algorithmes en filtrant les résultats de faible valeur. Ce concept se matérialise par des indicateurs concrets sur le site.

Ces signaux incluent les mentions claires de l’auteur, les liens sortants qualifiés et la réputation globale de la marque. La transparence renforce la confiance.

Comment l’IA évalue l’autorité

Les modèles d’IA, tels que le Knowledge Graph, sont conçus pour comprendre les entités et leurs relations sémantiques. Ils ne se limitent pas à la simple lecture des mots-clés. Ces systèmes cartographient les connexions réelles entre les sujets.

Ils identifient l’autorité en analysant comment une entité est citée et connectée à travers le web. La présence sur des sources de référence valide cette expertise aux yeux des machines. L’IA cherche le consensus établi.

Construire son autorité via des contenus experts reste une stratégie directement compatible avec l’IA. C’est l’application concrète des seo pratiques fondamentales.

L’expérience utilisateur (UX) : le facteur humain qui fait la différence

Au-delà de la technique et du contenu, il y a la manière dont l’utilisateur interagit avec le site. C’est là que l’expérience utilisateur entre en scène.

L’UX, un signal de classement indirect mais puissant

L’expérience utilisateur (UX) regroupe l’ensemble des facteurs déterminant la satisfaction d’un visiteur sur une page web. Google ne s’arrête pas au code ; il analyse la réaction humaine face à l’interface.

Le moteur mesure cette satisfaction via des signaux comportementaux précis : taux de rebond, temps passé sur la page, pogo-sticking. Si les visiteurs quittent le site immédiatement, cela envoie un signal négatif fort. Une UX optimisée améliore mécaniquement ces métriques.

C’est un signal de classement indirect qui prouve à Google que la page est pertinente et utile. Cela renforce l’efficacité des seo pratiques fondamentales mises en place.

Les composantes d’une bonne expérience utilisateur

Une bonne UX repose sur des principes de bon sens. La clarté, la simplicité et l’efficacité doivent guider chaque décision de design pour ne pas perdre l’internaute.

Cela inclut une navigation intuitive, une lisibilité parfaite grâce aux contrastes, des appels à l’action clairs et un design responsive. Un site doit s’adapter parfaitement à tous les écrans, du mobile au bureau.

L’objectif est de réduire la friction au maximum. L’utilisateur doit pouvoir trouver ce qu’il cherche sans effort cognitif ni attente technique.

Pourquoi l’IA ne peut pas ignorer l’UX

L’objectif final de Google, y compris avec ses modèles d’IA récents, reste de satisfaire l’utilisateur. Une page qui frustre les visiteurs, même avec un bon contenu, échoue à cette mission.

Les systèmes d’IA vont donc logiquement privilégier les sources qui offrent non seulement une bonne information, mais aussi une bonne expérience. La machine apprend à reconnaître ce qui plaît à l’humain.

Investir dans l’UX est donc une autre façon de construire une stratégie SEO durable. C’est une garantie de performance qui résiste aux changements d’algorithmes.

Le contraste : les pratiques à bannir à l’ère de l’IA

Le retour des vieilles tactiques « spammy »

Les nouvelles tactiques « spammy » pour l’IA ne sont souvent qu’un recyclage de pratiques obsolètes que Google combat depuis 2005, une régression plutôt qu’une évolution.

La promesse de leurrer l’intelligence artificielle reste aussi vaine que celle de tromper l’algorithme de Google par le passé. C’est une vision à court terme qui néglige les seo pratiques fondamentales.

Ces approches ignorent le principe de base régissant les moteurs modernes. Les systèmes de recherche sont conçus pour détecter et dévaluer ce type de manipulation avec une précision accrue.

Les « anti-fondamentaux » à éviter

Concrètement, voici ce qu’il faut éviter de faire pour ne pas dégrader la qualité du domaine.

L’utilisation de techniques artificielles pour gonfler la pertinence d’une page échoue face aux modèles actuels :

- Le bourrage de mots-clés (Keyword Stuffing) : Tenter de surcharger un texte avec des mots-clés pour manipuler les IA.

- Le contenu généré en masse sans valeur : Publier des centaines d’articles IA superficiels qui ne répondent à aucune intention.

- Les listes « auto-référencées » : Créer des listes factices dans le seul but d’y inclure son propre produit ou service.

- La dissimulation (Cloaking) : Présenter un contenu différent aux moteurs de recherche et aux utilisateurs.

Le risque pour la réputation et la pérennité

Au-delà du risque immédiat de pénalité algorithmique, ces pratiques nuisent gravement à la crédibilité et à l’image de marque. L’autorité du domaine s’effondre auprès des moteurs.

Un utilisateur qui tombe sur un contenu de faible qualité ou manipulateur perd instantanément confiance. Cette confiance est difficile à regagner une fois que le doute s’est installé.

Une stratégie SEO durable se construit sur la confiance de l’audience, pas sur la tromperie. C’est un investissement à long terme.

Construire une stratégie SEO durable et à l’épreuve du futur

La synthèse : une approche holistique

Le référencement moderne dépasse la simple accumulation d’astuces techniques. Il exige une vision globale intégrant la technique, le contenu, l’autorité et l’expérience utilisateur. C’est un écosystème où chaque composante compte. Les seo pratiques fondamentales reposent sur cet équilibre précis.

Ces quatre piliers ne fonctionnent jamais de manière isolée. Une technique irréprochable reste vaine sans un contenu pertinent. Ils s’alimentent mutuellement pour offrir une expérience globale de qualité au visiteur.

Les algorithmes actuels, y compris ceux pilotés par l’IA, détectent cette cohérence. Ils sont programmés pour récompenser cette synergie naturelle.

Mesurer, analyser, et itérer

Une stratégie performante n’est jamais figée dans le temps. Elle nécessite une mesure constante et des ajustements basés sur les résultats réels. L’immobilisme mène souvent à l’échec.

La Google Search Console s’impose comme le juge de paix pour surveiller la santé du site. Elle révèle les erreurs techniques et identifie les opportunités de trafic inexploitées.

L’analyse des données remplace les suppositions par des certitudes. Pour affiner cette démarche, les bons outils SEO permettent de s’appuyer sur des faits plutôt que des intuitions.

Planifier pour le long terme

L’incertitude technologique se combat par une préparation rigoureuse. Construire un plan SEO solide sert de boussole face aux changements d’algorithmes. Cette feuille de route garantit la cohérence des efforts déployés sur plusieurs mois.

Ce document cadre précisément les objectifs business et les cibles prioritaires. Il définit les indicateurs de performance clés (KPIs) à atteindre pour valider la progression.

Cette rigueur vise une croissance durable et rentable, loin des tactiques éphémères. L’élaboration d’un plan SEO structure cette vision sur la durée.

L’intelligence artificielle ne transforme pas radicalement le SEO, mais renforce l’importance des fondamentaux. Google privilégie toujours la qualité du contenu, l’autorité et une technique solide. Une stratégie pérenne repose sur ces piliers plutôt que sur des tactiques éphémères. L’optimisation pour l’utilisateur reste le meilleur gage de visibilité durable.

FAQ

Quels sont les fondamentaux du SEO à privilégier face à l’IA ?

Google, par la voix de Danny Sullivan, recommande de maintenir le cap sur les pratiques de référencement éprouvées. L’intégration de l’intelligence artificielle dans la recherche ne rend pas les stratégies existantes obsolètes. L’accent doit rester sur la création de contenu utile, pertinent et centré sur l’utilisateur.

Les tentatives d’optimisation spécifiques pour les moteurs de réponse (AEO) ou les tactiques « fantaisistes » liées à l’IA sont souvent inefficaces. Les systèmes de classement, qu’ils soient traditionnels ou basés sur des modèles d’IA, valorisent avant tout la qualité intrinsèque et la réponse à l’intention de recherche.

Quelles bonnes pratiques SEO garantissent une visibilité pérenne ?

La conformité aux critères E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) constitue une base incontournable. Les moteurs de recherche privilégient les contenus qui démontrent une réelle expertise et citent des sources fiables. L’originalité et la profondeur de l’information permettent de se distinguer des générations automatiques standards.

L’expérience utilisateur (UX) représente également un facteur déterminant pour le classement. Un site rapide, sécurisé (HTTPS) et compatible mobile envoie des signaux positifs aux algorithmes. Ces éléments techniques assurent que le contenu est accessible et agréable à consulter pour l’internaute.

Sur quels piliers techniques et sémantiques repose une stratégie SEO durable ?

Une stratégie pérenne s’articule autour de quatre piliers majeurs : la technique, le contenu, l’autorité et l’expérience utilisateur. Le socle technique garantit la bonne indexation des pages par les robots, tandis que le contenu doit répondre précisément aux requêtes des utilisateurs. L’autorité se construit via des backlinks de qualité provenant de sites référents.

Ces axes sont interdépendants et doivent être travaillés de manière holistique. Les systèmes d’IA, tels que les AI Overviews de Google, s’appuient sur ces mêmes signaux pour sélectionner leurs sources. Négliger l’un de ces piliers fragilise la visibilité globale du domaine.

Quelles techniques SEO faut-il éviter à l’ère de l’intelligence artificielle ?

La production massive de contenus par IA générative sans supervision humaine est une pratique à proscrire. Google détecte et dévalue les textes superficiels qui n’apportent aucune valeur ajoutée. Le bourrage de mots-clés (keyword stuffing) et la création de pages satellites restent des techniques considérées comme du spam.

Ces méthodes exposent les sites à des pénalités algorithmiques sévères et nuisent à l’image de marque. L’objectif est de construire une confiance durable avec l’audience plutôt que de tenter de manipuler les modèles de langage (LLMs) par des astuces techniques éphémères.