Ce qu’il faut retenir : Google réaffirme la supériorité du contenu orienté utilisateur sur l’optimisation pour les algorithmes d’IA. L’application du cadre E-E-A-T et la satisfaction réelle du lecteur garantissent un référencement durable. Tenter de manipuler les LLM s’avère inutile, ces plateformes ne représentant toujours que moins de 1 % du trafic web global.

L’incertitude actuelle pousse de nombreux éditeurs à sur-optimiser pour les machines, une erreur stratégique majeure qui menace directement la pérennité de votre classement google contenu utilisateur dans les SERPs. Danny Sullivan confirme pourtant que l’architecture algorithmique du moteur, incluant les modèles d’IA, valorise exclusivement la satisfaction réelle des internautes humains plutôt que la conformité technique pure. Cette étude technique examine l’impact prédominant des critères E-E-A-T et des signaux comportementaux sur la visibilité organique face aux tentatives de manipulation via les LLMs.

La confirmation de Google : le contenu pour humains reste roi

La déclaration sans équivoque de Danny Sullivan

Danny Sullivan l’affirme clairement lors de ses interventions récentes. Le classement google contenu utilisateur reste la priorité absolue de tous les systèmes. Même les algorithmes basés sur l’IA favorisent cette approche centrée sur l’humain.

L’expert ironise sur les nouveaux acronymes complexes comme GEO ou AIO. Ces termes suggèrent à tort des optimisations techniques inédites pour les moteurs. Pourtant, la méthode fondamentale ne change pas d’un iota. Aucune action spécifique n’est requise pour l’IA.

John Mueller et les ingénieurs de Google valident cette position officielle. Cette cohérence interne prouve l’inutilité de changer radicalement de stratégie SEO pour suivre une tendance technologique.

Pourquoi viser les algorithmes d’IA est une erreur

Optimiser pour les LLM constitue une impasse stratégique majeure pour les créateurs. Google cherche avant tout à satisfaire des lecteurs bien réels. Tenter de séduire la machine détourne du véritable objectif de qualité.

L’objectif principal de Google est de récompenser le contenu jugé excellent pour les personnes, rédigé pour des êtres humains, et non pour des algorithmes de recherche.

Les plateformes d’IA génèrent moins de 1% du trafic référent global. Se focaliser dessus représente une perte de temps considérable pour les éditeurs qui cherchent de la visibilité.

Le principe de satisfaction utilisateur : un pilier historique

La satisfaction de l’utilisateur guide Google depuis ses tout débuts. Ce n’est pas un concept né avec l’intelligence artificielle générative. Les algorithmes de recherche ont toujours eu cette finalité précise.

La mise à jour « Medic » de 2018 a marqué un tournant technique important. Depuis, l’évaluation de cette satisfaction s’est grandement affinée. L’IA et les réseaux neuronaux servent désormais d’outils de mesure. Ils détectent mieux la pertinence réelle.

La technologie de classement évolue sans cesse. Le but final demeure de valoriser le contenu utile.

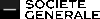

Décoder le « contenu utile » : le cadre de référence de Google

Maintenant que le principe est clair, il faut comprendre ce que Google entend concrètement par ‘contenu de qualité pour les humains‘. La réponse se trouve dans un concept bien connu des experts SEO.

L’E-E-A-T comme grille de lecture de la qualité

Google utilise l’acronyme E-E-A-T pour évaluer la crédibilité d’une page web. Ce système de validation aide les algorithmes à filtrer l’information. Il constitue le socle du classement google contenu utilisateur actuel.

- Experience : Le contenu est-il basé sur une expérience vécue, une utilisation réelle du produit ou une visite du lieu ?

- Expertise : L’auteur possède-t-il les connaissances ou compétences nécessaires sur le sujet ?

- Authoritativeness (Autorité) : Le site ou l’auteur est-il une source de référence reconnue sur le sujet ?

- Trustworthiness (Fiabilité) : Les informations sont-elles exactes, transparentes et dignes de confiance ?

Ces critères aident les systèmes de Google à distinguer un contenu superficiel d’un contenu authentique et fiable. Le moteur valide ainsi la pertinence pour l’internaute.

L’expérience vécue, le nouveau différentiateur

Google a ajouté le « E » d’Expérience pour contrer les textes génériques. Cette mise à jour valorise le vécu réel de l’auteur. Les systèmes cherchent des preuves tangibles d’utilisation. L’objectif est de garantir une information unique.

Des photos originales prouvent la véracité du test. Une analyse personnelle offre une perspective impossible à simuler par une IA. Ces éléments renforcent la crédibilité du propos.

Ignorer ce facteur limite la visibilité organique. Pourtant, comprendre l’influence du E-E-A-T est donc fondamental pour toute stratégie de contenu qui vise la performance.

Au-delà des mots : l’importance de la page experience

Un contenu utile ne se limite pas au texte. L’expérience sur la page (Page Experience) joue un rôle dans la satisfaction de l’utilisateur. Google analyse le comportement global du visiteur.

Les Core Web Vitals mesurent la vitesse de chargement et la stabilité visuelle. Une interface lente provoque un taux de rebond immédiat. L’interactivité doit être fluide sur mobile. Un site technique défaillant pénalise le meilleur article.

Ces signaux techniques sont une autre façon pour Google de mesurer si une page est conçue pour les humains. L’algorithme valide ainsi la convivialité globale.

Les systèmes d’IA de Google : des outils pour comprendre l’humain

Démystifier RankBrain, BERT et MUM

RankBrain, BERT et MUM ne constituent pas de simples facteurs de classement, mais de véritables systèmes de compréhension du langage. Ces technologies visent avant tout à déchiffrer l’intention réelle derrière une requête. Google utilise ces outils pour interpréter le sens, pas juste pour trier.

RankBrain traite les requêtes inédites que le moteur n’a jamais vues auparavant. BERT analyse les nuances et le contexte des mots au sein d’une phrase spécifique. MUM va plus loin en étant multimodal et multilingue pour connecter les informations. Chaque système comble une lacune technique précise.

Leur point commun réside dans l’amélioration de la correspondance entre la demande de l’utilisateur et le contenu pertinent. Ils dépassent largement la simple correspondance de mots-clés.

L’IA au service de la pertinence sémantique

Grâce à ces IA, Google appréhende désormais les concepts, les entités et les relations qui les unissent. Un contenu s’évalue aujourd’hui sur sa profondeur sémantique et sa précision technique. L’algorithme cherche du sens plutôt que des répétitions mécaniques.

Un article qui couvre un sujet en profondeur et répond aux questions connexes surpasse un texte qui répète un mot-clé. Cette richesse informationnelle constitue un signal de qualité fort pour l’IA. La machine valorise l’exhaustivité du propos et l’expertise démontrée.

C’est pourquoi le classement google contenu utilisateur favorise naturellement les pages conçues pour satisfaire les humains.

Aucune nouvelle optimisation spécifique à l’IA

Danny Sullivan confirme qu’il n’existe pas de stratégie SEO spécifique pour RankBrain ou une optimisation pour BERT. Ces systèmes sont programmés pour récompenser le contenu naturel et authentique. L’optimisation technique excessive pour ces algorithmes devient inutile.

Tenter de tromper ces algorithmes s’avère souvent contre-productif pour les éditeurs de sites web. La meilleure approche consiste à ignorer leur existence pour se concentrer sur la clarté et la valeur. Les IA détectent et valorisent ce travail rédactionnel centré sur le lecteur.

En réalité, les facteurs SEO à l’ère de l’IA restent ancrés dans les principes fondamentaux historiques.

Le comportement utilisateur : le véritable juge de paix

Le feedback humain comme signal de classement

Les interactions des internautes constituent une source de données massive pour le moteur de recherche. Chaque clic ou retour rapide agit comme un vote direct sur la qualité des résultats. Le comportement des utilisateurs valide ainsi la pertinence d’une page.

Robbie Stein, vice-président des produits pour Google Search, souligne l’importance de ce mécanisme. Le feedback humain permet d’identifier avec précision le contenu réellement utile. Les algorithmes apprennent de ces interactions pour affiner leurs modèles. Cette validation humaine guide l’évolution du système.

Google exploite ces données comportementales depuis au moins 2004. Cette ancienneté démontre que la satisfaction humaine prime.

Les signaux comportementaux décryptés

Les signaux comportementaux correspondent aux actions concrètes des visiteurs sur la page de résultats. Ils traduisent sans filtre l’intérêt porté aux différents liens affichés.

- Le clic (et le non-clic) : détermine quel résultat capte l’attention immédiate de l’internaute.

- Le « long clic » (dwell time) : indique si le visiteur consomme le contenu durablement sur la page.

- Le « pogo-sticking » : signale un retour rapide vers la liste de résultats après consultation.

- La reformulation de la requête : prouve que la réponse initiale était insuffisante pour l’utilisateur.

Ces indicateurs alimentent des systèmes comme NavBoost pour ajuster les positions en temps réel. Ils permettent d’aligner le classement google contenu utilisateur sur la satisfaction réelle des utilisateurs. Cette boucle de rétroaction assure une amélioration continue des résultats.

L’impact sur la création de contenu

La conséquence pour les éditeurs est directe : obtenir un clic ne suffit pas. Le site doit retenir l’internaute en proposant une réponse exhaustive et une expérience fluide. La rétention valide la qualité.

Un titre prometteur suivi d’un contenu pauvre entraîne un retour immédiat vers le moteur. Ce signal négatif sanctionne lourdement la page concernée. La cohérence entre le titre et le contenu constitue donc un impératif absolu pour le référencement.

L’objectif consiste à devenir la destination finale de la recherche pour l’internaute. Le parcours de l’utilisateur doit s’achever sur la page consultée.

Contenu humain contre contenu IA : le nouveau champ de bataille SEO

La position de Google sur le contenu généré par IA

Google ne pénalise pas l’usage de l’intelligence artificielle en soi pour la rédaction. Le moteur de recherche sanctionne uniquement le contenu de faible qualité, qu’il provienne d’une machine ou d’un rédacteur humain. L’origine importe moins que la valeur finale.

Le véritable problème réside dans l’abus et la génération massive de textes. Google cible spécifiquement la production automatisée de pages génériques sans aucune plus-value pour l’internaute. Ces tentatives de manipulation du classement échouent désormais face aux filtres anti-spam actuels.

L’IA reste un outil technique viable si le résultat respecte les critères E-E-A-T. L’expertise démontrée prime sur la méthode de fabrication du texte.

Comment les systèmes de Google différencient l’utile du générique

Les algorithmes récents détectent les signaux subtils d’une rédaction pensée pour l’humain. Ils valorisent l’authenticité et les preuves d’une expérience vécue concrète. Un classement google contenu utilisateur dépend désormais de cette capacité à fournir une perspective unique introuvable ailleurs.

Un texte généré à 100% par une machine peine à simuler une opinion tranchée ou une anecdote réelle. Ces modèles se contentent souvent de reformuler des faits existants sans nuance. Ils manquent de profondeur analytique.

C’est pourquoi la démonstration d’un contenu original et d’expertise constitue le meilleur rempart contre le déclassement. Google cherche à servir des réponses qui satisfont réellement la curiosité humaine.

Stratégies gagnantes à l’ère du contenu IA

L’intelligence artificielle excelle pour structurer des idées ou corriger la syntaxe. Cependant, le cœur du sujet doit impérativement émaner d’une expertise humaine tangible. La machine assiste, l’expert valide.

Adopter les bonnes stratégies pour le contenu IA consiste à l’utiliser comme un assistant, pas comme un remplaçant. L’humain doit valider, enrichir et injecter sa perspective unique. Cette étape de curation transforme une base générique en une ressource fiable.

« Tenter d’optimiser pour des LLM ou d’autres IA est une erreur, car ces plateformes représentent collectivement moins de 1% du trafic de référence total. »

L’évolution des facteurs SEO traditionnels : le cas des backlinks

Cette priorité donnée au contenu et à l’expérience utilisateur force à reconsidérer la place des piliers historiques du SEO. Le rôle des backlinks, en particulier, a profondément changé.

Les liens ne sont plus le facteur principal

Danny Sullivan l’affirme : les backlinks ne sont plus le critère de classement principal pour les moteurs modernes. Cette évolution marque une rupture nette avec les stratégies historiques où le volume de liens dictait la visibilité.

Les systèmes actuels, dopés aux réseaux neuronaux, analysent la pertinence sémantique sans béquille externe. Google comprend désormais la structure et l’utilité réelle d’un texte sans dépendre aussi fortement des liens comme proxy de validation.

Les hyperliens ne disparaissent pas, mais leur poids relatif s’effondre dans l’équation globale. La priorité bascule vers la réponse directe à l’intention de l’internaute.

Le nouveau rôle des backlinks : autorité et découverte

Les liens externes conservent une fonction technique majeure pour la découverte des nouvelles pages par les robots et la consolidation de l’autorité. Ils alimentent directement le « A » du triptyque E-E-A-T, validant la légitimité d’un domaine.

Une citation provenant d’un site expert dans une thématique connexe envoie un signal d’autorité fort aux algorithmes. La qualité contextuelle et la confiance de la source l’emportent désormais sur l’accumulation de références disparates.

Comprendre l’importance changeante des backlinks est donc nécessaire pour ajuster sa stratégie de netlinking.

Abandonner les anciennes stratégies de liens

Les tactiques de masse, comme les échanges automatisés ou les commentaires de forums, deviennent obsolètes et risquées. Les systèmes anti-spam de Google, toujours plus performants, neutralisent ces tentatives de manipulation avec une efficacité redoutable.

Le « link earning » s’impose comme la seule voie durable : produire une ressource exceptionnelle qui attire naturellement les citations. Cette approche favorise un classement google contenu utilisateur sain, basé sur le mérite et l’utilité réelle pour les humains.

Les récentes révélations de la fuite interne de Google confirment d’ailleurs cette vision holistique du classement.

Actions concrètes : comment aligner votre stratégie SEO sur l’humain

La théorie est claire, mais comment la traduire en pratique ? Voici une feuille de route pour les créateurs de contenu et les professionnels du SEO qui veulent s’adapter à cette réalité.

Auditer votre contenu avec le prisme « people-first »

La première étape est de revoir son contenu existant. Posez-vous les questions que Google se pose : ce contenu démontre-t-il une expertise de première main ? Est-il écrit par quelqu’un qui connaît bien le sujet ? Si la réponse est floue, le texte est inutile.

Le contenu répond-il vraiment à la question de l’utilisateur ou se contente-t-il de cibler des mots-clés ? L’objectif est de fournir une réponse satisfaisante. C’est la seule métrique qui compte vraiment aujourd’hui.

Supprimez ou améliorez le contenu qui n’apporte pas de valeur ajoutée claire par rapport aux autres résultats de recherche. Si c’est du remplissage, ça doit disparaître. Le ménage est souvent plus efficace que la création.

Prioriser la création de contenu original et expert

Pour les nouveaux contenus, concentrez-vous sur ce que vous seul pouvez apporter. Partagez vos propres données et vos études de cas. Mettez en avant vos expériences personnelles. L’IA ne peut pas inventer votre vécu.

C’est le meilleur moyen de vous différencier de la concurrence et des contenus générés par IA. C’est votre avantage compétitif. Personne ne peut copier votre histoire ou vos tests réels.

Le contenu original et l’expertise démontrée sont les clés pour se démarquer durablement.

Les piliers d’une stratégie SEO centrée sur l’utilisateur

Pour améliorer votre classement google contenu utilisateur, oubliez les hacks techniques. Visez une stratégie durable et résiliente aux mises à jour.

- Créer pour l’humain : Répondez aux intentions de recherche avec un contenu de valeur, basé sur l’E-E-A-T.

- Soigner l’expérience : Assurez-vous que votre site est rapide, facile à naviguer et agréable à utiliser sur tous les appareils.

- Construire l’autorité : Obtenez une reconnaissance naturelle grâce à la qualité de votre travail, pas par des manipulations.

- Mesurer la satisfaction : Analysez les signaux comportementaux (temps sur la page, taux de rebond) pour comprendre ce qui fonctionne.

En fin de compte, la recommandation de Google est simple : abandonnez les anciennes stratégies. Concentrez-vous sur la création de sites web que les gens aiment. C’est la seule voie viable pour réussir.

Google réaffirme sa doctrine historique : si l’intelligence artificielle transforme les outils de recherche, la finalité reste inchangée. La satisfaction de l’utilisateur humain constitue la priorité absolue du référencement naturel. Les stratégies SEO doivent privilégier l’expertise et l’authenticité plutôt que l’optimisation algorithmique. La qualité du contenu prime sur la technologie.

FAQ

Comment fonctionne le système de classement de Google à l’ère de l’IA ?

Le fonctionnement du classement Google repose sur une combinaison d’algorithmes complexes et de systèmes d’intelligence artificielle tels que RankBrain, BERT et MUM. Ces technologies ne cherchent pas simplement des mots-clés, mais analysent la sémantique pour comprendre l’intention réelle derrière la requête de l’utilisateur.

L’objectif principal de ces systèmes, confirmé par Danny Sullivan, est de prioriser le contenu conçu pour satisfaire les besoins des humains. Les algorithmes récompensent les pages qui offrent une réponse pertinente et une expérience utilisateur fluide, plutôt que celles optimisées techniquement pour les robots.

Comment améliorer le classement d’une page en privilégiant l’expérience utilisateur ?

Pour améliorer le positionnement d’une page, il est essentiel d’adopter le cadre de qualité E-E-A-T (Expérience, Expertise, Autorité, Fiabilité). Google favorise les contenus qui démontrent une connaissance approfondie du sujet et une expérience vécue, apportant ainsi une valeur ajoutée unique par rapport aux autres résultats.

L’optimisation technique, notamment via les Core Web Vitals, joue également un rôle clé. Une page qui charge rapidement et reste stable visuellement contribue à une meilleure expérience utilisateur, ce qui constitue un signal positif pour les systèmes de classement.

Quelle stratégie adopter pour remonter dans les résultats de recherche Google ?

Remonter dans la liste des résultats implique souvent de réviser le contenu existant pour s’assurer qu’il est « people-first ». Il convient de supprimer ou d’enrichir les pages qui n’apportent pas de réponse satisfaisante ou qui semblent générées uniquement pour attirer du trafic.

Les signaux comportementaux, comme le temps de consultation (dwell time) et l’absence de retour rapide aux résultats (pogo-sticking), sont des indicateurs de satisfaction. Fournir une réponse complète qui retient le lecteur sur la page est la méthode la plus efficace pour signaler la pertinence du contenu aux algorithmes.

Comment Google classifie-t-il la qualité du contenu web ?

La classification du contenu par Google s’appuie sur la distinction entre le contenu utile et le contenu générique ou spammy. Les systèmes de détection identifient les textes qui manquent d’originalité, qu’ils soient rédigés par des humains ou générés par des LLM (Large Language Models).

Un contenu de haute qualité selon Google doit présenter des informations originales, des rapports d’analyse ou une perspective d’expert. L’authenticité et la preuve d’une expertise humaine réelle sont devenues des critères déterminants pour différencier les pages utiles des productions de masse.