L’essentiel à retenir : l’IA de Google tend désormais à privilégier des sources de faible qualité, masquant l’expertise réelle et les signaux géographiques (GEO). Cette évolution des SERPs menace directement le trafic organique des éditeurs, avec des pertes potentielles estimées à 50 %. Une adaptation stratégique vers le renforcement de l’autorité de marque devient indispensable pour maintenir la visibilité en ligne. Pour un audit approfondi, Contactez- nous!

La fiabilité des google ai serps semble s’effondrer au profit d’une commodité artificielle qui occulte désormais les véritables experts du web. Cette analyse technique décrypte le paradoxe selon lequel le moteur minimise les signaux géographiques tout en propulsant des contenus de faible pertinence via ses modèles génératifs. Vous identifierez ici les mécanismes précis favorisant ces sources douteuses et mesurerez l’impact concret de cette stratégie sur la visibilité organique de votre marque.

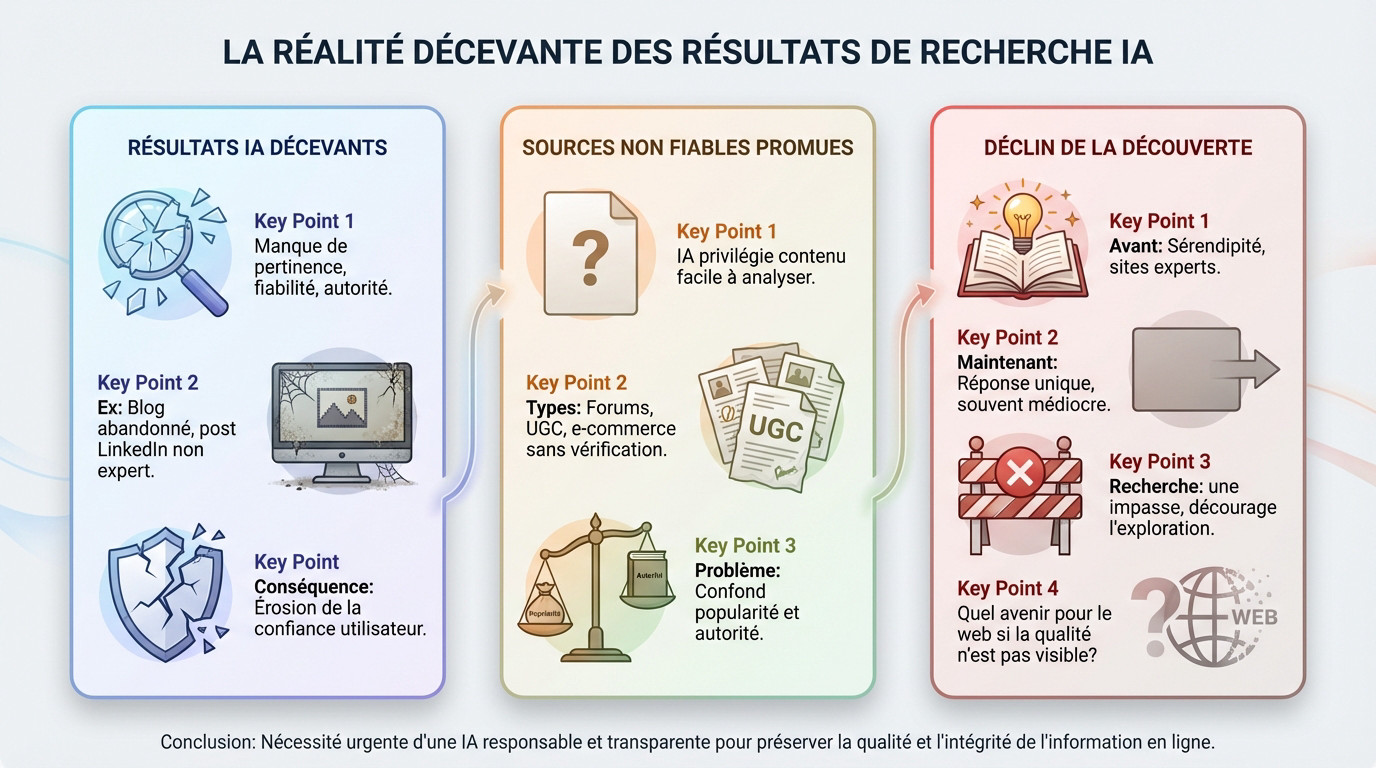

La réalité décevante des résultats de recherche IA

Le concept de « garbage AI SERPs » en pratique

Les « Garbage AI SERPs » désignent des résultats générés par l’intelligence artificielle manquant cruellement de pertinence. Ces réponses automatisées souffrent d’un déficit de fiabilité, contrastant nettement avec les promesses d’exactitude des modèles actuels.

Prenons une requête sur des conseils de style ou de bricolage. L’IA met souvent en avant un blog personnel délaissé depuis des années ou une publication LinkedIn isolée. Aucune expertise n’est vérifiée dans ces sources pourtant présentées comme des références.

Ce phénomène n’est pas une anomalie isolée. Il constitue désormais une friction récurrente qui dégrade l’expérience utilisateur et la confiance.

La promotion de sources douteuses au détriment de l’expertise

Le problème dépasse la simple médiocrité technique : le système effectue une promotion active de sources non fiables. Les algorithmes semblent favoriser des contenus structurellement simples à ingérer, indépendamment de leur origine factuelle.

Des forums de discussion, des plateformes de contenu généré par les utilisateurs (UGC) ou des sites marchands dominent l’affichage. Ces plateformes opèrent souvent sans processus rigoureux de vérification éditoriale ou scientifique.

L’état actuel des google ai serps révèle une faille majeure. L’algorithme confond la popularité virale ou la simplicité syntaxique avec une véritable autorité thématique.

Une perte nette pour la découverte de contenu de qualité

La « sérendipité » qui caractérisait la recherche en ligne s’efface progressivement. Auparavant, l’utilisateur découvrait des sites de niche gérés par des passionnés. Aujourd’hui, le moteur impose une réponse unique, synthétique et souvent médiocre, masquant la diversité des experts derrière des menus secondaires.

L’expérience de recherche devient une impasse. L’IA fournit une réponse finale, décourageant l’exploration et la découverte de nouvelles sources fiables qui formaient la richesse du web.

Cette dynamique pose une question critique sur l’avenir du web. La création de contenu expert perd sa récompense principale : la visibilité.

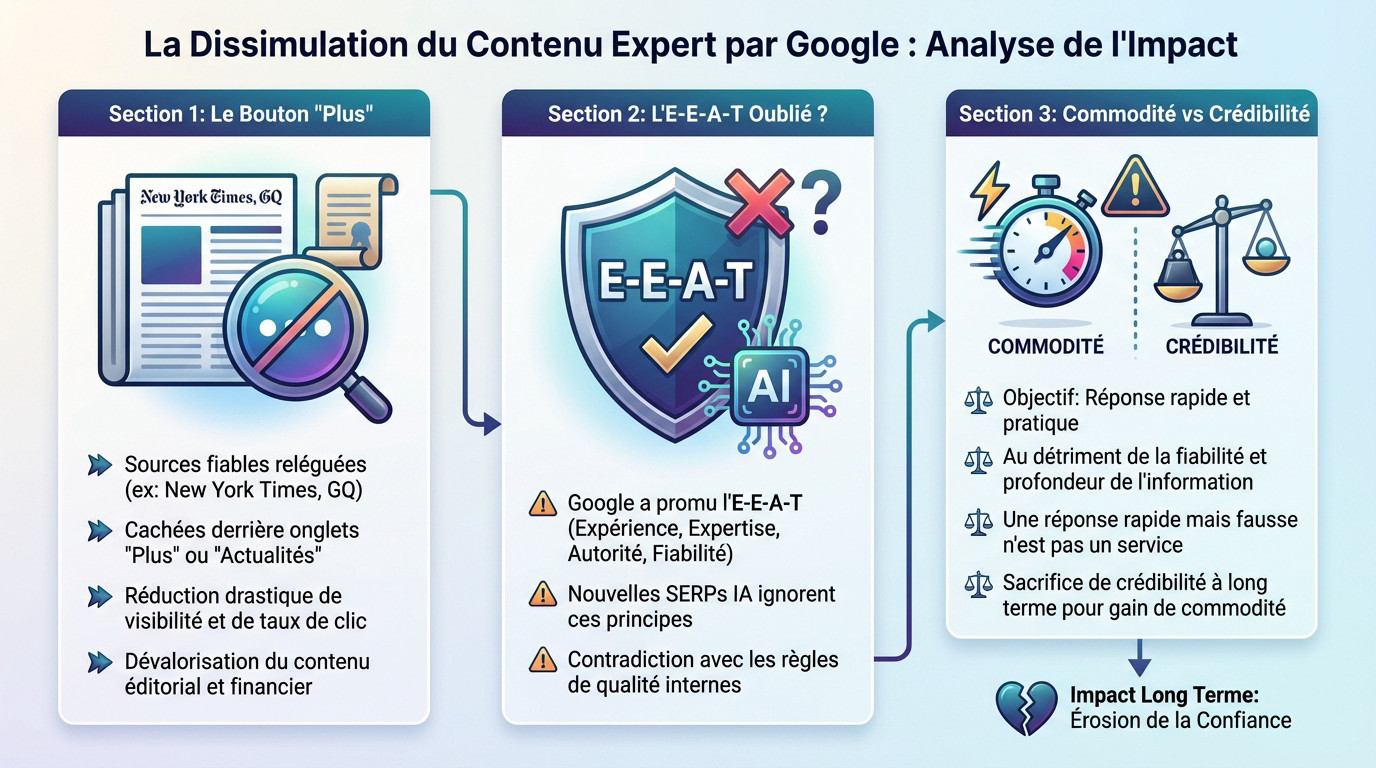

Comment Google dissimule les contenus d’experts

Le bouton « Plus » : le cimetière des sources fiables

Les algorithmes de classement actuels ne suppriment pas totalement les publications journalistiques majeures comme le New York Times ou GQ. Le système relègue simplement ces entités vers des zones de moindre visibilité. Ces sources expertes perdent leur positionnement prioritaire dans les résultats principaux.

L’accès à ces informations vérifiées nécessite désormais des actions manuelles supplémentaires de la part de l’utilisateur. Elles se trouvent masquées derrière des onglets secondaires et peu intuitifs tels que « Plus » ou « Actualités ». Cette architecture d’interface réduit drastiquement leur visibilité et effondre le taux de clic.

Ce choix de design dévalorise activement le contenu qui demande un effort éditorial et financier conséquent.

Le principe E-E-A-T : un concept oublié par l’IA ?

Le concept E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) constitue le pilier central des recommandations de Google depuis plusieurs années. Le moteur de recherche incite fortement les éditeurs à investir massivement pour démontrer ces signaux de qualité et de légitimité technique.

Une contradiction technique apparaît pourtant dans le déploiement des nouvelles `google ai serps`. Ces modèles génératifs favorisent souvent des sources qui contredisent directement les exigences de l’E-E-A-T, privilégiant des contenus synthétiques.

Google a pourtant durci ses règles contre les contenus trompeurs, mais son IA ne semble pas suivre la même logique.

La commodité apparente au détriment de la crédibilité

La stratégie actuelle vise prioritairement à fournir une réponse immédiate et pratique à l’utilisateur directement sur la page. L’objectif technique consiste à réduire la friction et à simplifier l’expérience de recherche globale.

Cette optimisation pour la vitesse s’effectue souvent au détriment de la fiabilité et de la profondeur de l’information. Une réponse instantanée générée par l’IA perd toute valeur si elle manque de précision factuelle ou de nuance contextuelle.

Google semble ainsi sacrifier sa crédibilité historique sur le long terme pour un gain de commodité à court terme.

Les conseils SEO de Google : un écran de fumée ?

Face à la dégradation de la qualité des résultats, la communication officielle de Google déroute et semble ignorer les enjeux prioritaires.

Le débat sur le « chunking » : une diversion technique

Dans le podcast Search Off The Record, Danny Sullivan et John Mueller déconseillent aux éditeurs de fragmenter leur contenu, ou « chunking », spécifiquement pour plaire aux LLMs.

Ce conseil technique apparaît comme une diversion. La problématique centrale ne réside pas dans la méthode de découpage, mais dans la probabilité réelle que ce contenu sera un jour visible face aux google ai serps.

Ce débat agit comme un écran de fumée. Il détourne l’attention de la qualité médiocre des réponses générées par l’intelligence artificielle.

La minimisation des signaux GEO : une erreur stratégique

Parallèlement, Google semble réduire l’impact des signaux géographiques (GEO). Cette orientation diminue la pertinence locale des résultats proposés aux internautes.

Cette approche manque de logique pour des millions de requêtes. La localisation est un facteur de pertinence essentiel pour les entreprises de proximité, les actualités régionales et les spécificités culturelles.

L’homogénéisation des résultats pénalise l’utilisateur final et les acteurs économiques locaux. Cette tendance s’inscrit dans un changement plus global de la gestion des résultats par pays.

Le fossé entre le discours officiel et la réalité des SERPs

Un décalage flagrant existe aujourd’hui. Google exhorte à produire un contenu « écrit pour les humains », alors que son IA propulse souvent des pages qui ignorent ce principe fondamental.

- Discours de Google : « Créez du contenu utile et centré sur l’humain. »

- Réalité de l’IA : Le système valorise des contenus non-experts et masque les sources fiables.

- Conséquence : Les éditeurs naviguent à vue sans savoir quelles règles suivre.

Cette incohérence structurelle rend l’élaboration de toute stratégie SEO durable particulièrement complexe et incertaine.

Les conséquences concrètes pour les éditeurs et le web

La chute du trafic organique : une menace existentielle

Le mécanisme s’avère redoutable pour la visibilité en ligne. Les réponses « zéro-clic » fournies par les AI Overviews captent l’utilisateur directement sur la page de résultats. L’internaute obtient sa réponse sans jamais visiter le site source.

Les chiffres confirment l’urgence de la situation actuelle. Les marques non préparées risquent une baisse de trafic de 20% à 50%. C’est le constat alarmant dressé selon une analyse de McKinsey sur les mutations des moteurs de recherche.

C’est un véritable choc SEO pour de nombreux sites dont le modèle économique repose sur ce trafic.

Le désengagement des créateurs de contenu expert

Pourquoi investir du temps et de l’argent dans un contenu de fond si personne ne le voit ? Cette question rhétorique freine désormais les investissements éditoriaux.

Le cercle vicieux s’enclenche très rapidement pour les médias. Moins de trafic signifie moins de revenus, ce qui réduit les moyens et la motivation pour produire du contenu de haute qualité. La rentabilité des sites s’effondre mécaniquement.

Le risque à terme est un appauvrissement général de la qualité de l’information disponible sur le web.

L’érosion de la confiance envers l’écosystème Google

La confiance reste une monnaie fragile à deux sens. Les utilisateurs perdent confiance dans la pertinence des résultats, souvent déçus par la qualité des google ai serps.

Mais les éditeurs et les experts SEO perdent aussi confiance en Google comme partenaire. Les changements unilatéraux et la dévalorisation de leur travail créent un climat de défiance inédit et durable dans l’industrie.

Google risque de scier la branche sur laquelle il est assis. Sans un écosystème de créateurs de contenu riche et diversifié, son propre produit de recherche perdra sa valeur.

Les utilisateurs remarquent le problème et cherchent des alternatives

Et il n’y a pas que les professionnels du web qui s’inquiètent. Les utilisateurs finaux commencent eux aussi à percevoir cette baisse de qualité et à réagir.

Une « dégradation » perçue de l’expérience de recherche

Les internautes ne sont pas dupes. Beaucoup perçoivent l’arrivée massive de ces fonctionnalités génératives non comme une évolution positive, mais comme une franche « dégradation » du service historique.

Le problème majeur reste la fiabilité douteuse et les « hallucinations » fréquentes de l’IA. Le gain de temps promis devient totalement illusoire s’il faut vérifier chaque information manuellement.

Ce sentiment de ras-le-bol technique sature désormais les forums, comme le montrent des discussions virulentes sur Hacker News.

La chasse aux astuces pour désactiver les résultats IA

Un signe qui ne trompe pas sur l’état du marché est la multiplication soudaine des tutoriels et astuces pour retrouver l’ancienne interface épurée de Google.

Les utilisateurs s’échangent désormais des méthodes de contournement techniques :

- Utiliser le paramètre d’URL `udm=14` pour forcer l’affichage web classique.

- Ajouter des opérateurs de recherche négatifs inhabituels pour « casser » l’IA.

- Installer des extensions de navigateur dédiées à la suppression des AI Overviews.

Que le grand public déploie de tels efforts pour éviter une fonctionnalité phare démontre l’ampleur de leur mécontentement.

La montée en puissance des moteurs de recherche concurrents

La domination de Google n’est plus absolue. Des alternatives crédibles… gagnent rapidement en popularité auprès des déçus.

Ces concurrents attaquent le géant sur ses faiblesses, proposant une meilleure citation des sources ou des interfaces sans bruit.

Chaque utilisateur frustré par la qualité médiocre des Google AI SERPs est aujourd’hui un client potentiel pour la concurrence.

S’adapter à l’ère des SERPs IA : quelles stratégies pour demain ?

Face à ce constat peu réjouissant, rester passif n’est pas une option. Il faut comprendre la nouvelle dynamique pour tenter d’adapter sa stratégie.

Accepter la volatilité des citations IA

Les données récentes montrent une instabilité significative des sources affichées par les algorithmes génératifs. Pour une requête identique, les sites référencés dans un aperçu peuvent changer radicalement en l’espace de quelques jours.

Viser une citation permanente devient illusoire dans l’écosystème instable des google ai serps. La stratégie doit évoluer pour maximiser la probabilité d’apparition sur un ensemble de requêtes, plutôt que de défendre une position fixe.

Cette volatilité implique une production de contenu soutenue et une veille technique constante, rendant le travail SEO encore plus exigeant.

Penser au-delà du SEO : l’émergence du GEO

Le GEO, ou « Generative Engine Optimization », désigne un ensemble de tactiques visant à influencer les réponses des modèles d’IA. Il ne s’agit plus seulement de classement, mais de façonner la synthèse d’information proposée à l’utilisateur.

Cette approche dépasse largement le cadre du SEO traditionnel. Elle exige une structuration rigoureuse des données, une clarté syntaxique absolue et une présence active sur de multiples plateformes pour être captée par les modèles.

Le GEO est devenu un point central des stratégies marketing modernes.

Le renforcement de l’autorité et de la marque comme rempart

Face à l’incertitude des algorithmes, la construction d’une marque forte et une autorité reconnue constitue la meilleure défense. Les systèmes d’IA privilégient les entités identifiées comme référentes et fiables dans leur secteur.

Les éditeurs doivent impérativement construire une audience directe via newsletters et réseaux sociaux pour réduire leur dépendance à Google. L’objectif est de devenir une source que les utilisateurs recherchent spécifiquement par son nom.

En fin de compte, l’impact des AI Overviews sur le SEO nous force à revenir aux fondamentaux du marketing.

La dégradation qualitative des SERPs IA impose une révision majeure des stratégies SEO. Google privilégie la réponse immédiate via les LLMs, sacrifiant souvent la visibilité des sources expertes.

Face à cette volatilité, les éditeurs doivent renforcer leur autorité de marque et intégrer les signaux GEO pour maintenir leur audience. Vous vous demandez comment adapter votre stratégie ? Appelez Uplix dès maintenant pour faire le point ensemble et bâtir un plan d’action solide et pérenne.