L’essentiel à retenir : face à la saturation du contenu générique, Google privilégie désormais l’expérience vécue et l’expertise démontrée (E-E-A-T). Pour maintenir sa visibilité dans les AI Overviews, l’adoption d’une stratégie « people-first » et l’optimisation pour les moteurs génératifs (GEO) deviennent impératives. Cette mutation vise à réduire de 40 % le contenu non original, imposant une différenciation par la valeur ajoutée unique.

La saturation des pages de résultats par des textes automatisés menace-t-elle la pérennité du trafic organique des sites web ? Pour contrer cette baisse de visibilité, le moteur de recherche impose désormais de produire un contenu original expertise google capable de se distinguer des réponses génériques de l’IA. Cette analyse technique décrypte les nouveaux standards E-E-A-T et détaille les ajustements stratégiques indispensables pour maintenir ses positions face aux moteurs génératifs.

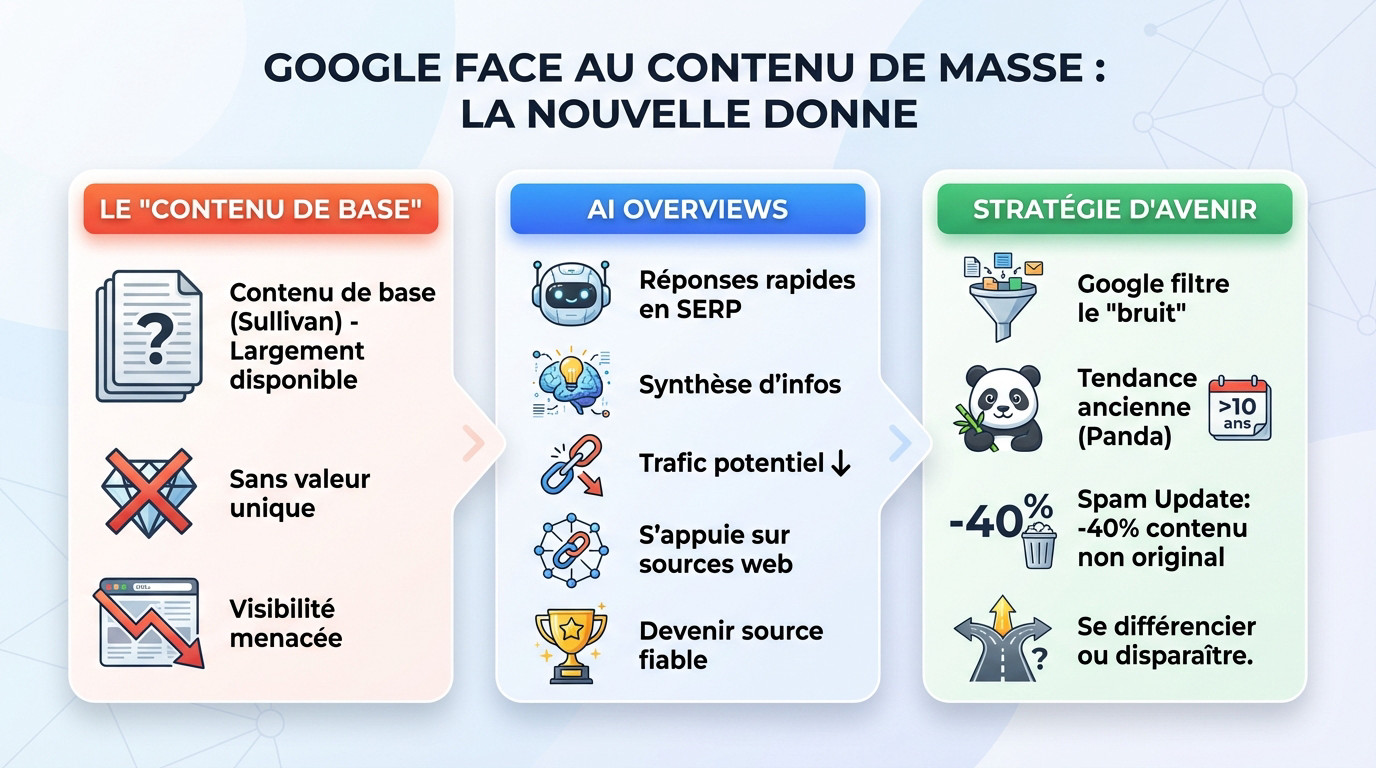

Google face au contenu de masse : la nouvelle donne

Google modifie radicalement son approche pour filtrer le bruit numérique et valoriser la véritable valeur ajoutée.

Le « contenu de base » : l’ennemi identifié par Google

Danny Sullivan définit le « contenu de base » comme des informations génériques sans perspective singulière. Il cite souvent les horaires du Super Bowl ou les solutions de jeux de mots. Ce type de donnée est largement disponible et ne nécessite aucune expertise particulière.

La valeur de ces pages s’effondre mécaniquement. Les AI Overviews répondent désormais immédiatement à ces requêtes simples directement dans la SERP. Les sites qui basent leur trafic sur ces informations factuelles voient leur visibilité menacée.

Google ne sanctionne pas l’usage de l’IA, mais le résultat final. Produire du contenu sans valeur unique, qu’il soit généré par une machine ou un humain, conduit à l’invisibilité.

L’avènement des AI Overviews et leur impact sur la visibilité

Les AI Overviews constituent la réponse technique de Google au besoin de rapidité. Ces résumés synthétisent l’information directement en haut de page. L’utilisateur accède à la réponse sans effort de navigation.

Pour les éditeurs de sites, la conséquence est une baisse potentielle du trafic entrant. L’internaute obtient satisfaction sans cliquer sur un lien traditionnel. Ce phénomène affecte principalement les requêtes informationnelles simples.

Pourtant, ces aperçus générés par les LLMs s’appuient toujours sur des données existantes. Le nouvel enjeu stratégique est de devenir l’une de ces sources fiables et citées. Cela exige désormais une densité d’information supérieure.

Pourquoi le lutte actuelle contre le contenu générique est une impasse stratégique

La lutte actuelle contre le contenu générique prolonge une logique ancienne. Le moteur cherche constamment à épurer ses résultats. L’algorithme Google Panda ciblait déjà le contenu de faible qualité il y a plus d’une décennie.

Cette philosophie n’est pas nouvelle, mais les outils de détection sont plus performants. La stratégie gagnante repose sur l’association contenu original expertise google. La situation actuelle n’est qu’une accélération technologique de cette tendance de fond.

Les récentes mises à jour, comme la « Spam Update », visent explicitement à réduire la masse de contenu non original. Google a annoncé vouloir réduire de 40% ce type de contenu dans ses index, chiffre qui a finalement atteint 45%.

Le contenu qui se contente de reformuler ce qui existe déjà n’a plus sa place. Pour survivre, il faut se différencier ou disparaître du résultat organique.

L’E-E-A-T comme boussole : l’expertise au centre de la stratégie

L’expérience vécue (le premier « E ») : le nouveau rempart anti-ia

Dans l’acronyme E-E-A-T, le « E » initial pour Expérience s’impose désormais comme le filtre majeur. Les modèles de langage traitent l’information brute mais ne ressentent rien. L’IA simule la compétence technique sans vécu. Seul l’humain possède l’épreuve du réel nécessaire pour convaincre.

Google définit ce critère par l’usage concret d’un produit ou la visite physique d’un lieu. Il s’agit de la preuve irréfutable par le terrain. L’auteur doit montrer qu’il connait son sujet physiquement.

Cette nuance transforme un article standard en un témoignage authentique. L’algorithme valorise cette valeur ajoutée unique pour l’utilisateur final. C’est ce qui distingue une page utile d’une copie générique sans âme.

La « voix unique » : un signal de qualité confirmé par John Mueller

John Mueller confirme l’importance capitale d’une voix unique pour le référencement actuel. Google cherche une perspective singulière dans chaque publication. Le mimétisme algorithmique ne suffit plus pour se positionner durablement dans les résultats.

Une voix unique se traduit par un style d’écriture propre et des opinions tranchées. L’analyse personnelle remplace la simple compilation de faits disponibles ailleurs. La marque imprime sa personnalité distincte.

Cette singularité constitue un signal fort d’originalité pour les moteurs de recherche. Elle rend le contenu original expertise google difficilement réplicable par une machine. Le lecteur retient une identité spécifique et non une réponse standard.

Comment Google évalue la fiabilité et l’autorité (E-A-T)

L’expérience seule ne suffit pas sans l’appui de l’Expertise, de l’Autorité et de la Fiabilité. Ces piliers structurent la crédibilité globale d’un site web. Google analyse la cohérence entre le vécu et la connaissance technique. La confiance reste le socle du classement.

Le moteur de recherche scanne des signaux précis pour valider ces attributs qualitatifs. La réputation de l’auteur et les citations externes servent de preuves tangibles. La transparence des sources renforce le score de qualité global. L’anonymat nuit souvent à la performance.

Ces critères permettent de comprendre comment Google repère les contenus de faible qualité générés massivement. Un site démontrant un fort E-E-A-T évite les filtres anti-spam. La fiabilité protège contre les pertes de visibilité soudaines. L’algorithme favorise les entités responsables.

Transformer l’expérience en preuve : les méthodes qui fonctionnent

Aller au-delà des affirmations : documenter ses processus

Le principe est simple : « montrer, ne pas juste dire ». Affirmer son expertise ne suffit plus aujourd’hui. Il faut la démontrer de manière tangible.

Cela consiste à détailler ses propres méthodes de travail. L’auteur partage des tutoriels basés sur des projets réels ou décrit les étapes techniques d’une analyse spécifique.

Le lecteur comprend ainsi comment l’expert est parvenu à ses conclusions. Cette transparence construit la confiance nécessaire et prouve l’expérience de première main sur le sujet traité.

Intégrer des données propriétaires et des études de cas

Les données propriétaires sont une mine d’or pour l’originalité. Il s’agit d’informations que seul le créateur possède, issues de ses propres recherches ou de son activité.

Les études de cas constituent une autre forme de preuve puissante. Elles illustrent l’expertise en action à travers un exemple concret, incluant un problème, une solution et des résultats.

Pour aligner votre stratégie sur le contenu original et l’expertise que Google valorise, intégrez ces éléments factuels :

- Partage de résultats de tests A/B sur des campagnes.

- Publication de statistiques internes anonymisées.

- Analyse détaillée d’un cas client (avec autorisation).

- Présentation d’une méthodologie de travail unique et développée en interne.

Les « coulisses » de la création : un gage d’authenticité

Montrer les coulisses de la création de contenu ou d’un produit renforce l’authenticité. Cela peut prendre la forme de photos brutes ou de vidéos documentant le processus.

Pour un article, cela peut être aussi simple que d’expliquer la démarche de recherche. L’auteur cite les sources originales et les outils spécifiques qui ont été consultés.

Cette transparence crée un lien avec le lecteur et prouve que le contenu n’est pas une simple reformulation, mais le fruit d’un véritable travail. Il en va de même pour les images originales plutôt que les banques d’images.

Adapter sa stratégie de contenu pour l’avenir

La supervision humaine : un signal de qualité non négociable

Google ne punit pas l’usage de l’IA pour générer des textes. Il sanctionne plutôt le manque de valeur ajoutée, peu importe la source. Produire un contenu original expertise Google exige une intervention réelle. La supervision humaine est donc la clé.

Tout texte assisté par machine doit être révisé par un spécialiste. L’outil génératif propose une base, mais ne remplace pas l’auteur. L’IA reste un support technique, jamais un rédacteur autonome.

Cette touche humaine injecte le vécu et la nuance nécessaires aux algorithmes. C’est un point central pour un guide sur le contenu IA et le SEO qui vise la performance durable.

Diversifier les formats pour incarner l’expertise

L’autorité ne se limite pas aux mots écrits sur une page. Google suggère de varier les supports pour combler les attentes des internautes. La diversification devient un atout majeur.

Les vidéos et les podcasts constituent des leviers puissants pour prouver une maîtrise technique. Ils permettent d’incarner un savoir-faire par une voix ou un visage. Ils créent un lien direct impossible à l’écrit.

Ces formats performent aussi sur des surfaces comme Discover, offrant plus de portée. La visibilité sur Google Discover dépend aussi de l’originalité du format proposé aux audiences cibles.

Penser « people-first » à chaque étape de la création

La méthode « people-first » impose de créer pour les visiteurs, pas pour les robots. Google conseille aux créateurs de contenu de privilégier l’originalité et l’expertise authentique pour maintenir leur visibilité dans les expériences de recherche basées sur l’IA. L’objectif est de satisfaire l’intention de recherche.

Il faut vérifier si la page aide concrètement l’internaute qui la consulte. Une réponse partielle ou générique échoue à retenir l’attention. L’intention de recherche doit guider toute la production éditoriale du site.

Un contenu créé pour l’humain, avec une réelle valeur ajoutée, sera naturellement récompensé par les algorithmes, car il répond à leur objectif premier : satisfaire l’utilisateur.

S’adapter aux nouveaux formats : l’optimisation pour les moteurs génératifs (GEO)

Comprendre le Generative Engine Optimization (GEO)

Le référencement traditionnel évolue vers une nouvelle ère technique. Une approche distincte émerge désormais : le Generative Engine Optimization (GEO). Les méthodes classiques perdent de leur efficacité.

Il s’agit d’adapter son contenu pour qu’il soit bien classé et visible. Il doit être facilement compris, synthétisé et cité par les IA. Le GEO est l’optimisation pour les IA génératives qui permet cette reconnaissance.

L’objectif du GEO est de positionner son contenu comme une source d’autorité. Il devient une référence pour les modèles de langage de Google. C’est une composante clé d’une stratégie de contenu efficace pour l’avenir.

Créer des « capsules d’information » denses et fiables

Le contenu doit être « résumable » pour être cité dans un AI Overview. Cela signifie qu’il doit contenir des blocs d’information clairs. La concision technique est ici obligatoire.

Il faut penser en termes de « capsules d’information » autonomes et précises. Ces paragraphes répondent de manière directe et factuelle à une question spécifique. La structure doit isoler la réponse.

L’expertise doit être distillée dans des formats courts et très denses en valeur. La clarté et la précision factuelle sont les qualités recherchées. Un contenu original expertise google favorise cette visibilité technique.

L’importance de la structuration des données

Une bonne structuration aide les robots de Google à comprendre la hiérarchie. Elle clarifie le sens de l’information sur une page. Les IA exploitent ce schéma logique.

L’utilisation correcte des balises de titre guide l’analyse sémantique du contenu. Les listes et les mises en gras signalent les points clés. Le balisage technique reste prioritaire.

L’organisation des données facilite leur traitement par les algorithmes de synthèse. Voici les éléments techniques à intégrer pour optimiser la lecture machine. Ces pratiques renforcent la pertinence du document. L’application de ces règles s’impose.

- Rédiger des réponses directes et factuelles aux questions clés.

- Utiliser des titres et sous-titres clairs et descriptifs.

- Structurer les énumérations.

- Fournir des définitions concises pour les termes techniques.

Auditer son existant : traquer et améliorer le contenu à faible valeur

Comment identifier le contenu superficiel sur son site

L’analyse commence par un crawl complet pour débusquer le « thin content ». Ces pages se caractérisent par un volume de texte insuffisant, une valeur ajoutée inexistante ou une simple duplication. Elles polluent l’index sans servir l’utilisateur.

Les indicateurs de performance trahissent souvent ces pages faibles. Un temps de lecture quasi nul, un taux de rebond excessif et une absence totale de visibilité sur des mots-clés stratégiques doivent alerter.

La question centrale reste l’utilité réelle de l’URL pour l’internaute. Si elle ne répond à aucune intention précise, elle doit évoluer. Identifier le contenu superficiel constitue la première étape de l’assainissement.

Les questions d’auto-évaluation de Google (« qui, comment, pourquoi »)

Google propose une grille de lecture précise pour juger la pertinence d’une page. Elle s’articule autour de trois interrogations simples mais impitoyables : Qui, Comment, et Pourquoi. C’est le filtre de qualité.

Cette méthode oblige à justifier la légitimité de chaque publication. Elle sonde l’autorité réelle de l’auteur, la rigueur du processus de rédaction et la finalité profonde du contenu mis en ligne.

- Qui a créé le contenu ? L’auteur est-il un expert reconnu sur le sujet ? La biographie de l’auteur est-elle claire ?

- Comment le contenu a-t-il été créé ? expérience de première main, des sources originales, ou est-ce une simple compilation ?

- Pourquoi ce contenu a-t-il été créé ? L’objectif principal est-il d’informer et d’aider l’utilisateur, ou de se classer dans les moteurs de recherche ?

Mettre en place un processus de mise à jour et d’enrichissement

L’audit technique ne suffit pas s’il reste une action isolée. Il doit s’intégrer dans un processus continu de maintenance et d’élévation des standards. La qualité se surveille en permanence.

Le sort des pages faibles se joue entre suppression, fusion ou réécriture complète. L’objectif est d’injecter du contenu original et une expertise validée par Google pour transformer ces poids morts en actifs performants.

Cette rigueur éditoriale envoie un signal positif fort aux algorithmes de classement. Elle démontre un souci constant de fiabilité et de pertinence. C’est le cœur de l’optimisation de contenu durable.

L’avenir du référencement organique exige une rupture avec le contenu de masse. Face aux AI Overviews, seule l’expertise démontrée via le cadre E-E-A-T garantit la visibilité.

L’adoption du GEO et la valorisation de l’expérience humaine deviennent indispensables. Les stratégies SEO durables privilégient désormais l’authenticité et la supervision humaine pour satisfaire les algorithmes.

FAQ

Qu’est-ce que Google considère comme du contenu de faible qualité ?

Google identifie le contenu de faible qualité, souvent qualifié de « basic content », comme une production générique sans valeur ajoutée unique. Il s’agit principalement de reformulations d’informations existantes ou de réponses à des faits simples que les modèles d’IA (LLMs) peuvent générer instantanément. Les algorithmes de classement pénalisent ces pages car elles ne satisfont pas l’exigence d’originalité attendue par le moteur de recherche.

Quels sont les principes fondamentaux de l’E-E-A-T ?

Le concept E-E-A-T repose sur quatre piliers essentiels pour le SEO : l’Expérience, l’Expertise, l’Autorité et la Fiabilité (Trustworthiness). L’Expérience constitue désormais le levier principal pour se différencier de l’intelligence artificielle. Elle exige la démonstration d’un vécu tangible, comme l’utilisation réelle d’un produit ou la visite d’un lieu, prouvant ainsi une connaissance de première main impossible à simuler authentiquement par une machine.

Comment adapter sa stratégie de contenu aux AI Overviews ?

L’adaptation aux AI Overviews requiert l’application du Generative Engine Optimization (GEO). Cette approche technique favorise la structuration du contenu en « capsules d’information » claires et factuelles, facilitant leur synthèse par les algorithmes génératifs. Pour maintenir la visibilité, il est impératif de fournir des données propriétaires et des analyses expertes qui positionnent le site comme une source d’autorité incontournable citée dans les résumés.