Ce qu’il faut retenir : le bourrage de mots-clés est une technique Black Hat obsolète, sévèrement pénalisée par Google. Le référencement moderne exige une approche sémantique riche et naturelle, centrée sur l’intention de recherche plutôt que sur la densité. Cette stratégie favorise l’expérience utilisateur et s’aligne avec les critères E-E-A-T pour un classement durable.

L’utilisation persistante du bourrage mots clés seo expose les sites web à des pénalités automatiques et à une perte significative de trafic organique. Cette analyse technique démontre pourquoi la simple densité de répétition ne trompe plus les algorithmes actuels, désormais focalisés sur la compréhension sémantique globale. L’article détaille les mécanismes de détection utilisés par Google et définit les stratégies d’optimisation légitimes pour garantir un référencement pérenne.

Bourrage de mots-clés : une technique SEO révolue et pénalisée

Définition du keyword stuffing

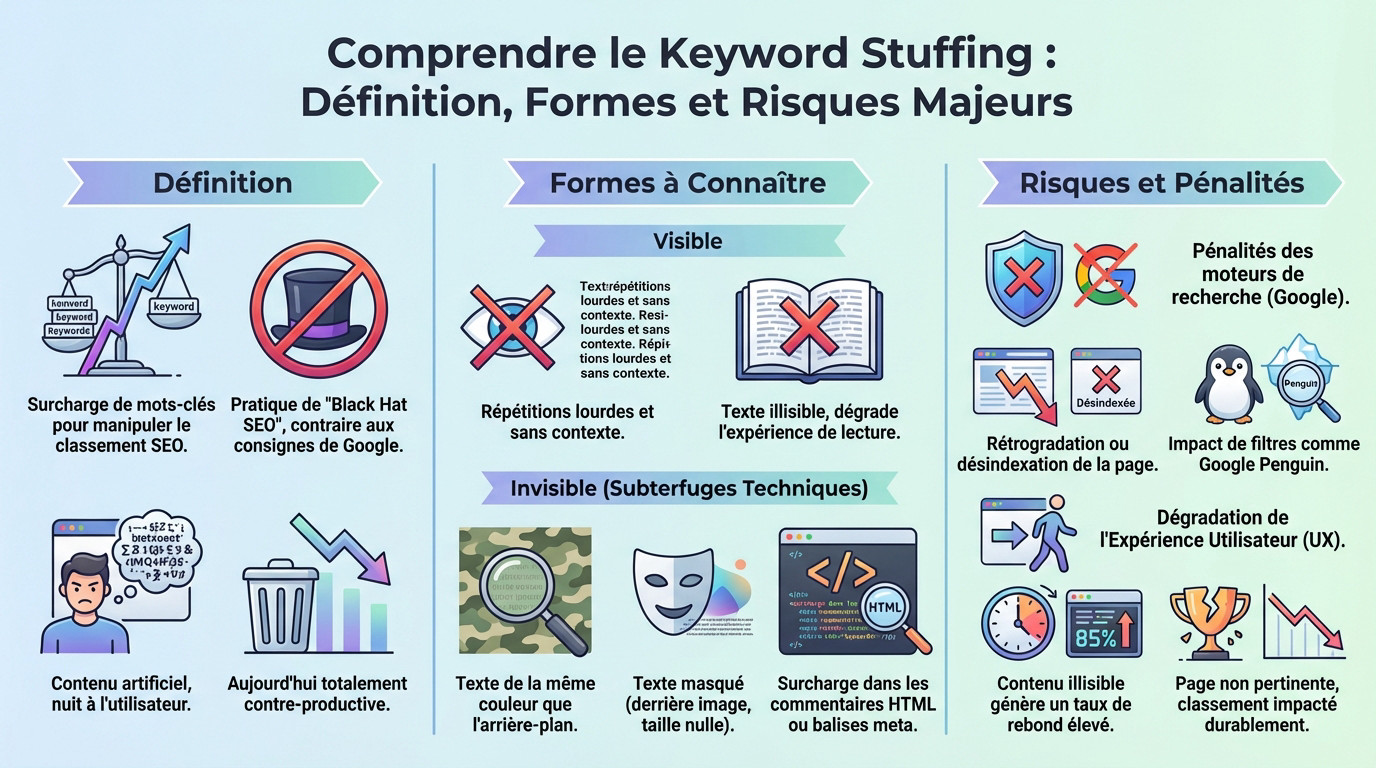

Le bourrage de mots-clés se définit comme la surcharge excessive d’une page web avec des termes spécifiques. L’objectif unique de cette manœuvre consiste à manipuler les algorithmes pour forcer un classement artificiel dans les résultats de recherche.

Les spécialistes classent cette pratique dans la catégorie du black hat SEO. Elle contrevient directement aux consignes de qualité édictées par Google, générant un contenu artificiel sans valeur pour l’internaute. Il est recommandé de consulter une définition complète du keyword stuffing pour saisir l’étendue de cette manipulation technique.

Si cette méthode a pu fonctionner par le passé, elle s’avère aujourd’hui totalement contre-productive pour la visibilité numérique.

Les formes de sur-optimisation à connaître

On distingue deux catégories principales de bourrage mots clés seo : la forme visible et la forme invisible. La première altère directement la lecture, tandis que la seconde tente de tromper les robots d’indexation sans alerter le visiteur.

La surcharge visible se manifeste par des répétitions lourdes et dépourvues de contexte sémantique. Le texte devient rapidement illisible, perdant ainsi toute crédibilité aux yeux du lecteur humain.

Le bourrage invisible repose sur des subterfuges techniques dissimulés dans le code ou l’affichage. Les moteurs de recherche identifient désormais ces tentatives de manipulation :

- Texte rédigé de la même couleur que l’arrière-plan de la page.

- Mots-clés masqués derrière une image ou utilisant une taille de police nulle.

- Surcharge abusive de termes dans les commentaires HTML ou les balises meta.

Les risques : pénalités et dégradation de l’expérience utilisateur

Les moteurs de recherche, Google en tête, appliquent des sanctions strictes contre ces pratiques. Une page incriminée subit souvent une rétrogradation significative ou une désindexation totale. L’historique de l’algorithme Google Penguin démontre la volonté ferme du moteur de lutter contre ce spam web.

Le second risque majeur concerne la dégradation de l’expérience utilisateur (UX). Un contenu saturé et illisible provoque une fuite immédiate des visiteurs, ce qui entraîne un taux de rebond élevé.

Ces signaux comportementaux négatifs confirment aux algorithmes que la page manque de pertinence. Le classement du site en souffre alors durablement.

La fin de la densité de mots-clés : l’ère de l’intelligence sémantique

Pourquoi la densité est un indicateur obsolète

La « densité de mots-clés » appartient désormais au passé du SEO. Se concentrer sur un pourcentage précis d’occurrence est une perte de temps absolue pour les éditeurs de sites. Ce calcul mathématique n’a plus aucune valeur stratégique.

Cette métrique était pertinente pour les moteurs rudimentaires des années 2000, qui se basaient sur un comptage simple pour indexer les pages. Aujourd’hui, elle n’est plus un facteur de classement. Google ignore totalement ce ratio mathématique au profit de la qualité globale.

Adam Riemer résume parfaitement la situation actuelle concernant cette pratique désuète :

La densité de mots-clés est un concept dépassé et non un facteur de classement. Il n’existe pas de ‘règle magique’ ou de seuil précis pour l’optimisation.

L’évolution des algorithmes : de Panda à BERT

L’obsolescence de la densité s’explique par l’évolution drastique des algorithmes des moteurs de recherche ces quinze dernières années. Des mises à jour majeures ont tout changé. La mécanique de classement ne repose plus sur des statistiques lexicales basiques.

La mise à jour Panda a commencé à pénaliser massivement le contenu de faible qualité dès 2011. Le bourrage mots clés seo était une cible directe de ce filtre. Google a alors déclaré la guerre aux textes sur-optimisés.

Plus récemment, BERT et MUM ont donné à Google une capacité de compréhension quasi humaine du langage naturel. Ils analysent le contexte des phrases et les nuances. L’algorithme lit désormais entre les lignes.

Le passage de la correspondance exacte au contexte

Les moteurs modernes ne se contentent plus de chercher une correspondance exacte des mots-clés dans le texte. Ils interprètent l’intention de recherche réelle de l’utilisateur. Le but est de fournir la réponse la plus pertinente, pas la plus répétitive.

Ils comprennent les synonymes, les concepts liés et les relations sémantiques entre les mots grâce aux vecteurs. La richesse du vocabulaire est valorisée par rapport à la redondance. Un champ lexical varié signale une expertise réelle.

Répéter le même terme devient donc inutile pour le référencement. Pire, cela envoie un signal de contenu pauvre et artificiel. C’est exactement l’opposé de ce que l’algorithme recherche pour satisfaire l’internaute.

Optimisation sémantique : la bonne approche en 2026

Placer les mots-clés de manière stratégique

Les mots-clés conservent une fonction centrale pour le référencement naturel. Ils signalent le sujet principal d’une page aux algorithmes de classement. Négliger ces signaux revient à perdre une visibilité organique précieuse.

Leur placement exige une précision chirurgicale plutôt qu’une répétition mécanique. Ces termes agissent comme des balises de pertinence pour les moteurs.

Pour éviter le bourrage mots clés seo tout en maximisant la performance, l’intégration des termes cibles doit se faire sur les éléments techniques suivants :

- La balise de titre (Title)

- L’URL de la page

- Le titre principal (H1) et les sous-titres (H2, H3)

- Le texte alternatif des images (balise alt)

- Les ancres de liens internes

Enrichir le champ lexical au lieu de répéter

L’approche moderne repose sur l’enrichissement sémantique global du texte. L’usage de synonymes, de variations et de termes du même champ lexical renforce la pertinence. Google associe désormais ces concepts pour comprendre le sens.

Cette stratégie permet de couvrir un sujet en profondeur. Une telle densité informationnelle démontre à Google que le contenu est complet et expert.

Cette méthode aide à construire une structure thématique forte. C’est le principe derrière la construction d’un cocon sémantique efficace.

La structure des titres et la redondance

Une erreur courante consiste à vouloir répéter le mot-clé principal dans chaque sous-titre. Cette pratique s’avère inutile et rend la lecture maladroite.

La présence du mot-clé dans le H1 permet à Google de comprendre que les H2 et H3 traitent de sous-thématiques liées. La hiérarchie HTML suffit à établir le contexte. L’algorithme déduit la relation sémantique.

Les sous-titres doivent servir à répondre à des questions spécifiques. Ils structurent la pensée et améliorent la lisibilité pour l’utilisateur.

Rédiger pour l’utilisateur, le pilier du SEO moderne

La technique demeure un outil, mais la finalité reste l’humain. Le référencement actuel valorise avant tout la qualité de l’information et la valeur apportée au lectorat.

Privilégier un langage naturel et fluide

L’objectif prioritaire vise la satisfaction du lecteur humain. Le texte doit rester clair, agréable à parcourir et fournir une information utile. La lisibilité prime sur toute tentative d’optimisation technique.

Un test simple consiste à lire le contenu à voix haute. Une sonorité robotique ou artificielle impose une réécriture immédiate.

Cette logique s’aligne avec les recommandations actuelles.

Le bourrage de mots-clés nuit à l’expérience utilisateur. L’approche moderne consiste à privilégier un langage naturel et à se concentrer sur la rédaction pour le consommateur.

L’importance des signaux E-E-A-T

Google évalue la pertinence des pages via les critères E-E-A-T. Cet acronyme signifie Expertise, Expérience, Autorité et Fiabilité. Ces indicateurs valident la crédibilité d’une source. Les algorithmes favorisent désormais les contenus prouvant une réelle maîtrise du sujet.

Une page sur-optimisée éveille instantanément les soupçons des robots d’indexation. Ce manque de naturel signale une faible fiabilité et nuit à l’autorité globale. Le classement du site en souffre directement.

Investir dans la qualité du contenu E-E-A-T garantit une meilleure rentabilité sur la durée. Cette stratégie dépasse les tactiques de manipulation à court terme. La confiance des utilisateurs se construit patiemment.

Des pratiques à abandonner définitivement

Des techniques archaïques persistent encore aujourd’hui. Le bourrage mots clés seo s’avère non seulement inefficace, mais dangereux pour le domaine. Ces méthodes exposent le site à des sanctions lourdes.

Les listes de termes insérées en pied de page illustrent cette dérive. L’abus d’ancres optimisées dans le maillage interne constitue un autre signal négatif. Google identifie ces schémas artificiels très rapidement.

L’heure est à la concentration sur des pratiques SEO fondamentales et durables. Le jeu du chat et de la souris avec les algorithmes est révolu. La pérennité du site en dépend.

Bourrage de mots-clés face aux IA génératives

L’impact sur les « AI Overviews » de Google

Les « AI Overviews » constituent des réponses directes générées par l’intelligence artificielle en tête des résultats. Ces résumés synthétisent les informations les plus pertinentes disponibles sur le web. Le système utilise des modèles avancés comme Gemini pour l’analyse.

Une page doit présenter une structure factuelle et claire pour être sélectionnée comme source. L’algorithme privilégie les contenus faciles à analyser techniquement. La richesse sémantique prime sur la répétition de termes. L’autorité du domaine joue un rôle déterminant dans ce processus de sélection.

Le bourrage mots clés seo représente l’antithèse absolue de ce que recherchent ces systèmes. Cette pratique entraîne l’exclusion systématique des sources au profit de pages fiables. La densité artificielle nuit à la compréhension contextuelle par l’IA.

Pourquoi la qualité du contenu prime plus que jamais

Les modèles d’IA actuels sont entraînés spécifiquement pour identifier et ignorer le contenu de faible qualité. La manipulation algorithmique devient plus facile à détecter que jamais auparavant. Les techniques de spam échouent face à l’analyse sémantique. La pertinence contextuelle reste le critère numéro un.

Fournir la meilleure réponse possible constitue le seul moyen de figurer dans ces nouvelles expériences. La clarté et l’utilité de l’information dominent les classements. Les moteurs valorisent désormais l’expertise réelle et la profondeur du sujet traité.

Penser à l’optimisation de contenu pour l’IA revient aujourd’hui à se concentrer sur l’excellence éditoriale. Les objectifs du référencement et de la qualité rédactionnelle convergent totalement. Une approche centrée sur l’utilisateur satisfait simultanément les algorithmes.

Adapter sa stratégie de contenu pour l’avenir

La stratégie de contenu doit impérativement s’adapter à cette nouvelle ère conversationnelle. La création de contenu utile devient le seul levier viable pour le trafic. Les tactiques de répétition laissent place à la couverture sémantique.

L’objectif principal consiste à devenir une source d’autorité incontestable sur sa thématique. C’est précisément ce signal d’expertise que l’IA cherche à identifier.

Une adaptation efficace repose sur trois piliers fondamentaux pour structurer l’information :

- Répondre directement aux questions : Structurer le contenu pour offrir des réponses claires et concises.

- Fournir des données factuelles : Appuyer les affirmations avec des faits et des chiffres vérifiables.

- Maintenir une structure logique : Utiliser des titres et des paragraphes courts pour une lisibilité maximale.

Le bourrage de mots-clés constitue une technique révolue, sanctionnée par les moteurs de recherche. La stratégie SEO actuelle exige une approche centrée sur l’optimisation sémantique et l’expérience utilisateur. Produire un contenu naturel et pertinent reste la seule méthode viable pour garantir une indexation pérenne face aux évolutions algorithmiques et aux IA génératives.

FAQ

Qu’est-ce que le bourrage de mots-clés en SEO ?

Le bourrage de mots-clés, ou keyword stuffing, désigne l’insertion excessive et non naturelle de termes spécifiques dans une page web. Cette pratique de Black Hat SEO vise à manipuler les algorithmes pour forcer un meilleur positionnement dans les résultats de recherche.

Les moteurs de recherche modernes détectent rapidement cette sur-optimisation qui nuit à l’expérience utilisateur. Un contenu illisible ou répétitif signale une faible qualité et entraîne des pénalités algorithmiques.

Quelles sont les pénalités appliquées par Google pour le keyword stuffing ?

Google sanctionne les sites utilisant le bourrage de mots-clés par une perte significative de visibilité ou une désindexation totale. L’algorithme Google Penguin cible spécifiquement ces pratiques abusives pour nettoyer les résultats de recherche.

Ces sanctions affectent durablement le trafic organique du site concerné. La levée d’une pénalité nécessite un nettoyage approfondi du contenu et l’adoption de pratiques de rédaction conformes aux consignes de qualité.

La densité de mots-clés est-elle encore un critère de pertinence ?

La densité de mots-clés constitue aujourd’hui une métrique obsolète pour le référencement naturel. Les moteurs de recherche ne se basent plus sur le simple comptage des occurrences pour évaluer la pertinence d’une page.

L’optimisation actuelle privilégie la richesse sémantique et la couverture thématique globale. Se concentrer sur un pourcentage précis de répétition s’avère inutile et potentiellement contre-productif face aux algorithmes actuels.

Comment les algorithmes BERT et MUM analysent-ils le contenu ?

Les algorithmes BERT et MUM utilisent le traitement du langage naturel (NLP) pour comprendre le contexte et l’intention de recherche. Ils analysent les relations sémantiques entre les mots plutôt que de chercher des correspondances exactes.

Ces technologies permettent à Google d’identifier les contenus qui répondent précisément aux besoins des utilisateurs. L’intelligence artificielle valorise ainsi l’expertise, la clarté et l’utilité.