Pour résumer

- Dans le monde effervescent du SEO et de l’intelligence artificielle, Google a récemment surpris en évoquant une nouvelle proposition nommée LLMs.txt.

- Présentée comme un équivalent moderne et plus performant du fichier robots.txt, il devait permettre aux éditeurs de contrôler l’accès des modèles de langage (LLMs) vers les contenus principaux d’un site web.

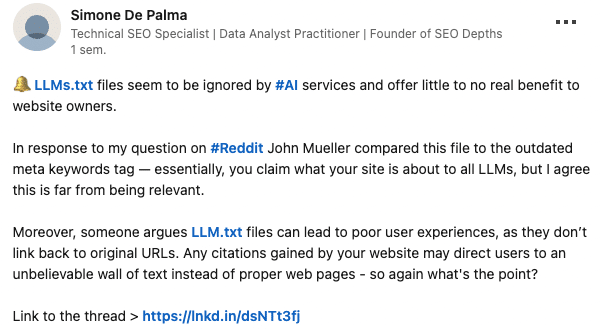

- John Mueller compare LLMs.txt à la balise meta keywords et juge son usage peu pertinent, car les services d’IA risquent de ne pas le consulter.

Qu’est-ce que le fichier LLMs.txt ?

À l’origine, le fichier LLMs.txt était conçu pour offrir aux sites web un outil de régulation spécifique de l’usage de l’intelligence artificielle. Selon Google, cet outil avait pour but de donner aux propriétaires de contenus un meilleur contrôle. Cette initiative rappelle beaucoup le principe de la meta keywords tag apparue dans les années 2000 : une balise créée pour organiser et contrôler le référencement, mais aujourd’hui abandonnée car obsolète.

Plusieurs spécialistes du SEO soulignent cependant que la démarche semblait déjà compromise dès son lancement, faute d’un véritable standard et d’une adoption collective par les autres acteurs majeurs de l’IA tels qu’Anthropic et OpenAI.

Pourquoi Google fait-il reculer cette idée ?

À peine quelques semaines après l’annonce du LLMs.txt, Google a donné des signes clairs de recul, explique l’article de notre confrère. John Mueller, l’un des porte-parole bien connus du moteur de recherche, a déclaré que ce fichier ressemblait davantage à une idée expérimentale qu’à une solution durable. Comme pour la balise meta keywords, l’absence d’un cadre strict et l’inefficacité du système semblent avoir précipité son désintérêt.

Plusieurs raisons ont ainsi été évoquées : l‘absence d’un standard global (sans consensus entre les grands acteurs du numérique, impossible de généraliser l’utilisation du LLMs.txt), la complexité pour les éditeurs (ajouter un fichier supplémentaire peut vite devenir une contrainte technique inutile), mais également le risque d’inefficacité.

Google privilégie d’autres approches pour encadrer l’utilisation des contenus par les IA, comme des paramètres plus sophistiqués dans les fichiers robots.txt existants ou l’intégration directe de consentements dans les protocoles d’indexation actuels.

Quel avenir pour le contrôle des contenus face à l’intelligence artificielle ?

À l’heure actuelle, le besoin de contrôler l’accès aux données par les intelligences artificielles est plus réel que jamais. Mais la solution ne semble pas passer par le LLMs.txt. Google, comme d’autres, explore alors d’autres voies pour répondre à cette problématique essentielle pour les éditeurs.

Reste à voir, dans les prochains mois, quelles innovations ou régulations seront réellement mises en place.