Pour que les pages de votre site web se positionnent dans les pages de résultat des moteurs de recherche, il faut d’abord veiller à ce qu’elles soient correctement indexées. À ce titre, vous pouvez agir sur les bots d’exploration (crawlers) de Google et consorts afin de faciliter le processus.

Parmi les problématiques liées à l’indexation, celle du budget crawl peut être lourde de conséquences en cas de mauvaise gestion.

Rappel : c’est quoi le budget crawl d’un site ?

Afin d’économiser des ressources, le nombre de pages explorées par les crawlers qui passent sur votre site web est restreint par le moteur de recherche qui les utilise. Or, tous les sites disposent de pages plus ou moins stratégiques, voire complètement inutiles.

Si les bots empruntent un mauvais chemin, ils peuvent gaspiller leurs ressources sur des ressources obsolètes de votre site web, entrer dans une boucle de liens et ne même pas atteindre les pages importantes. Ce phénomène peut freiner l’indexation de vos pages sur Google, Bing, etc..

En conséquence, elles ne seront pas visibles sur les moteurs de recherche, et c’est plus de la moitié de votre trafic qui risque de vous échapper, y compris toutes les conversions qui vont avec.

Cette étude de cas de SEO technique illustre comment une intervention ciblée sur un site e-commerce a permis de recentrer le budget crawl sur les pages à forte valeur ajoutée, et recouvrer un ranking rentable dans les SERPs.

Cas étudié : site e-commerce | contexte et problématique de crawl

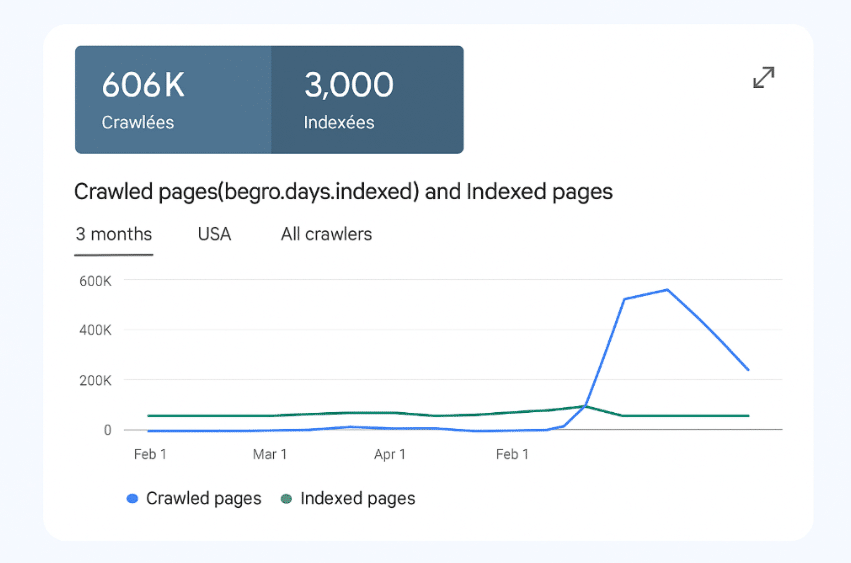

Le client, X-Bar, un site e-commerce d’e-cigarette, accusait une explosion du nombre de pages explorées conjointement à une stagnation anormale des pages indexées.

Cette incohérence était un indicateur clair que Google gaspillait du budget crawl sur des pages inutiles au détriment de l’indexation des pages stratégiques.

Symptômes observés lors du diagnostic sur Google

Une rapide vérification de la Google Search Console nous a confirmé la hausse brutale du nombre de pages explorées, passant de près de 3 000 à plus de 600 000 pages !

Dans le même temps, le nombre de pages indexées ne suivait pas du tout la même évolution, ce qui signifie que le plus gros du budget crawl était employé inutilement. C’est déjà problématique en soi, car les bots d’exploration surchargent votre serveur et ralentissent vos temps de chargement.

Mais le pire est à venir : en rentrant les URLs de certaines pages stratégiques dans la GSC, nous avons constaté l’absence de certaines pages stratégiques dans l’index Google, et notamment des fiches produits à fort potentiel.

Quelle était l’origine du problème de budget crawl ?

Les sites d’e-commerce ont certaines particularités qui rendent leur gestion plus délicate qu’un blog ou qu’un site vitrine. Parmi elles figurent les filtres à facettes. Il s’agit d’un module conçu pour aider les prospects à naviguer à travers un catalogue volumineux.

L’interface propose un ensemble de critères à cocher (catégories, fourchette de prix, etc.) afin que l’utilisateur atteigne plus facilement une réponse pertinente à ses besoins. Ce système ingénieux peut néanmoins provoquer des défaillances techniques, du moins si l’on n’y prend pas garde.

En effet, l’on peut se retrouver avec un nombre de pages potentiel équivalent à la somme de toutes les combinaisons possibles de critères de filtrage, et ainsi multiplier artificiellement le nombre d’URL crawlables, lesquelles ne sont que des déclinaisons du même catalogue dont une partie des produits a été retirée.

Plus il y a de critères et d’articles disponibles, plus le phénomène est problématique, comme dans le cas de X-Bar, somme toute très classique !

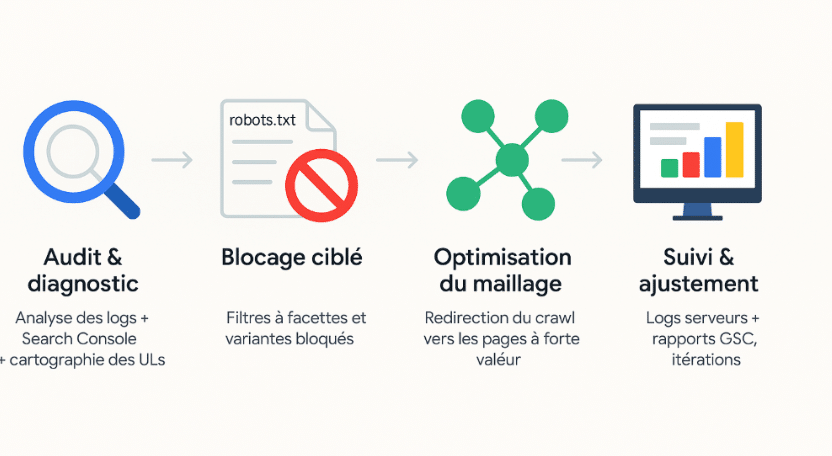

Notre plan d’action pour optimiser le budget crawl d’un site e-commerce

Certains cas d’école comme celui-ci ne requièrent pas de réinventer l’eau chaude. Nous avons donc appliqué une méthode simple et rigoureuse pour venir à bout rapidement de cette hypertrophie non désirée du nombre de pages explorables.

1. Diagnostic et analyse approfondie de la situation

En premier lieu, il nous fallait récolter quelques données supplémentaires pour mieux saisir les enjeux de la situation et préparer des actions sur mesure. Cette phase se décompose en trois étapes :

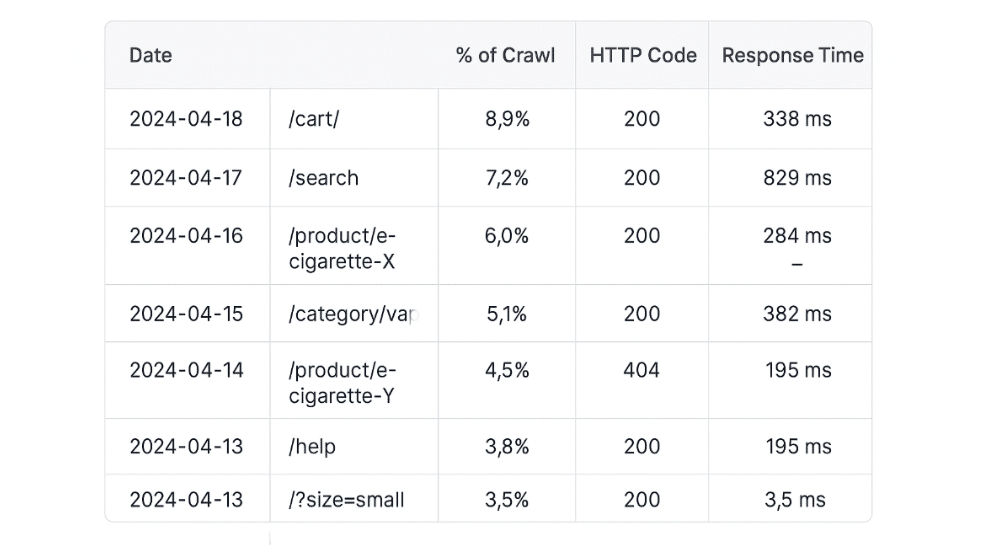

- comprendre la répartition du crawl en lançant une analyse des logs serveurs, notamment afin de relever les pages les plus explorées à chaque passage des bots ;

- comparer les pages explorées avec les pages indexées grâce au rapport dédié de la Search Console ;

- cartographier les URLs afin de trouver et tous les patterns de filtres à facettes inutiles.

À partir de là, nous avions une vision claire de l’architecture du site, avec la position des pages stratégiques d’un côté, et celle de l’ensemble des URLs à écarter des robots explorateurs de l’autre.

Il ne restait plus qu’à mettre en place des outils pour “irriguer” le crawl des moteurs de recherche de façon optimale.

2. Implémentation des solutions sur le site web

Une fois le diagnostic posé, nous avons mis en place des correctifs pour réorienter le budget crawl vers les pages essentielles.

a) Blocage des filtres à facettes dans le fichier robots.txt

Le fichier robots.txt est un document destiné aux crawlers. Il sert à leur donner des directives avant d’entamer une exploration tous azimuts de votre site web. En y insérant quelques lignes de code très simples, on peut orienter le parcours des bots d’exploration afin de :

- réduire le nombre de pages à explorer ;

- éviter les problématiques de duplicate contents à cause de pages trop similaires ;

- mettre en avant les pages que l’on souhaite absolument indexer.

Ainsi, l’ajout de directives dans le fichier robots.txt a permis de stopper l’exploration de milliers de pages inutiles :

User-agent: *

Disallow: /*?filter=

Disallow: /*&sort=

La ligne “User-agent” sert à désigner le destinataire du fichier. Le “*” signifie que les crawlers de tous les moteurs de recherche sont concernés.

La deuxième ligne bloque l’exploration des pages dont l’URL contient les termes “?filter=” générées par le filtre à facettes, par conséquent sans valeur SEO.

La troisième ligne empêche les crawlers d’accéder aux pages proposant une variante de chaque produit (taille, couleur, etc.), reconnaissables par la mention “&sort=” dans les URLs.

Nota Bene : la plupart du temps, ce sont ce type de pages qui génèrent du duplicate content et désorientent encore davantage les robots indexeurs.

b) Utilisation des balises « noindex, follow » pour mieux maîtriser le crawl

Après un audit approfondi de l’architecture du site, nous avons identifié d’autres pages non stratégiques. Bien que leur exploration par les robots soit avérée, leur impact sur le budget de crawl restait limité. Dans ces cas isolés, où la suppression pure et simple du crawl n’était pas justifiée, nous avons opté pour une approche plus ciblée : l’implémentation d’une balise « noindex » directement sur chaque page concernée.

Cette solution présente un double avantage. D’une part, elle empêche ces pages d’être indexées par les moteurs de recherche, évitant ainsi qu’elles ne diluent la pertinence globale du site. D’autre part, contrairement à un blocage via robots.txt, elle ne restreint pas l’exploration des robots. Ainsi, le PageRank continue de circuler normalement à travers les liens internes, préservant la transmission de valeur SEO vers les pages stratégiques du site.

Cette approche garantit une gestion fine et équilibrée de l’indexation, sans impacter négativement le maillage interne ni la distribution de l’autorité des pages.

c) Amélioration du maillage interne du site web

Le maillage interne désigne le réseau de liens hypertextes qui relie l’ensemble des pages de votre site web. Il permet de :

- pré-dessiner des parcours de navigation droit vers la conversion ;

- organiser l’arborescence de votre site web afin de faciliter l’orientation des utilisateurs ;

- faciliter l’exploration des crawlers, lesquels utilisent les hyperliens pour passer d’une page à une autre et ainsi faire circuler le PageRank.

C’est pour satisfaire ce dernier point que nous avons repensé le maillage interne. Les parcours tracés par les nouveaux liens avaient vocation à orienter Google vers les pages stratégiques, de sorte à prioriser leur indexation.

d) Suivi et ajustements grâce à la Google Search Console

Bien entendu, pour chaque projet, on surveille et on itère avec les leviers cités précédemment. Nous avons donc instauré un suivi hebdomadaire via l’analyse des logs serveurs et des rapports de la Google Search Console. Nos points de contrôles étaient les suivants :

- réduction du crawl sur les pages non stratégiques ;

- meilleure répartition des ressources vers les contenus à forte valeur ajoutée ;

- amélioration de l’indexation des pages essentielles.

De cette manière, nous pouvions rapidement engager des actions complémentaires dans le cas où certaines pages continueraient d’accaparer une part excessive du budget de crawl malgré les optimisations.

Quels résultats avons-nous obtenus après optimisation du budget crawl ?

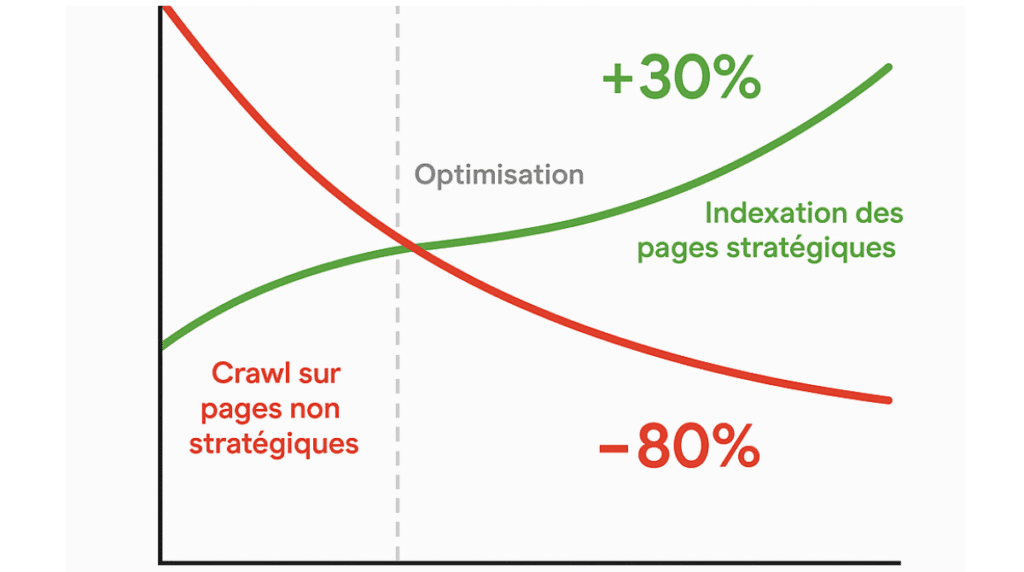

Comme espéré, nos mesures de suivi ont été porteuses de bonnes nouvelles. En premier lieu, nous avons observé une baisse considérable du crawl sur les pages non stratégiques, avec une réduction de 80% du volume d’exploration de pages inutiles. Le site n’est plus saturé, et le budget crawl est redistribué sur des pages stratégiques.

En conséquence, nous avons enregistré une augmentation de 30% de l’indexation des pages importantes. Le positionnement SEO sur des requêtes cibles a donc naturellement suivi, notamment en ce qui concerne les guides produits.

Enseignements et bonnes pratiques sur le budget crawl

Il convient de retenir quelques éléments-clés de ce cas d’école, afin de savoir où chercher et d’augmenter votre réactivité en cas de situation aux symptômes similaires.

Quand se poser la question du budget crawl pour votre propre site web ?

Vos pages stratégiques ne rankent pas, voire, elles ne figurent pas dans l’index Google, voire n’ont pas été explorées depuis longtemps ? Signal d’alerte !

Le moteur de recherche indique crawler cinquante fois plus de pages que votre site n’en comporte réellement ? Des vérifications s’imposent.

Votre site subit des ralentissements inexplicables ? Un bon réflexe sera de vérifier le passage des robots, puisque les pics d’exploration impactent les performances.

Doit-on traiter le budget crawl de la même façon sur un site média que sur un site e-commerce ?

La gestion du budget crawl doit être adaptée à la nature du site concerné. Pour les sites e-commerce, on l’a vu, le risque principal provient des filtres à facettes et des pages doublons liées à la déclinaison d’une même fiche produit. Dans ce cas, il convient de :

- bloquer les pages inutiles via robots.txt (ex. Disallow: /*?filter=) et canonical sur les pages variantes ;

- optimiser le maillage interne pour diriger le crawl vers les catégories et produits stratégiques ;

- gérer les produits en rupture de stock intelligemment (redirections 301, noindex ou optimisation du contenu).

Concernant les sites médias, le besoin principal est de faire indexer les nouveaux contenus le plus rapidement possible. Dans ce cas, la gestion du budget crawl passera essentiellement par ce cahier des charges :

- la mise en place d’un sitemap dynamique pour notifier les nouvelles publications en temps réel ;

- bâtir un maillage interne dynamique pour contrôler la profondeur des pages et pousser les articles récents dans les sections les plus visibles ;

- assurer la gestion des pages obsolètes, afin d’éviter que Google perde du temps sur des vieux articles sans valeur SEO.

| Enjeu / Problématique | Site e-commerce | Site média |

| Pages inutiles à crawler | Bloquer les facettes non SEO via robots.txt, noindex et balises canonical | Supprimer ou désindexer les articles obsolètes sans valeur ajoutée |

| Profondeur de page | Optimiser le maillage interne vers les catégories et produits stratégiques | Créer un maillage dynamique mettant en avant les articles récents |

| Mise à jour du contenu | Gérer les fiches produits en rupture : redirection, noindex ou enrichissement | Maintenir à jour les contenus chauds, surtout ceux à fort potentiel d’actualisation |

| Découverte des nouvelles pages | Soumission régulière du sitemap XML produits et catégories | Sitemap dynamique ou ping automatique à chaque nouvelle publication |

| Gestion des doublons | Centraliser le crawl sur les versions canoniques des produits | Moins critique, sauf en cas de syndication ou republis sans canonical |

| Pages stratégiques à prioriser | Pages produit à fort potentiel commercial | Articles récents ou d’actualité forte |

| Fréquence de mise à jour souhaitée | Variable selon le catalogue et les promos | Très élevée pour les contenus récents ou viraux |

Notre règle d’or

Vous possédez un site relativement volumineux, contenant un ou plusieurs milliers de pages ? Nous vous recommandons d’office une vérification régulière des tendances d’explorations via la Google Search Console et une analyse des logs.

Bilan de l’étude de cas d’optimisation du budget crawl

Le budget crawl est une notion SEO qui peut sembler obscure au premier abord. Retenez simplement qu’il s’agit des ressources allouées par les moteurs de recherches à leurs robots explorateurs pour crawler les pages d’un site web. Si ces ressources sont gaspillées ou mal réparties, votre site peut ralentir et voir ses pages stratégiques disparaître des SERPs.

Malgré l’ampleur de ces enjeux, l’exemple d’X-Bar démontre que quelques manipulations fines peuvent suffire à redresser la barre, suite à un audit détaillé des pages explorées, des pages indexées, et de l’architecture de votre site web : cette fois-ci, le travail d’optimisation devait tenir compte des particularités des e-boutiques.

Et vous ? Avez-vous déjà consulté votre budget crawl ? Savez-vous comment vous y prendre ? Nos équipes de SEO technique restent ouvertes à toutes vos interrogations !