Mis à jour le 27/07/2024

Le budget crawl (ou budget d’exploration) représente le temps passé par un crawler sur un site web et le nombre de pages qu’il y explore chaque fois qu’il se rend dessus. Les crawlers, comme Googlebot ou Bingbot, sont utilisés par les moteurs de recherche pour parcourir des domaines et analyser leur contenu avant indexation.

Leur rôle est donc de sillonner le web sans arrêt en passant d’un lien à un autre, à vérifier l’apparition de nouveaux contenus et les mises à jour de publications plus anciennes. Le budget crawl sert à mieux répartir la présence des bots sur les sites. Cela permet à la fois de ne pas saturer les serveurs par leur simple présence, mais également de ne pas s’attarder sur certains domaines au détriment d’autres, peut-être plus qualitatifs.

À ce titre, le budget crawl est loin d’être égal pour tous les sites web. Il existe un certain nombre de variables que nous évoquerons plus avant.

La “Crawl rate limit”, c’est quoi ?

Il s’agit de la vitesse d’exploration des bots, qui représente le nombre de requêtes envoyées au serveur chaque seconde. Un site performant va pouvoir recevoir une forte intensité de crawling et donc laisser sprinter les Googlebots (ou Bingbots, etc.) sans que sa bande passante ne s’en trouve saturée, ce qui augmenterait le temps de chargement pour les internautes et dégraderait ainsi leur expérience de navigation.

A contrario, un site assez lent va avoir du mal à répondre à toutes les requêtes des bots, ce qui ralentira même le travail des crawlers. Aussi les algorithmes sont-ils conçus pour adapter leur vitesse d’exploration afin de maximiser le nombre de pages visitées à la seconde sans mettre le serveur en difficulté.

Néanmoins, il peut arriver que leur ajustement ne soit pas suffisant pour soulager le site web crawlé. Dans ce cas, le webmaster peut fixer une limite maximale de vitesse d’exploration, via la Google Search Console. Il ne peut, en revanche, inciter les algorithmes à passer plus vite sur son site web. De même, le bot peut décider de ne pas atteindre la vitesse limite fixée par le webmaster.

Quels facteurs affectent le budget de crawl ?

Le budget de crawl de votre site dépend de multiples variables, à commencer par ses performances, la quantité et la qualité de son contenu, mais aussi tout bonnement sa popularité (trafic, backlinks, etc.). Pour ne pas vous faire surprendre, voici quelques points clés à surveiller de près.

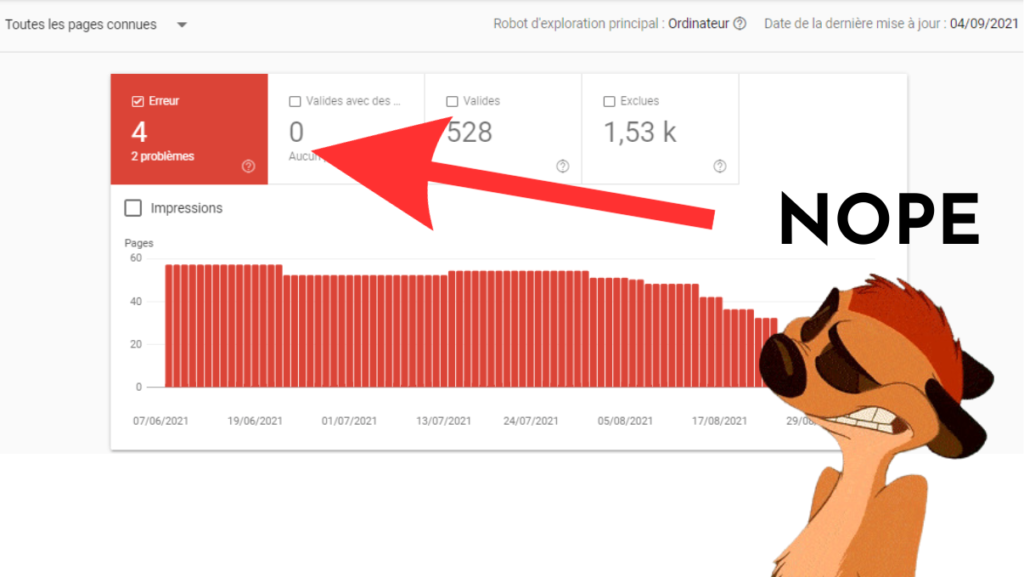

Les liens brisés et autres pages d’erreur

Les liens brisés (erreur 404) et toute autre page inutile comme du contenu obsolète, consomment un budget crawl inutile. Plus votre site est de grande taille, plus vous avez de chance d’accumuler ce type de pages, considérées par les experts SEO comme une véritable réserve de budget crawl. Pour l’exploiter, il s’agira de supprimer le plus de pages possibles, ou bien de faire en sorte qu’elles ne soient pas visitées par les bots.

Quoi qu’il en soit, pour les trouver, vous pouvez vous servir de la Search Console ou d’outils SEO plus avancés comme Oncrawl, ou Majestic SEO.

Les crawlers traps

Les pièges à crawlers sont, en quelque sorte, la version amplifiée du problème précédent. C’est quand toute une partie de votre site web se transforme en labyrinthe pour le Googlebot, à cause d’un nombre conséquent d’URLs sans pertinence pour votre SEO, situés à une profondeur absurde et/ou générant des boucles de redirections qui l’empêchent de se diriger vers vos pages stratégiques.

Cela peut arriver pour des raisons très diverses, comme un nombre important de chargements de scripts JavaScript, ou un paramétrage des URLs défaillant.

Les problématiques de contenu

On l’a dit, les bots réagissent à votre contenu. Ils sont sensibles à des signaux très simples et faciles à modifier. D’abord, la fréquence de publication et de mise à jour est déterminante. En effet, mettons que les algorithmes passent 3 fois par semaine sur votre site internet, et qu’ils n’y détectent aucun changement.

Dans ce cas de figure, ils risquent fort de passer de moins en moins souvent. À l’inverse, si vous modifiez plus souvent votre contenu, la fréquence des visites peut augmenter petit à petit.

D’autre part, le contenu dupliqué interne ou simplement de mauvaise qualité va influencer négativement le travail des bots. En effet, votre budget crawl va se voir dilapidé sur des pages non stratégiques, en passant deux fois sur les mêmes contenus, ou bien en envoyant à l’index des informations désavantageuses pour votre site web.

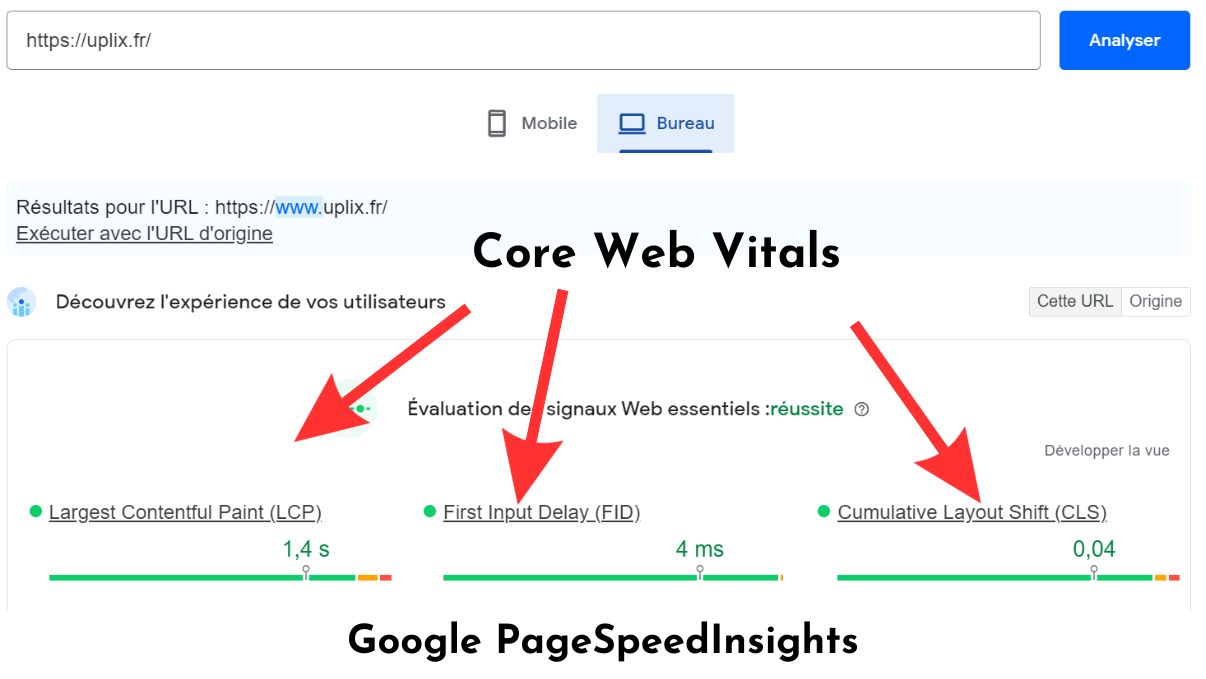

Les défaillances techniques de votre site web

Concernant la partie technique de votre domaine, il faudra bien surveiller les temps de chargement de votre site web, quitte à changer d’hébergeur ou à utiliser un CDN. Pour tester et voir si vous avez besoin de réduire le temps de chargement de vos pages, utilisez Google Pagespeed. Encore une fois, si vous vous sentez perdus, une agence SEO pourra vous aiguiller sur la marche à suivre.

Enfin, il est primordial d’avoir un site web totalement responsive, voire mobile-first (conçu pour appareil mobile avant d’être adapté aux formats desktop). En effet, tout un escadron de crawlers est exclusivement dédié à la navigation mobile, et c’est en soi un très mauvais signal SEO que de n’avoir pas une version de site adaptée, plus grave encore que la question du budget crawl.

Quelles pratiques SEO pour un budget crawl optimal ?

Vous souhaitez entamer un chantier spécial “budget crawl” ? Outre le fait d’améliorer continuellement la qualité intrinsèque de votre site web, on vous énonce toutes les étapes nécessaires pour que celui-ci soit exploré dans les meilleures conditions possibles et indexé de sorte à apparaître le plus haut possible dans les SERPs !

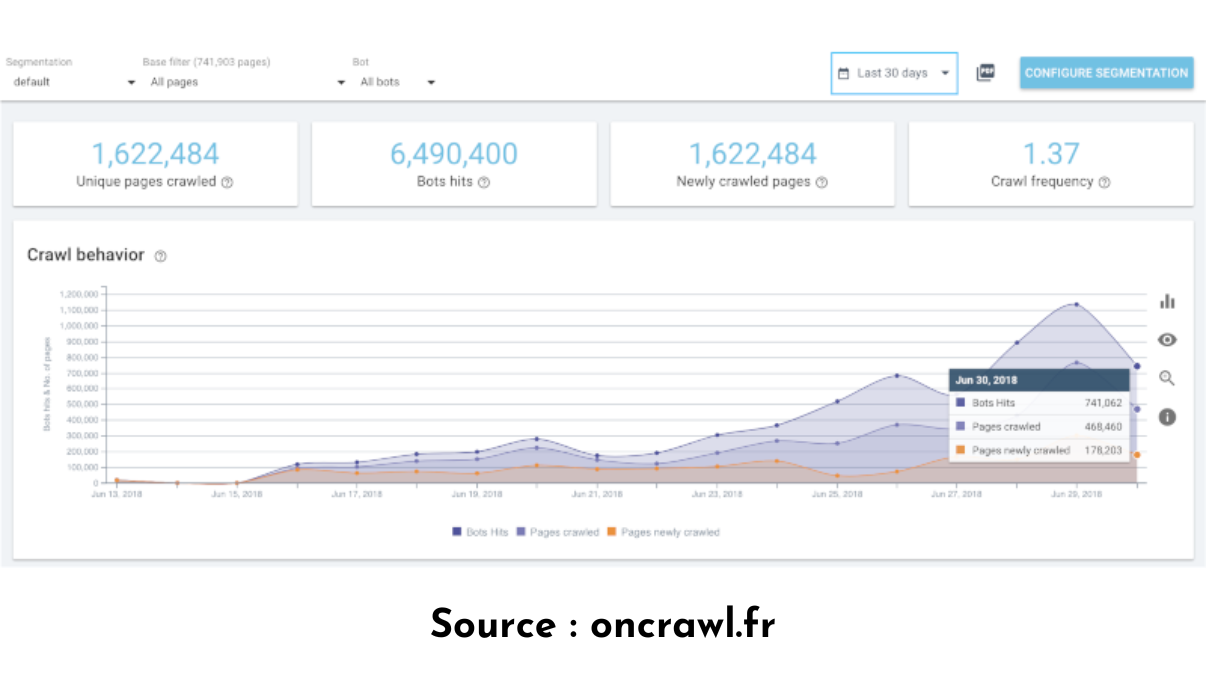

Trouver les pages qui vous font perdre du budget crawl

Pour vous pouvez commencer par consulter la Search Console, afin de comparer le nombre de pages visitées avec celles qui ont été indexées. Si vous constatez un écart important, c’est qu’il y a probablement du gaspillage de budget crawl dans l’air.

Pour vous en assurer et détecter les pages ou les zones du site qui posent problème, nous vous recommandons de contacter une agence SEO afin de procéder à une analyse de logs, une opération qui requiert des compétences techniques assez poussées.

Vous saurez alors exactement :

- le taux de crawl sur l’ensemble des pages de votre domaines ;

- quelles pages n’ont pas croisé de Googlebot depuis un moment ;

- quelles pages sont explorées régulièrement sans pertinence pour votre SEO.

La bonne nouvelle, c’est que les experts SEO sauront vous accompagner sur les manipulations à réaliser par la suite.

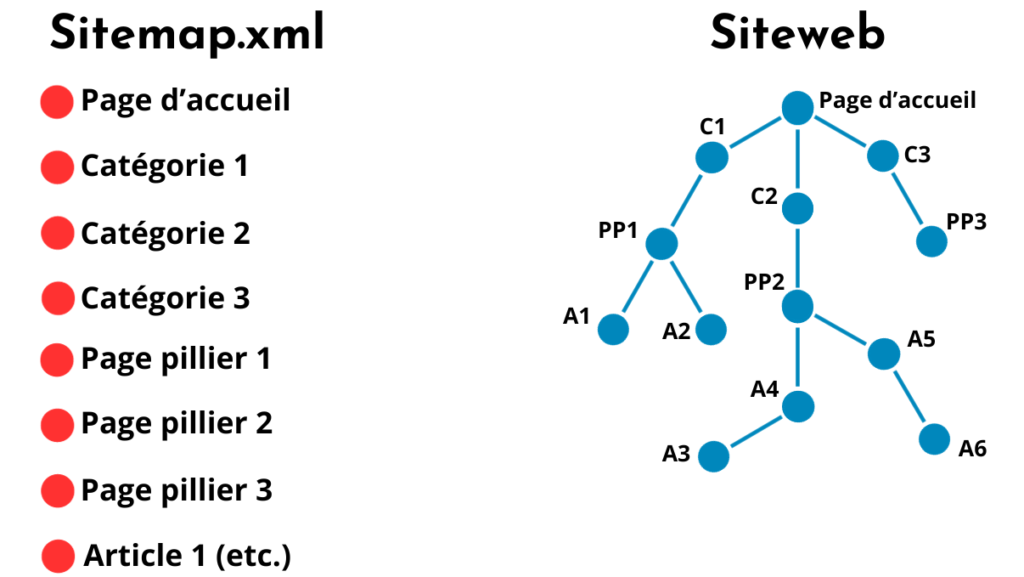

Diriger les algorithmes vers vos pages les plus importantes

Les algorithmes sont un peu comme des internautes numériques : ils ont besoin d’être guidés pour trouver les ressources essentielles de votre site web. Cela commence avec une arborescence de site cohérente et équilibrée en termes de profondeur de page. Avec une bonne répartition des silos et une hiérarchisation logique des pages mères et filles, vous pouvez arriver à un résultat satisfaisant. D’autre part, un maillage interne bien ficelé guidera les bots sur les pages les plus stratégiques.

Si vous vous rendez compte que l’architecture de votre site est trop erratique, envisagez une refonte et retravailler la structure à partir d’un logiciel de mind map. Si vous n’avez que quelques modifications à effectuer, mettez bien à jour votre sitemap.xml, lequel aidera les bots à se repérer en amont de leur exploration.

Enfin, vous pouvez détourner les bots des pages inutiles avec un fichier robots.txt. Les fichiers robots.txt sont très pratiques : ils permettent d’indiquer aux bots les impasses de votre site web et de leur livrer des indications de crawl et d’indexation, afin de bloquer l’accès aux URLs non pertinentes.

Effectuer des demandes de crawl

Tous les sites internet ne bénéficient pas du même budget crawl. Si le vôtre reçoit assez peu les visites du Googlebot mais qu’il a récemment subi des modifications majeures, comme une refonte ou un ajout de pages assez important, il est recommandé de procéder à une demande d’exploration.

De cette manière, vous n’aurez pas forcément à attendre plusieurs jours (voire plusieurs semaines) pour que la version à jour de votre domaine soit indexée et donc disponible dans les SERPs.

Renseignez-vous au préalable sur la fréquence d’exploration de vos pages grâce à la Search Console. Si les crawls sont trop peu fréquents, lancez une demande manuellement :

- soit en envoyant directement les URLs à explorer ;

- soit en soumettant le sitemap.xml mis à jour, si les modifications sont trop nombreuses.

Quelle que soit la solution choisie, vous pouvez effectuer vos manipulations à partir de la Search Console, du moins en ce qui concerne le moteur de recherche Google.

Pour finir…

Le budget crawl est une notion SEO relativement avancée, qui demande de connaître quelques mécanismes des moteurs de recherche pour en saisir le fonctionnement. Certains webmasters ne s’en préoccupent pas du tout, et finissent par se faire surprendre.

Leurs pages stratégiques optimisées aux petits oignons ne rankent jamais, simplement parce qu’elles ne sont pas explorées, le budget crawl étant dilapidé autrement.

C’est pourquoi il est essentiel de vous soucier régulièrement de la bonne indexation de vos pages, en commençant par vérifier comment votre budget crawl est utilisé. Si vous remarquez des problèmes, les conseils ci-dessus et le recours à une agence SEO pourront vous être utiles.