Comment l’oubli sélectif peut aider l’IA à mieux apprendre ?

- Des scientifiques ont créé un modèle d’apprentissage machine plus flexible grâce à l’oubli sélectif.

- Cette technique pourrait améliorer la compréhension des langues par les IA et réduire la puissance de calcul nécessaire.

- L’approche s’inspire du fonctionnement de la mémoire humaine et pourrait aider à adapter les IA à de multiples langues, y compris les moins représentées.

Comment l’oubli sélectif peut-il révolutionner l’apprentissage des IA ?

Une équipe de scientifiques en informatique a mis au point un modèle d’intelligence artificielle (IA) plus agile et flexible. Leur astuce réside dans la capacité de l’IA à oublier périodiquement certaines informations.

Cette nouvelle méthode, bien qu’elle ne remplace pas les modèles massifs qui soutiennent les principales applications, pourrait offrir un nouvel éclairage sur la manière dont ces programmes traitent le langage.

Selon Jea Kwon, ingénieur en IA, cette recherche marque « une avancée significative dans le domaine ».

Les moteurs de langage IA actuels fonctionnent principalement grâce à des réseaux neuronaux artificiels, où chaque neurone effectue des calculs et transmet des signaux à travers de multiples couches.

Initialement aléatoire, le flux d’informations s’améliore avec l’entraînement, mais ce processus exige beaucoup de puissance de calcul et n’est pas facilement adaptable.

Mikel Artetxe, coauteur de cette recherche et fondateur de la startup Reka, et ses collègues ont cherché à contourner ces limitations.

Ils ont entraîné un réseau neuronal dans une langue, puis effacé ce qu’il savait sur les blocs de construction des mots, avant de le réentraîner dans une autre langue. Malgré des informations incohérentes, le modèle a pu apprendre et traiter la nouvelle langue.

Quelles sont les avantages de l’oubli sélectif pour les IA ?

Le processus d’oubli sélectif s’est avéré efficace pour ajouter une nouvelle langue à un modèle déjà formé, bien que le réentraînement reste exigeant.

Yihong Chen, auteur principal de l’étude, suggère une modification : réinitialiser périodiquement la couche d’encodage pendant l’entraînement initial. Ainsi, le modèle s’habitue à cette réinitialisation, facilitant l’extension à d’autres langues.

L’équipe a utilisé un modèle de langue appelé Roberta, entraîné avec leur technique d’oubli périodique, et a constaté une meilleure performance lors de l’ajout de nouvelles langues avec des ensembles de données plus petits.

Cette méthode semble rendre le modèle plus apte à apprendre les langues en général, car il s’habitue à oublier et réapprendre pendant l’entraînement.

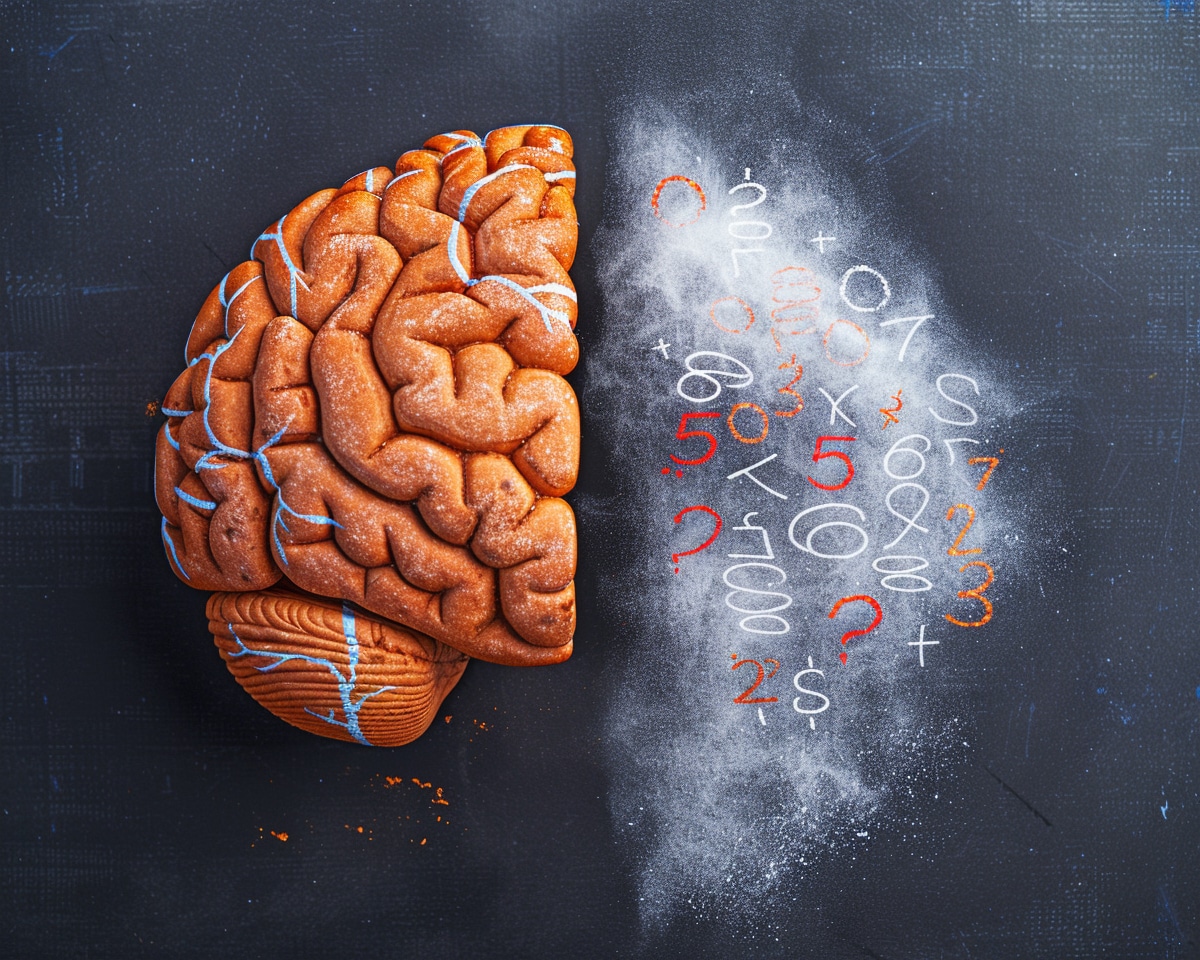

Quelle est la similitude entre l’oubli sélectif des IA et la mémoire humaine ?

La démarche est similaire au fonctionnement de notre propre cerveau. Benjamin Levy, neuroscientifique, explique que la mémoire humaine a tendance à se souvenir de l’essentiel des expériences, en abstrayant et extrapolant.

Appliquer des processus plus humains, comme l’oubli adaptatif, à l’IA pourrait mener à des performances plus flexibles.

L’oubli sélectif pourrait également aider à intégrer les dernières avancées de l’IA dans davantage de langues, particulièrement celles qui disposent de moins de matériel d’entraînement, comme le basque, langue natale d’Artetxe.

Chen envisage un monde où de nombreux modèles de langage IA pourraient rapidement s’adapter à de nouveaux domaines.

L’avenir des modèles de langage IA

L’oubli sélectif pourrait permettre de créer des modèles de langage IA capables de s’adapter rapidement à diverses langues et domaines, réduisant ainsi la dépendance envers des modèles massifs et peu flexibles.

Cette avancée représente un pas de plus vers des IA polyvalentes et économiques en ressources, qui pourraient bénéficier à des langues moins représentées et à des applications plus spécifiques.

Pour plus de détails sur cette recherche innovante, vous pouvez consulter l’article original, avec l’aimable autorisation de Quanta Magazine.