Google Smith : qu’est-ce que c’est ?

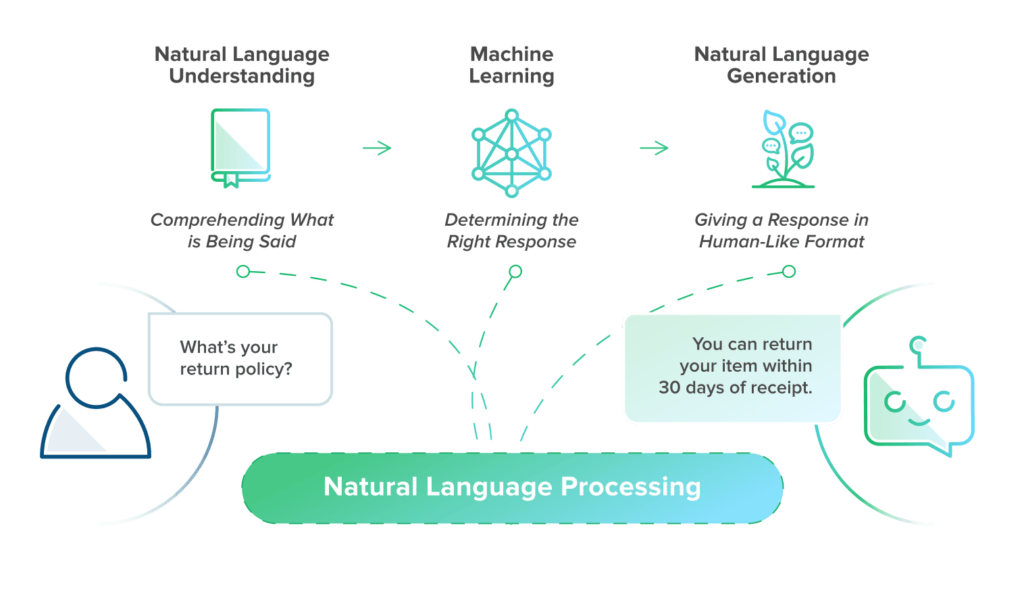

En novembre 2020, Google annonçait le développement de l’algorithme SMITH (Siamese Multi-depth Transformer-based Hierarchical encoder) ; un événement à souligner dans la course des NLP (Natural Language Processing) ou Traitement Automatique du Langage Naturel (TALN).

En effet, les nouveautés affluent dans le domaine des IA dédiées à la communication en langage humain. Récemment, les logiciels intégraient encore des fonctionnalités linguistiques relativement rigides pour l’utilisateur.

Aujourd’hui, des modèles fleurissent qui imitent davantage le cerveau humain en matière de compréhension et de génération textuelle, à l’image du T-NLG de Microsoft ou GPT-3 de la société californienne OpenAI.

Ces algorithmes sont conçus pour résumer des contenus ou répondre à des questions avec la fluidité d’une conversation.

Ces modèles fonctionnent avec respectivement 17 milliards et 175 milliards de paramètres.

Une telle capacité d’analyse permet même d’aboutir à la rédaction automatique d’articles cohérents. Dans cette perspective, voyons ce qu’il en est du côté de Google…

Une nouvelle avancée dans les NLP avec Google Smith

Concrètement, les outils qu’emploie Google traitent à une vitesse vertigineuse des dizaines de milliards de données. Pour l’indexation des pages web, les réponses aux requêtes et leur classement dans les SERP, la puissance de calcul est un allié précieux, mais insuffisant.

L’analyse du langage naturel humain nécessite des algorithmes plus subtils, issus des recherches en Machine Learning et Deep Learning.

L’idéal de l’intelligence artificielle est d’ailleurs de trouver un moyen de traiter des situations inédites ; ainsi, les comprendre en profondeur est la première étape pour satisfaire les utilisateurs.

L’objectif est alors de proposer un résultat qui s’appuie sur des expériences passées pour puiser dans de nouvelles ressources.

Nota Bene : on utilise de plus en plus le machine learning pour diverses tâches subtiles, comme le Predictive Ranking en SEO. Le potentiel de cette technologie en est encore à ses balbutiements…

L’algorithme Google SMITH : en quoi ça consiste ?

Après que l’équipe de recherche de Google s’est penchée activement sur les NLP, elle a d’abord développé et déployé en 2019 un algorithme sophistiqué qu’elle a baptisé BERT (Bidirectional Encoder Representations from Transformers).

BERT est un modèle préentraîné qui accomplit diverses tâches comme cité préalablement : réponses aux questions, association sémantique, structuration, etc.

Toutefois, son défaut majeur réside dans une analyse sémantique qui se restreint à quelques phrases…

Environ un an plus tard, c’est au tour du Siamese Multi-depth Transformer-based Hierarchical encoder (SMITH) de faire l’objet d’un article de présentation.

Ce modèle serait capable de manipuler le sens de contenus plus longs, en s’aidant du contexte dans lequel les mots sont employés, à l’image de BERT.

En effet, si celui-ci est en mesure de prédire des mots cachés dans une phrase, SMITH parvient à prédire des blocs de phrases entiers !

Traiter des requêtes toujours plus complexes

Avec des avancées comme SMITH, Google espère renforcer sa pertinence pour des requêtes de plus en plus délicates. En effet, pas moins de 15% de ses demandes sont inédites.

La problématique est donc : comment trouver la meilleure réponse sans dépendre de statistiques sur la réputation, le taux de rebond ou de conversion d’une page pour tel mot-clé ? Google va donc chercher la pertinence directement dans la question…

En outre, les réponses proposées par le moteur de recherche doivent correspondre à une exigence de rapidité et de précision. Mieux que de présenter la bonne page, l’algorithme doit en extraire l’information requise et la formuler intelligiblement (pour les assistants vocaux par exemple).

Enfin, les requêtes évoluent pour être de plus en plus longues ; le NLP incite les utilisateurs à communiquer avec la machine comme avec un interlocuteur humain. Ainsi, 8% des requêtes sont des questions complètes.

Des mots-clés aux phrases, des phrases aux paragraphes, etc.

Avec BERT, les performances pour mettre en correspondance un texte d’entrée court (un mot-clé de longue traîne ou une question) avec un document court ou long (pour une étude ad hoc, par exemple) se sont grandement améliorées.

Or, SMITH s’inscrit directement dans ce besoin d’associer, notamment grâce au contexte, le sens général d’un bloc de mots ou de phrases à une information manquante que l’on va prédire ou chercher.

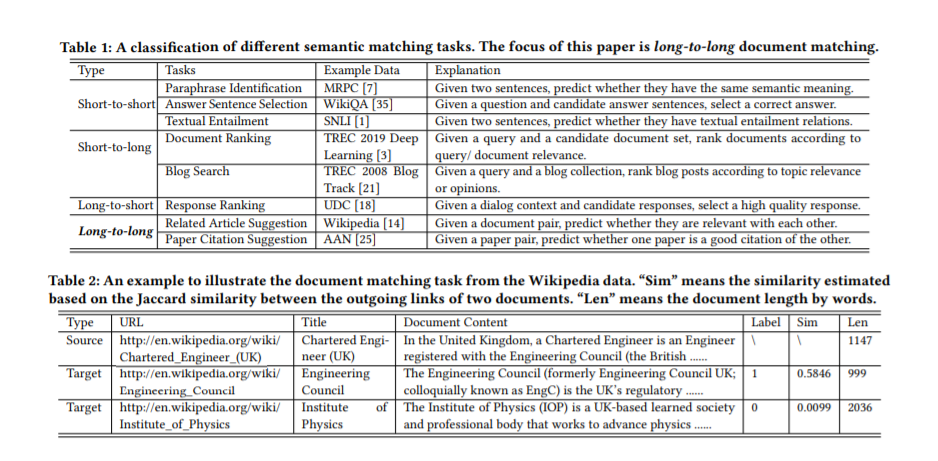

Ce modèle trouve son intérêt dans la mise en correspondance sémantique entre deux contenus relativement longs. Cette nouvelle aptitude servirait aux recommandations d’actualités ou d’articles connexes, et à un classement plus précis des documents. Ainsi, selon les chercheurs la difficulté de cette tâche réside dans :

- une compréhension plus profonde des relations sémantiques entre les termes ;

- la prise en compte de la structuration du contenu, duquel un sens général est déjà censé se dégager ;

- des problèmes techniques inhérents à l’algorithme.

Transformers et mécanisme d’attention

À l’instar de BERT, SMITH innove dans les modèles d’attention. Ce type de mécanisme permet de hiérarchiser les termes d’une phrase par analyse sémantique et syntaxique, en fonction du contexte.

En effet, la machine déduit automatiquement le poids contextuel de chaque mot, sans en éliminer.

Nous pourrions l’illustrer ainsi : “Le renard roux agile saute par-dessus le chien marron”. Ensuite, un transformer crée des embeddings : il trouve la probabilité du prochain mot après chaque terme analysé.

En effet, il est plus probable de lire l’adjectif “roux” derrière le nom “renard” que d’y trouver le mot “cafetière”. Bien sûr, vu la quantité de mots existants, la tâche est extrêmement ardue !

D’autre part, comme la lecture bidirectionnelle de BERT (de gauche à droite et vice versa), l’intérêt des tranformers pour SMITH est de traiter les mots du texte dans un ordre indépendant de sa linéarité initiale (un peu comme on décoderait du latin….)

L’importance de la Préformation

Grâce aux mécanismes d’attention et aux transformers, les modèles BERT et SMITH accèdent à une méthode dite de “pré-formation”. En résumé, il s’agit de former un algorithme à partir d’un ensemble de données. L’exercice typique de ce paramétrage consiste à masquer des mots aléatoirement dans une phrase.

Ainsi, pour faire simple, dans “Le … roux agile saute par-dessus le chien marron”, la machine saura prédire le mot manquant “renard”.

Mais l’apprentissage de SMITH va plus loin,qui doit lui faire saisir des relations sémantiques entre les termes d’un texte bien plus long, afin de prédire des blocs de phrases entiers !

Ainsi, grâce à un tel “entraînement” ce modèle serait en mesure de traiter des documents de plus en plus volumineux.

Google Smith : pour travailler de conserve avec BERT

En principe, l’efficacité de SMITH ne devrait pas se substituer au succès encore récent de BERT en matière de Deep Learning.

Comme évoqué un peu plus tôt, le Bidirectional Encoder Representations from Transformers avait déjà marqué un progrès notable dans la compréhension du langage naturel par la machine.

Capable de parcourir un texte dans les deux sens, ce modèle embarquait déjà un transformer capable de lui indiquer les relations contextuelles entre tous les mots qui composent chaque phrase.

Un encodeur se chargeait de saisir le sens d’un texte d’entrée, pour ensuite générer un décodeur spécifique à l’accomplissement de la tâche requise.

Les impacts sur le moteur de recherche de Google

Écrites ou orales, les requêtes, avec BERT, ont rapidement donné lieu à des réponses de plus en plus pertinentes. En effet, l’algorithme est conçu pour n’éliminer aucun mot, afin d’améliorer la précision de ses interprétations.

En conséquence, les utilisateurs peuvent compter sur des natures de mots telles que les prépositions, afin d’expliciter les rapports de sens qu’il souhaite établir entre les autres mots plus importants.

À certains égards, cela évite à BERT de commettre des contresens. À ce titre, prenons l’exemple le plus connu de Google : “2019 Brazil traveler to usa needs a visa”.

En tenant compte de la préposition “to”, la SERP affiche des résultats destinés à un voyageur brésilien qui se rend aux États-Unis.

Sans BERT, le moteur de recherche aurait ignoré le “to” pour donner en priorité des réponses adressées à un voyageur américain qui se déplace au Brésil.

SMITH complète BERT pour les documents longs

Ainsi, depuis novembre 2020, l’on sait que SMITH risque bientôt de prêter main-forte à BERT, grâce à son aisance d’analyse sur des volumes de contenus plus conséquents.

Capable de comprendre le sens général d’un document en décomposant les axes sémantiques de ses parties, il devrait permettre de répondre à des requêtes plus longues, inédites et spontanées.

À ce titre, la longueur maximale du texte d’entrée aurait quadruplé, passant de 512 à 2048 mots, comparativement à BERT.

Déploiement de Google Smith : ce que ça change(rait) en SEO

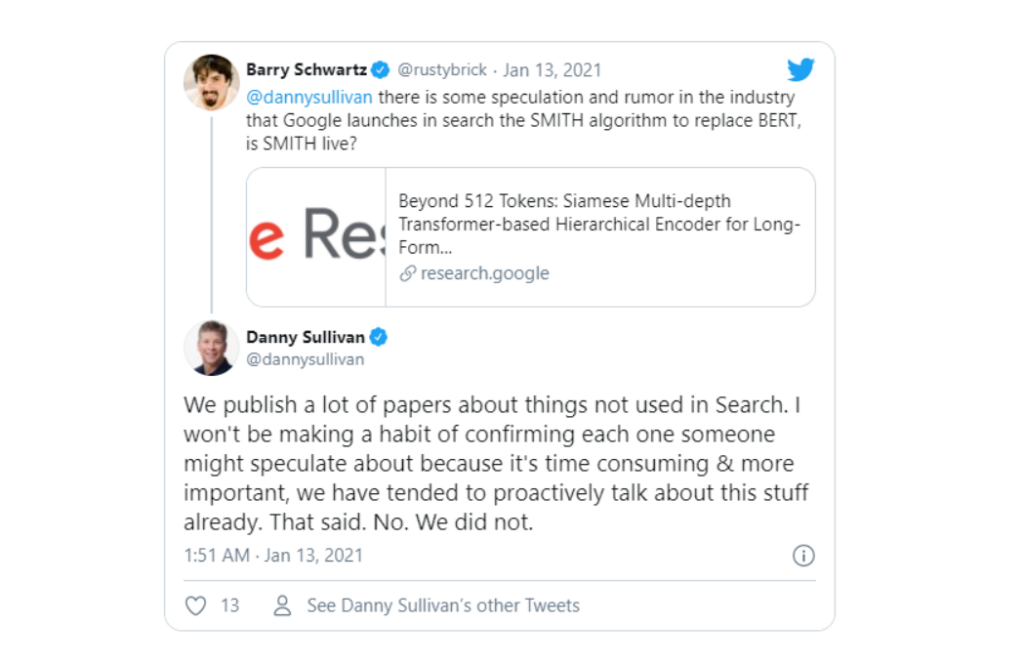

Actuellement, l’heure est aux spéculations pour savoir si SMITH est déjà implémenté parmi les algorithmes de Google. À titre de comparaison, un délai de près d’un an avait séparé le développement de BERT de son déploiement officiel.

Malgré une annonce selon laquelle Google avait procédé à des mises à jour fin 2020, Danny Sullivan a déclaré sur Twitter le 13 janvier 2021 que cela ne concernait absolument pas SMITH.

En outre, il semblerait que nous ne parlions encore que d’une version bêta du modèle à venir. Cela étant, la trame évolutive de Google semble claire.

Nul besoin, donc, d’attendre la prochaine Core Algorithm Update pour adopter (ou renforcer) les bonnes pratiques.

Exemple de BERT

Pour revenir un peu sur le prédécesseur de SMITH, rappelons-nous que Google l’avait présenté comme la plus importante mise à jour depuis cinq ans, c’est-à-dire depuis Hummingbird.

Dans son blog, Google estime à 10% le taux de résultats de recherches affectés par BERT. Déjà, l’on trouvait confirmation sur deux éléments à garder impérativement à l’esprit :

- anticiper les intentions des utilisateurs lorsque l’on rédige sur un sujet, et répondre aux éventuelles questions ;

- améliorer le réseau sémantique, en fournissant du contenu complet, maîtrisé et intelligible,

- structurer l’information et augmenter la lisibilité

Toujours réfléchir aux intentions des internautes

Comme beaucoup de vérités, il s’agit d’une évidence que l’on oublie facilement. De nos jours, il ne suffit plus de parler convenablement d’un sujet pour trouver grâce aux yeux de Google.

En effet, l’expertise n’est pas la pertinence : en règle générale, connaître un domaine ne suffit pas à résoudre un problème. De son côté, le moteur de recherche adopte de plus en plus le point de vue des internautes, à vous d’en faire de même !

Catégoriser les requêtes est toujours un bon moyen d’y voir clair.

L’utilisateur cherche-t-il une information ?

Une transaction ?

Un lieu où se rendre ?

Selon le thème, la réponse doit-elle être développée ou présentée synthétiquement ?

Sémantique et pertinence

Ensuite, il existe des outils capables de vous aiguiller sur le lexique qu’on attendrait à voir apparaître en fonction des mots-clés qui représentent votre sujet. En vous appuyant sur cette liste de mots, vous pouvez mettre côte à côte des notions étroitement liées.

Toutefois, la pertinence requiert que vous les mettiez explicitement en relation. Si un algorithme comme BERT sait désormais interpréter les prépositions, se contenter de jouer sur des nuages sémantiques tend à devenir proprement inefficace.

De l’autre côté, mieux vaut éviter de tourner autour du pot, et employer relativement souvent les mots-clés qui cadrent votre sujet !

Puisque le mécanisme d’attention soupèse l’importance des termes, vous aurez pour tâche de quadriller vos articles avec des mots stratégiques. Entre sémantique et pertinence, l’on voit bien qu’un équilibre est toujours à trouver.

Lisibilité et structure

Nous l’avons évoqué indirectement, mais ce critère mérite d’être pris en compte : les algorithmes utilisant le NLP ne sont pas parfaits.

C’est d’ailleurs pour cette raison qu’ils font l’objet de mises à jour majeures et récurrentes. En conséquence, ils sont moins efficaces s’ils se heurtent à des textes peu lisibles.

Il ne tient donc qu’à vous de structurer votre contenu avec des titres HTML (H1, H2, etc.) bien hiérarchisés et évocateurs du paragraphe auquel ils se rattachent.

Appliquez le canevas : 1 paragraphe = 1 idée. C’est un peu plus de travail en amont, que d’établir un plan logique aux titres bien répartis, mais les avantages sont bien réels !

Vos questions, nos réponses !

Est-ce que Google utilise déjà l’algorithme SMITH ?

Bien que les chercheurs semblent expliquer que ce nouvel algorithme surpasse les performances de BERT, les déclarations officielles infirment ce genre de rumeurs.

Google SMITH en serait plutôt à la phase de prototype test, et nécessiterait des recherches supplémentaires, malgré la confiance qu’il inspire dans les articles qui lui sont dédiés.

SMITH va-t-il remplacer BERT ?

Ce n’est pas au programme. Il s’agirait plutôt de prendre le relai de BERT pour les tâches concernant spécifiquement les correspondances sémantiques entre des documents de longueur importante.

En quoi consiste la préformation ?

C’est une méthode destinée à former un algorithme à partir d’une base de données. On exerce la machine à prédire des termes ou des blocs de phrases manquants dans un extrait de texte. À terme, l’objectif est de limiter les erreurs à un niveau raisonnable.