Depuis l’arrivée de ChatGPT sur les écrans du grand public, les interrogations sur l’intelligence artificielle pullulent. À quelle vitesse va-t-elle continuer à se développer, quels services rendus, mais aussi quels dangers pour l’humanité, etc. ? Or, s’il y a bien un domaine dans lequel on dialogue quotidiennement avec des IA, c’est bien le SEO.

En effet, le travail des référenceurs est d’anticiper le comportement de machines chargées de classer des pages web par ordre de pertinence en fonction d’une requête saisie par un humain. Afin d’y parvenir, les experts SEO restent à l’affût de toutes les avancées qui permettent à des moteurs de recherche tels que Google ou Bing d’affiner la perspicacité de leurs bots.

Autrement dit, le SEO appelle naturellement à suivre les plus gros investisseurs dans le domaine de l’intelligence artificielle, prêts à débourser des dizaines de milliards de dollars pour demeurer en tête de la course à l’IA. Si seules les années à venir nous diront quelles (r)évolutions connaîtra le monde du référencement, il convient de dresser un état des lieux de la situation actuelle, afin de ne pas rester sur la touche au moment de développer la présence digitale de votre entreprise.

Qu’appelle-t-on “intelligence artificielle” exactement ?

La définition d’”intelligence” ne va déjà pas de soi, alors lui accoler un complément ne va pas forcément rendre les choses plus claires. On peut néanmoins s’accorder sur les points de départ et d’arrivée du chemin parcouru par l’intelligence en action, laquelle part d’un cerveau en mesure de réaliser des tâches abstraites (mémoriser, calculer, imaginer, évaluer, formuler, etc.) pour aboutir soit à la résolution d’un problème bien défini, soit à une erreur.

Dans le cas de l’IA, le point de départ n’est pas un organe, mais une machine. À l’arrivée, on trouve toujours une réponse au problème posé, plus ou moins juste et précise en fonction de la puissance, mais également du niveau d’apprentissage de la machine.

En résumé, l’IA peut être vue comme un substitut à l’intelligence humaine, qui permet de trouver la solution de problèmes très profonds, comme aux jeux d’échecs et de go, ou d’automatiser des tâches simples afin de les réaliser à une vitesse surhumaine (569 x 345 ?). Le principale point différenciant étant que l’origine des questions que l’on cherche à résoudre se trouve exclusivement dans l’esprit humain…

Comment les moteurs de recherche utilisent-ils l’IA ?

On l’a mentionné en introduction : l’IA est le fond de commerce des moteurs de recherche, à commencer par les crawlers, lesquels ont pour tâche d’explorer le web à toute allure pour dénicher des ressources à ranger dans leur index en attendant de les proposer en résultats de recherche. Associés aux filtres algorithmiques, ils parviennent, en suivant un certain nombre de règles et de méthodes préprogrammées, à donner satisfaction à la majorité des internautes.

Aussi n’est-il pas question de savoir si l’IA est impliquée dans le fonctionnement des moteurs de recherche, mais plutôt de connaître leur degré de subtilité, et comment l’on doit en tenir compte chez les référenceurs.

L’enrichissement des SERPs pour une meilleure UX

Depuis déjà quelques années, Google et ses concurrents que sont Bing, Yandex et Baidu, ont intégré des résultats enrichis à leurs SERPs. En effet, les bots sont aujourd’hui capables de comprendre quelles ressources contiennent les sites les plus pertinents et de les présenter sous un autre format que la simple formule “metatitle + metadescription + URL”.

De cette façon, les internautes peuvent obtenir l’information recherchée sans avoir à cliquer davantage, ou bien se diriger vers la page qui semble la plus fournie pour répondre à leur requête. Aussi ont-ils directement accès à des ressources élémentaires par le biais de :

- FAQ et définitions ;

- images et vidéos ;

- tweets et stories ;

- unes d’articles sur l’actualité ;

- infographies ;

- etc.

Cette fonctionnalité n’est évidemment pas nouvelle, et les référenceurs savent bien comment rendre un site éligible à déployer des extraits enrichis pour occuper l’espace de la SERP et augmenter ainsi les chances de clics et de trafic. Néanmoins, ce qui rend cette option vraiment intéressante, c’est le fait qu’elle contribue à transformer un moteur de recherche en moteur de “réponse” !

Le machine learning pour mieux saisir l’intention de recherche des internautes

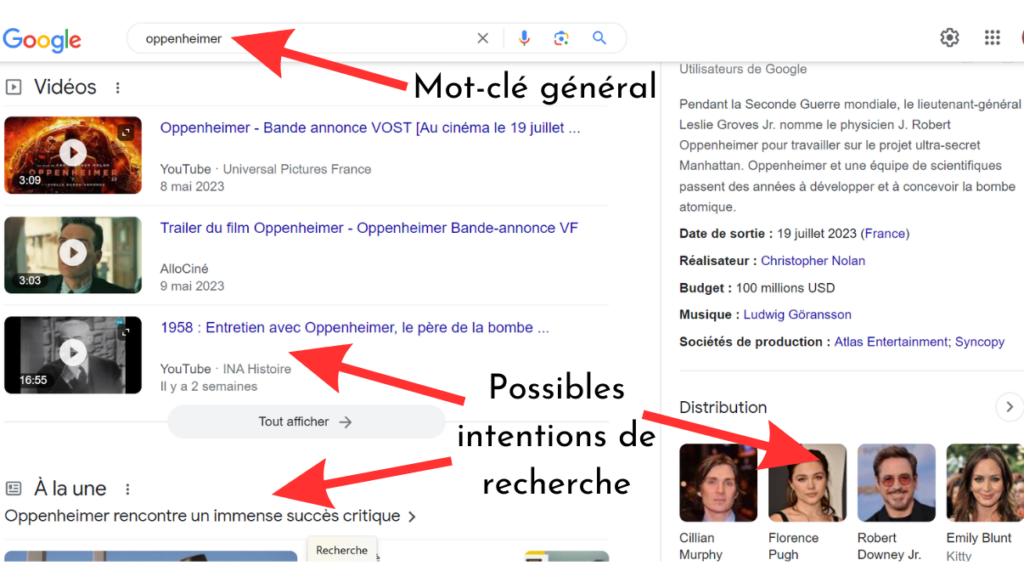

Outre la capacité de l’IA à extraire une information précise sous forme de contenu enrichi depuis les sites placés au top des pages de résultats, elle est de plus en plus capable d’identifier une intention de recherche derrière ce que tapent les internautes dans la barre de saisie.

Tout a commencé avec Google Hummingbird en 2013, puis avec Rankbrain en 2015 et BERT en 2019, trois algorithmes rompus à la compréhension du langage naturel, permettant ainsi au moteur de s’émanciper de la simple évocation répétitive d’un mot-clé stratégique (keyword stuffing). Dès lors, grâce au machine learning, qui utilise une grande quantité de données pour affiner le comportement des algorithmes, les bots ont pu non seulement mieux évaluer la qualité d’un contenu (avec un langage spécialisé maîtrisé, par exemple), mais ont également appris à distinguer plus efficacement le besoin de l’utilisateur.

Dès lors est apparue la notion d’intention de recherche ; les moteurs, et a fortiori les sites SEO friendly, cherchent à répondre à l’idée qui se cache derrière une phrase, un mot-clé ou un mot-clé de longue traîne, en tenant compte du contexte et des requêtes proches sémantiquement.

Par exemple, plus besoin de taper “recette de carrot cake sans oeufs” si vous avez oublié d’en acheter. “Gâteau carotte végétal” suffit à l’algorithme pour vous proposer une longue liste de recettes végétaliennes. Ou bien si vous tapiez “Oppenheimer” en juillet 2023, vous aviez, sous la page wikipédia du célèbre physicien, des résultats sur le dernier film de Nolan (critiques twitter, miniatures de trailers, la page allociné pour connaître les séances, etc.).

Ainsi, chaque page nécessite non seulement un contenu de qualité pour ranker, mais également de traiter de questions plutôt spécifiques, en anticipant le besoin précis de son utilisateur cible.

Des outils de recherche de plus en plus sophistiqués

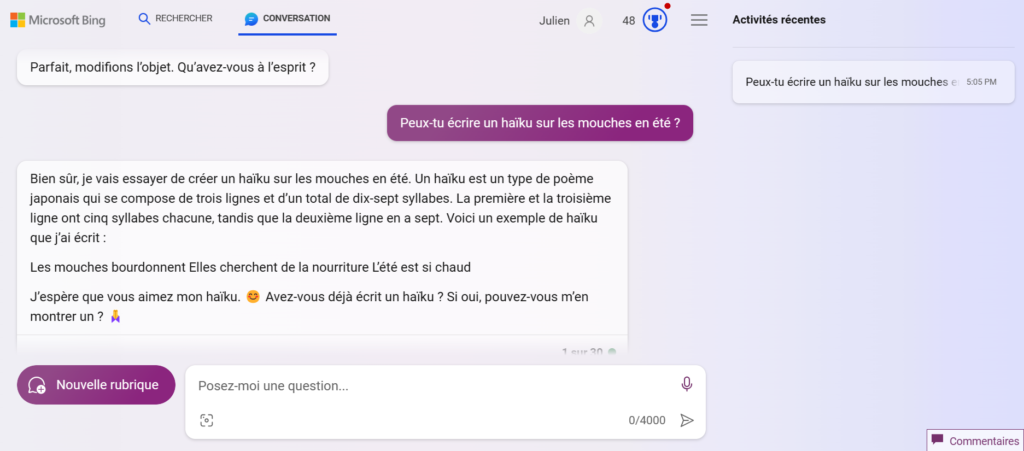

Des pages enrichies, une lecture “entre les lignes” des mots-clés, quoi d’autre ? Des outils de recherche toujours plus intelligents, avec en vedette la version Bing de ChatGPT, qui permet d’interroger le moteur de Microsoft et d’obtenir des informations sous un format conversationnel ! De son côté, Google, un peu à la traîne sur cette affaire-là, développe Bard, un autre générateur de texte qui proposera sans doute les mêmes fonctionnalités que ChatGPT (on y reviendra) !

Dans la même veine, la recherche visuelle a fait d’immenses progrès, comme en témoigne la fonctionnalité de reconnaissance d’image Google Lens, apparue sur appareils Android et IOS (icône en forme d’appareil photo sur la droite de la barre de recherche). Le moteur de recherche vous donne des résultats à partir d’une photo prise avec votre appareil, mais également :

- de combiner des textes aux images pour affiner la recherche ;

- de trier les résultats en fonction de la géolocalisation de votre appareil, afin de donner les meilleures suggestions locales ;

- de faire de la traduction automatique en braquant l’objectif de votre smartphone sur un extrait de texte directement sur l’image ciblée ;

- explorer les alentours en récupérant des informations sur les lieux que vous filmez ;

- trouver des informations sur un produit (prix, lieux de vente, etc.)

- etc.

Avec ces quelques exemples, on voit à quel point les IA nous donnent accès à une grande quantité d’informations qualitatives, avec une fluidité considérée encore impensable il y a de cela 20 ans. L’on peut même entrapercevoir l’ampleur des prochaines avancées. Et la meilleure préparation pour s’y confronter, c’est de faire appel aux mêmes technologies pour promouvoir vos contenus !

Comment tirer profit de l’intelligence artificielle en SEO ?

Bien entendu, le référencement, qu’il soit naturel ou payant, repose en majeure partie sur des principes assez simples : diffuser régulièrement des contenus pertinents au sein d’un domaine parfaitement structuré, obtenir des backlinks d’excellente qualité, toujours surveiller les performances techniques de son serveur, etc.

En effet, les algorithmes sont sensibles à ces critères qui se tournent davantage vers l’UX (User eXperience). Ainsi, en privilégiant la satisfaction de l’utilisateur, vous augmentez vos chances de vous aligner avec leurs exigences. Parce que l’IA de Google ou de Bing a vocation à servir le plus fidèlement possible (et le plus efficacement aussi) l’intérêt des internautes, puisque :

- leur fournir les suggestions les plus pertinentes permet de gagner des parts de marché ;

- afficher des publicités ciblées et personnalisées auprès d’un gigantesque public 0les rend plus attractifs auprès des annonceurs ;

Néanmoins, jouer le jeu des bots ne suffit pas, et il convient désormais de prendre le taureau par les cornes en s’appropriant la puissance des IA.

L’IA pour trouver des mots-clés stratégiques

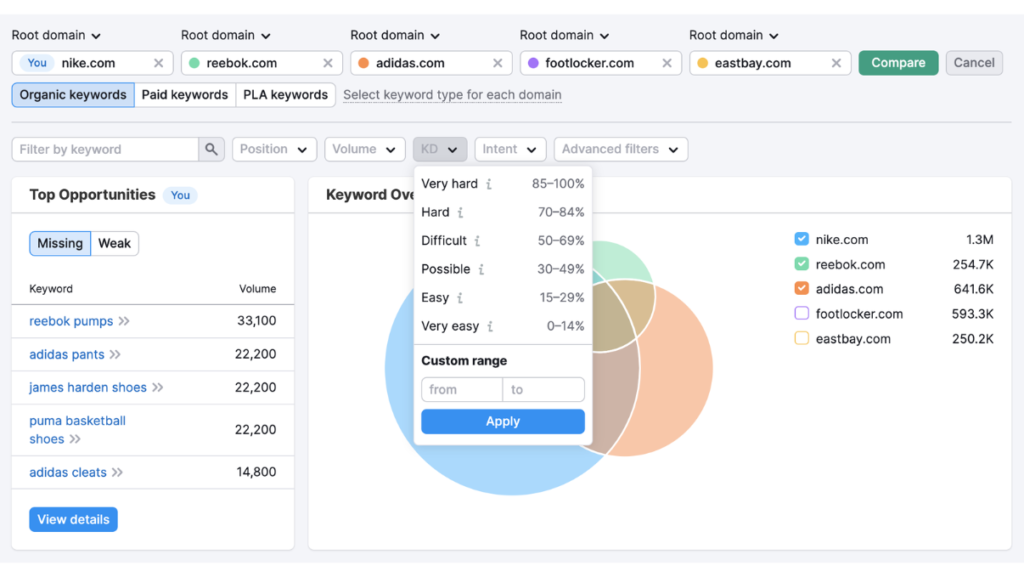

Revenons-en d’abord aux racines du SEO : les mots-clés ! Quand la plupart de vos concurrents présentent des sites web tout à fait acceptables concernant les points évoqués précédemment, il s’agit de s’en démarquer en essayant de ranker sur quelques mots-clés bien choisis, notamment sur ceux de longue traîne (incluant plus de 3 ou 4 termes).

Aujourd’hui, les rédacteurs doivent maîtriser les outils permettant de connaître :

- le volume de recherche sur un mot-clé (avec Keyword surfer ou Keywords everywhere, par exemple) ;

- le niveau de concurrence d’un mot-clé (avec le “Possibilité de mots-clés” de Semrush ou Ubersuggest

- tous les mots-clés principaux et secondaires, mais également les expressions proches qui peuvent les aider à mettre un contenu rédactionnel en valeur (par ex : avec Yourtext.guru);

Grâce à l’apprentissage automatique des algorithmes qui analysent les sites webs les mieux référencés, on peut bénéficier des meilleures recommandations de mots-clés. Idéal pour choisir un thème de contenu et le peaufiner en abordant non seulement tous les points suggérés par les logiciels cités ci-dessus, mais aussi en cherchant comment amener de nouvelles connaissances par rapport à la concurrence.

L’IA pour générer des contenus, les enrichir, les structurer, les optimiser…

Les nouvelles technologies de génération de contenu ont fait couler beaucoup d’encre, qu’il s’agisse de :

- textes, lignes de codes et calculs avec ChatGPT ou Bard ;

- images et visuels avec DALL.E ;

- musiques avec Boomy ou Beatoven ;

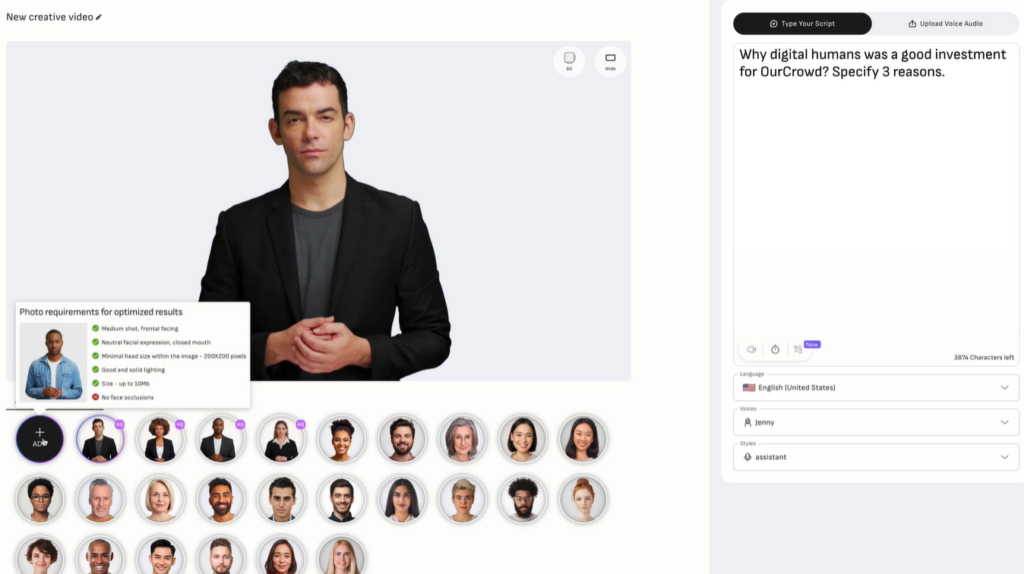

- vidéos avec D-ID.

Aujourd’hui, n’importe qui, ou presque, peut produire du contenu sur à peu près n’importe quel sujet et sous n’importe quel format. En effet, de nombreux logiciels fleurissent autour des IA génératives et se complètent les unes les autres. À titre d’exemple, l’application D-ID converge désormais avec ChatGPT et la reconnaissance vocale : vous pouvez créer un chatbot permettant de converser avec un visage numérisé.

Bien sûr, l’usage “brut” de ces nouvelles technologies n’est pas recommandé : le produit fini nécessite généralement des vérifications et des retouches. Aussi en appelle-t-on à ces logiciels, davantage pour :

- déterminer la structure ou les grandes lignes d’un contenu ;

- trouver de nouvelles idées à exploiter ;

- vérifier l’exhaustivité d’un texte sur n’importe quel sujet ;

- gagner du temps pour élaborer un contenu descriptif, illustratif et explicatif clair et fonctionnel.

Ainsi, il est primordial de se familiariser rapidement avec ce genre d’outils, non pas en leur délégant complètement les tâches à effectuer dans l’espoir d’une automatisation totale de votre contenu stratégique, mais pour mieux voir venir la suite en s’habituant dès maintenant à manipuler l’IA.

L’IA pour obtenir des recommandations SEO précises

Chez Uplix, on se sert de l’intelligence artificielle pour anticiper des tendances de référencement. Cette technique, développée en collaboration avec Oncrawl a été baptisée le “predictive ranking”, qui permet de crawler un site web afin de simuler le comportement des moteurs de recherche concernant n’importe quelle page web vis-à-vis d’une requête spécifique.

Une telle prédiction se fonde sur une multitude de critères SEO, en tenant compte de leur degré d’importance, et ce avec un niveau de détail très avancé. L’outil analyse également la data des sites concurrents afin de mettre en lumière tous les points forts et les faiblesses de chaque candidat au podium des SERPs.

Ainsi, on obtient instantanément les espoirs de ranking d’une page, son potentiel stratégique sur du plus long terme, prévoir le comportement de recherche des internautes et surtout prioriser les efforts d’optimisation à fournir en conséquence, avec un devis à la clé pour connaître le budget à allouer à votre référencement dans une dynamique ROIste.

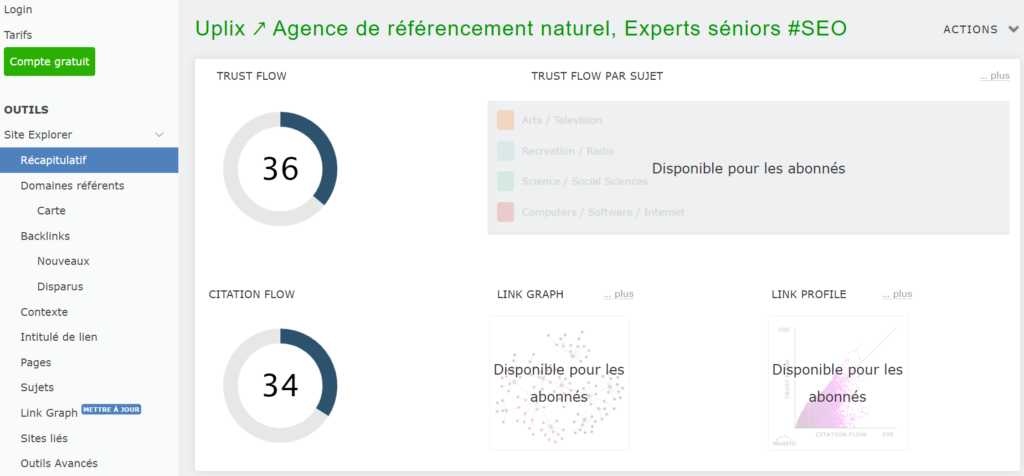

L’IA pour évaluer votre netlinking

Parmi les facteurs de classement les plus importants à surveiller très régulièrement, les backlinks sont une des préoccupations majeures des référenceurs. En effet, non seulement l’autorité d’un site web se nourrit grandement du Link Juice obtenu avec les liens hypertextes entrants, mais, en plus, Google fait la traque aux liens spammy (peu pertinents, menant vers des contenus de faible qualité).

Toutefois, on ne peut connaître l’ensemble des liens qui pointe vers les pages d’un site web qu’en faisant appel à des logiciels spécialisés, tels qu’Ahrefs, Semrush ou encore Majestic SEO, qui vous montrent :

- le nombre et la provenance des backlinks (citation flow) ;

- le trust flow ou la qualité des liens entrants ;

- si les liens sont insérés dans une image ou une ancre texte ;

- l’état du netlinking de vos concurrents directs ;

- etc.

Des analyses très avancées, donc, qui vous donnent la visibilité nécessaire pour choisir la meilleure stratégie de développement de votre netlinking, soit en privilégiant l’Inbound Marketing pour obtenir des backlinks organiques, soit en trouvant des partenaires avec qui négocier des échanges de liens sans provoquer les foudres de Google Penguin.

Les limites de l’intelligence artificielle

L’intelligence artificielle est une technologie fort prometteuse, mais qui n’en est sans doute qu’à ses balbutiements. Sans doute qu’un jour, tout comme un tracteur est capable d’accomplir le travail de 600 agriculteurs ou un laminoir industriel de remplacer 10 millions d’ouvriers, la machine numérique va pouvoir prendre en charge la majeure partie des tâches qui nous occupent encore aujourd’hui sur internet.

Néanmoins, l’outil a toujours besoin d’obéir à la rationalité humaine. On s’en rend compte au regard du SEO, à commencer par l’exploitation de l’IA générative. En effet, un outil comme ChatGPT, s’il est utilisé naïvement par tous les acteurs d’un même secteur, risque de produire du duplicate content, si tout le monde lui demande la même chose. D’autre part, les erreurs factuelles et les imprécisions formelles limitent fortement la fiabilité de ces logiciels.

Autrement dit, si l’IA peut permettre d’augmenter la quantité des contenus, le véritable challenge est de conserver, voire de réhausser le niveau de leur qualité intrinsèque. En conséquence, le temps gagné d’un côté doit être réinvesti de l’autre, avec :

- une attention particulière accordée à l’analyse, aux tests et aux besoins des utilisateurs ;

- la supervision des ressources obtenues, en vérifiant certaines informations, en les complétant (enrichissement, hiérarchisation, corrections, synthèse, approfondissement, etc.) et en y imprimant la patte de votre ligne éditoriale ;

- un soin tout particulier apporté à la structure des sites web ;

- une mise à jour plus régulière des informations délivrées au grand public, en recherchant toujours l’innovation ;

- une veille des derniers logiciels et applications qui peuvent révolutionner votre manière de travailler ;

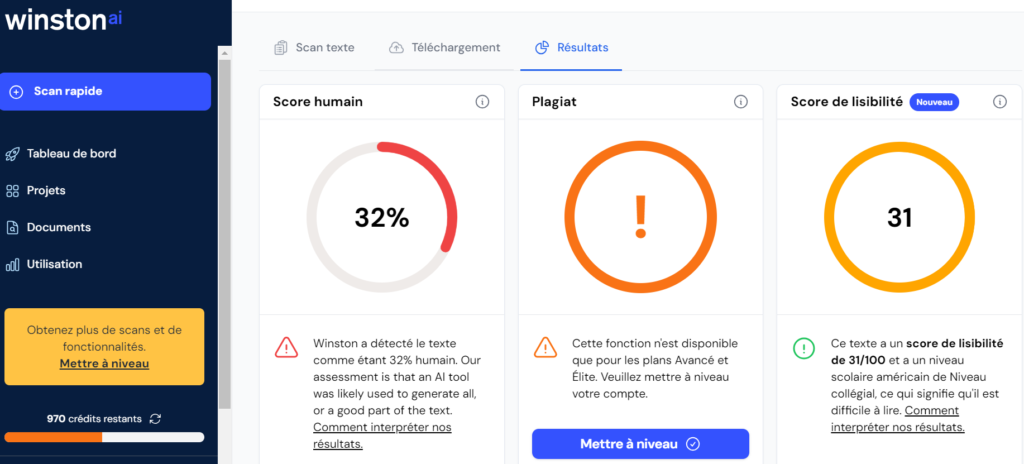

Sans ce travail, les IA seules ne sont actuellement pas en mesure de satisfaire des algorithmes tels que l’EAT de Google (pour Expertise, Authoritativeness et Trustworthiness). En outre, il existe déjà des outils capables d’identifier des contenus générés par une intelligence artificielle (Winstonai ou Draft&Goal).

C’est donc un pli à prendre aussi bien pour vous que pour vos collaborateurs. Les profils réfractaires ou qui, au contraire, ont tendance à tout déléguer à la machine auront sans doute du mal à s’adapter aux besoins prochains d’une entreprise.

Enfin, les outils d’analyse mentionnés plus haut ne doivent pas vous amener à tenter une manipulation abusive des algorithmes. En effet, le black hat SEO est plus que jamais dans le viseur des moteurs de recherche. Aussi, toutes les questions ayant trait à la confidentialité et à la réglementation doivent être prises en compte quand vous exploitez une IA (ex : attention aux visages que vous voulez utiliser avec D-ID !).

En résumé, les IA en SEO, c’est…

Un ensemble d’outils en plein essor dont les performances augmentent à grande vitesse. Ces derniers permettent de créer du contenu, d’optimiser des mots-clés, d’analyser des données, voire d’obtenir des liens. Néanmoins un équilibre reste à trouver et à maintenir entre les ambitions humaines et l’intervention de la machine.

On rappellera, pour illustrer qu’un joueur de go de niveau intermédiaire a trouvé comment mettre en déroute AlphaGo, grâce à une feinte qui n’aurait leurré aucun joueur humain. Preuve que si la puissance de calcul est désormais l’apanage des ordinateurs, la subtilité, l’intuition, la sagacité, enfin le pragmatisme demeurent les serviteurs captifs de l’esprit organique.

Vos questions, nos réponses !

L’intelligence artificielle va-t-elle supprimer les métiers du référencement ?

Entre les outils de génération de contenu et les logiciels d’analyse, l’on pourrait penser que le SEO est désormais une affaire de machines. Néanmoins, à bien observer les évolutions de Google ou de Bing, on se rend compte que l’UX (User eXperience) est devenue partie intégrante du référencement naturel (d’où le nouveau sigle SXO).

Or, la clé de voûte de l’UX, c’est l’empathie, qui permet d’anticiper, de comprendre et de répondre précisément au besoin des utilisateurs. Ainsi, les métiers du SEO ne risquent pas de disparaître, mais de déplacer et de spécialiser ses compétences vers le besoin humain.

Quels sont les meilleurs outils d’intelligence artificielle à utiliser en SEO ?

Parmi les centaines d’outils qui exploitent la puissance des IA, les plus utiles en SEO sont ceux qui :

– analysent et suggèrent des mots-clés sur lesquels ranker (ex : Semrush) ;

– évaluent le potentiel de référencement d’un contenu et comment l’optimiser (ex : Yourtext.guru) ;

– produisent des textes, des images et des vidéos (ex : ChatGPT, Dall.E, D-ID) ;

– vérifient le netlinking autour d’un site web (ex : Majestic SEO) ;

– produisent des analyses de logs (ex : Screaming Frog) ;

– prédisent le classement d’une page en indiquant ses forces et ses faiblesses (ex : Predictive Ranking).

Quelle réglementation pour les IA ?

Le parlement européen classifie les IA par niveau de risque (inacceptable, élevé et limité). Le degré le plus haut touche gravement aux libertés individuelles (ex : score social). Le deuxième degré menace la sécurité et le droit fondamental des individus, et le dernier touche à la transparence (ex : deepfakes). En SEO, lorsqu’on utilise un logiciel pour analyser le trafic d’un site web (ex : les cookies) ou une IA générative pour son contenu, l’utilisateur doit en être informé afin de conserver un jugement éclairé sur le contenu qu’il consomme et le niveau de confidentialité dont il bénéficie.